109. (Septiembre 2020) Música y entropía - III

109. (Septiembre 2020) Música y entropía - III |

|

|

|

| Escrito por Paco Gómez Martín (Universidad Politécnica de Madrid) | |

| Jueves 10 de Septiembre de 2020 | |

1. IntroducciónEn la primera entrega de esta serie [Góm20b] estudiamos la relación entre la entropía y la música de una manera general. En la segunda entrega [Góm20a] repasamos los modelos de Markov (ya vistos también en otras entregas([Góm16b], [Góm16a]). En este tercera entrega vamos examinar a fondo el tratamiento que hacen de la entropía los autores Gerardo Febres y Klaus Jaffe en su artículo del año 2017 Music viewed by its entropy content: A novel window for comparative analysis [FJ17]. En su trabajo, los autores estudian cómo aplicar la entropía a la caracterización del estilo musical de una manera más completa y significativa que en estudios previos. El artículo empieza con una larga introducción donde, con erudición pero sin pesadez, revisan a fondo el estado del arte en el problema del estudio de la entropía en música. Evidentemente, empiezan mencionando a Meyer [Mey56] con su teoría de las expectativas y los grandes continuadores de sus ideas (como Huron [Hur06]). Identifican la entropía como una medida de regularidades estadísticas y como tal, cuando se aplica al fenómeno musical, permite extraer características musicales en base a dichas regularidades. Febres y Jaffe evalúan los principales esfuerzos de investigación en este sentido. Examinan, por ejemplo, los métodos basados en cadenas de Markov y apuntan a Mavromatis como uno de sus practicantes más notables [Mav05] (como vimos el mes pasado). Como método alternativo a las cadenas de Markov, los autores mencionan a Rohrmeier [Roh11], quien propone un método basado en reglas gramaticales inspirado en las teorías generativas de Lerdahl y Jackendorf [LJ83]. La entropía necesita como base un alfabeto de símbolos. En el caso de la música ese conjunto sería los símbolos que aparecen en la partitura entera. Sin embargo, para calcular medidas de entropía hace falta codificar la música en un alfabeto adecuado. Muchos investigadores han usado la codificación MIDI, que es una opción bastante natural por su versatilidad y por constituir una aproximación aceptable a la música. Ponce de León e Iñesta [PI07] usaron música en formato MIDI que analizaron a través de la entropía; su análisis incluía varios parámetros musicales tales como altura de las notas, duración de las notas, duración de los silencios, síncopas, entre otros. El corpus que usaron fue de jazz y era polifónico (muchos de los primeros estudios con entropía se limitaban a la música monofónica). Kranenburg y Backer [vKB04] diseñaron un procedimiento para reconocer el estilo a través de la entropía, pero, aunque prometedor, no alcanzaron a construir un sistema que reconociese estilos de manera fiable. Metodológicamente, la mayor parte de los trabajos han usado cadenas de Markov, como el mencionado de Mavromatis. Una excepción notable a esta tendencia es el trabajo de Cox [Cox10], que usa redes neuronales. En un futuro artículo de esta sección, abordaremos las redes neuronales y su aplicación a la música. Por el momento, nos conformaremos con describir el trabajo de Cox desde un punto de vista general. Respecto a la entropía y el significado musical, Cox escribe lo siguiente (nuestra traducción):

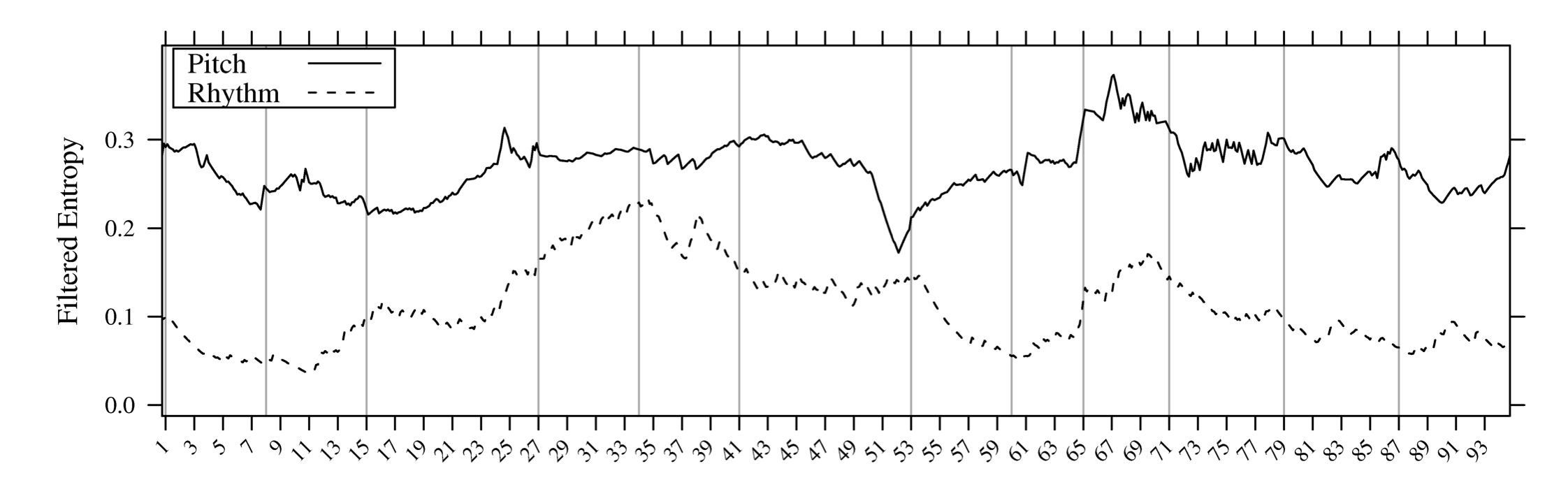

El mérito de Cox es que usando redes neuronales fue capaz de producir unos perfiles de entropía que le sirvió para estudiar el estilo musical. En la figura 1 se ve un ejemplo de dichos perfiles. En su artículo analizó el cuarteto para cuerda opus 20, número 3 (los perfiles de abajo pertenecen al primer movimiento). En la figura se ven perfiles de entropía para las alturas y el ritmo; el eje x son los compases del movimiento.

Figura 1: Perfiles de entropía (figura tomada de [Cox10])

La hipótesis musicológica aquí es que música que pertenece a un estilo concreto debería tener unos perfiles de entropía característicos, los cuales permitiría distinguir entre estilos. Esfuerzos anteriores en este sentido habían generado perfiles que eran demasiado bastos como para tal distinción. El trabajo de Cox representa un paso adelante en ese sentido, pero el trabajo de Febres y Jaffe constituye un paso mayor aun. Ellos usan tres medidas relacionadas con la entropía (diversidad específica, entropía y entropía de segundo orden) para estudiar el estilo musical. 2. Estilo musical y entropía2.1. Perfiles de entropíaFebres y Jaffe aplican la idea de los perfiles de entropía para analizar el estilo musical y en particular para resolver el problema de distinguir entre estilos musicales. Para ello, tomaron una muestra de 450 piezas en formato MIDI y estudiaron el estilo con la entropía. El alfabeto base para su estudio es el propio alfabeto del formato MIDI. La música está caracterizada por varias variables musicales: altura, duración, melodía, armonía, textura, etc. El propósito de un modelo es identificar la estructura (bloques y sintaxis) de la música en base a los valores de las variables musicales. Esa estructura se manifiesta como regularidades estadísticas en las cadenas de símbolos que representan la música. Esas regularidades representan normas estilísticas. La búsqueda de esas regularidades se llama reconocimiento de patrones. En su modelo se busca minimizar la entropía según está definida por Shannon; véanse [Góm20b], [Góm20a]. De nuevo, este modelo se basa en el modelo de longitud de descripción mínima de Mavromatis [Mav05]. Se extraen del corpus una serie de símbolos que minimizan la entropía (o se acercan al mínimo dentro de un margen). Dicha extracción va acompañada de una distribución de probabilidad. Véamos más en detalle cómo ocurre esto. Empezaremos por considerar el conjunto B de símbolos MIDI que aparecen en un corpus musical (o en una pieza). A continuación, se extrae un conjunto mínimo de símbolos que minimizan lo más posible la entropía de Shannon [Sha10]. Este conjunto recibe el nombre de símbolos fundamentales y D será el número total de dichos símbolos fundamentales. D es la diversidad del lenguaje. De la observación de las piezas del corpus se obtiene la frecuencia de cada símbolo xi, que será una distribución de probabilidad P(xi). Si N es el número total de símbolos de B, se define la diversidad específica como el cociente d

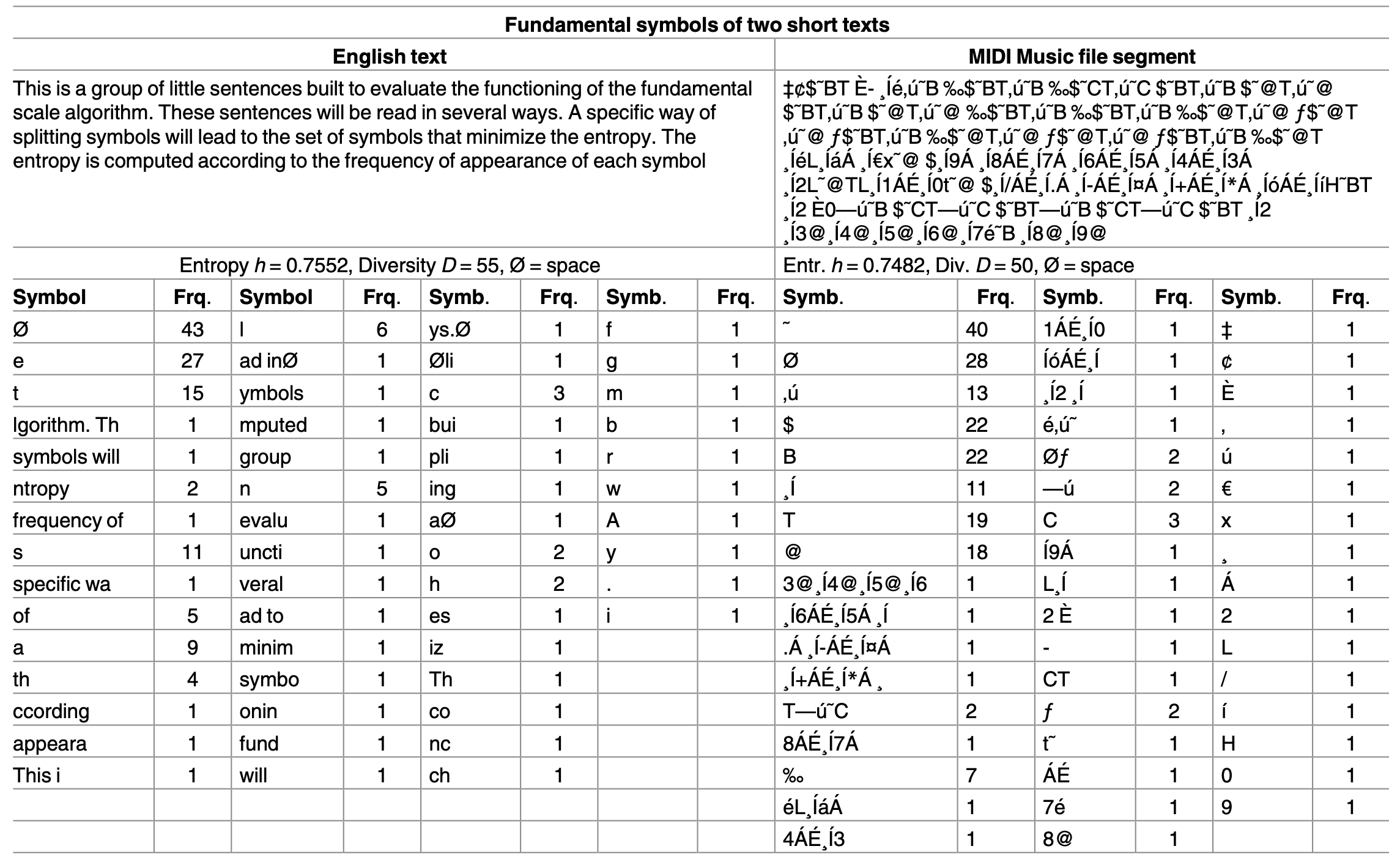

La entropía h viene dada por la fórmula h = -P log D(P). En su artículo, los autores comparan un breve texto en inglés con un segmento de un fichero MIDI para ilustrar cómo opera la entropía. Reproducimos aquí dicha comparación; véase la figura 2 (en el fichero de texto ∅ representa el espacio).

Figura 2: Perfiles de entropía (figura tomada de [FJ17])

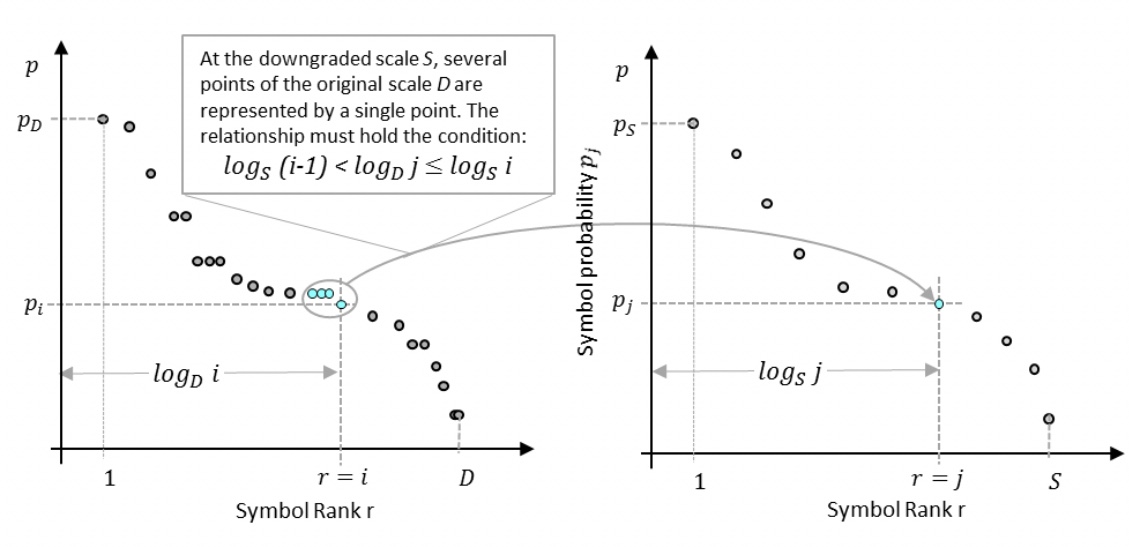

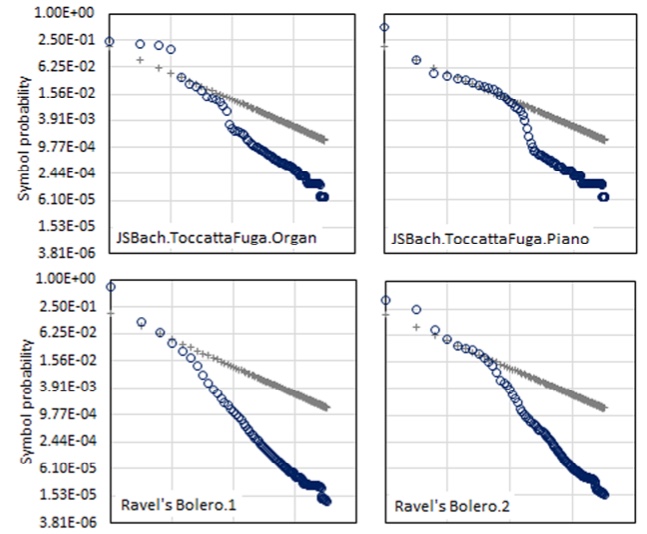

A continuación, Febres y Jaffe crean los llamados perfiles de frecuencias. Para cada distribución P, los autores asocian un perfil. El perfil está compuesto por una gráfica de los símbolos ordenados por frecuencia relativa decreciente en el eje x contra dichas frecuencias en el eje y; véase la figura 3. El perfil resulta ser una poligonal decreciente (pero no estrictamente decreciente en todos los casos). Distintos perfiles pueden tener distintos número de símbolos en sus descripciones. Eso da un problema a la hora de comparar los perfiles, ya que los perfiles no serán comparables a menos que tengan la misma longitud. Los autores resuelven esta dificultad usando lo que han bautizado como un método de reducción de escala. En este método reducen el número de símbolos mientras que mantienen el vector de frecuencias. El método lleva a cabo fusiones de símbolos y redistribuye adecuadamente las frecuencias entre los nuevos símbolos. En la figura 3 se ilustra este proceso; la condición para la fusión de símbolos está dada en la parte de la izquierda; para más información matemática sobre este procedimiento, consúltense los apéndices del artículo de Febres y Jaffe.

Figura 3: Fusión de símbolos (figura tomada de [FJ17])

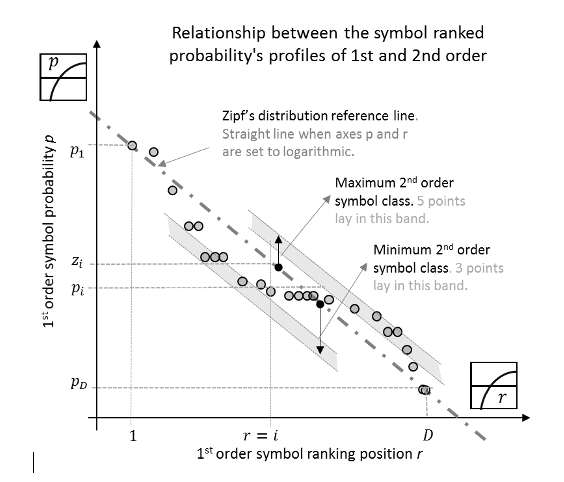

Para la comparación, se considera que la música tiene el mismo comportamiento que el lenguaje y se aplica la ley de Zipf para comparar perfiles. La ley de Zipf es una ley empírica que establece que en una lengua dada la frecuencia de aparición de las palabras sigue una distribución de tipo potencial, esto es, la frecuencia de la n-ésima palabra más frecuente es proporcional a 1∕na, donde a es un parámetro fijo que depende de la lengua en particular (a suele ser mayor que 1). Otra manera de enunciar la ley de Zipf es decir que una palabra es inversamente proporcional a su rango en la tabla de frecuencias de palabras. Cuando se dibuja la gráfica en escala logarítmica (log-log), la ley de Zipf se manifiesta como una recta decreciente. Es posible comparar los perfiles de frecuencias con el perfil de referencia (perfil de Zipf). En general, se pueden comparar dos perfiles arbitrarios entre sí. En efecto, sean fr,gr las frecuencias de dos perfiles dados para los símbolos que están en la posición r y sea S el número total de símbolos. La distancia E entre los perfiles viene dada por

Si se quiere comparar con el perfil de Zipf, basta hacer gr =

Figura 4: Perfiles de frecuencia de los símbolos

2.2. Entropía de orden superiorLa novedad que presenta Febres y Jaffe es la idea de una entropía de segundo orden. La entropía habitual la llaman entropía de primer orden y está dada por la fórmula h = -P log D(P), como vimos más arriba. Esta entropía se usa para ver cuánto se desvía el perfil de frecuencias de los símbolos del ideal de la ley de Zipf (la línea recta). Sabemos que cuanto más uniformes sean las frecuencias más alta es la entropía (de primer orden). Esto, sin embargo, es insuficiente para discriminar la complejidad de una pieza. La entropía de segundo orden se centra en los huecos entre las frecuencias de los símbolos en orden con respecto a la distribución dada por la ley de Zipf. Por tanto, detecta los cambios de pendiente en el perfil de las probabilidades de los símbolos. Para el cálculo de esta entropía de segundo orden, se definen las probabilidades Zi, donde i varía en el número de símbolos, como Zi =

Figura 5: Entropía de segundo orden

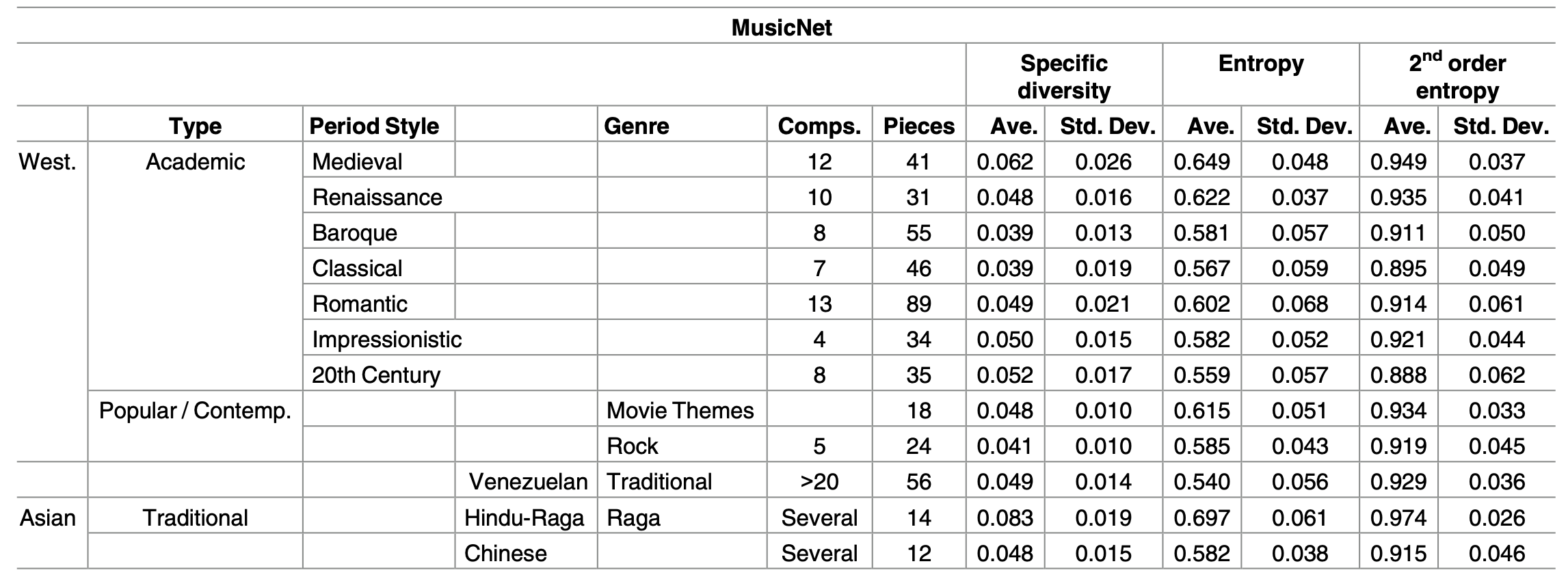

La tabla de abajo muestra los resultados obtenidos calculando los dos tipos de entropía. El término MusicNet que vemos en la tabla se refiere a la clasificación de los estilos estudiados en el trabajo. Por ejemplo, la música occidental se divide en académica y popular/contemporánea, y cada una de estas categorías se divide en otras subcategorías. Dado que las entropías son esperanzas de variables aleatorias, los autores dan los valores medios junto con las desviaciones típicas para evaluar la dispersión.

Figura 6: Medidas de diversidad, entropía y entropía de segundo orden

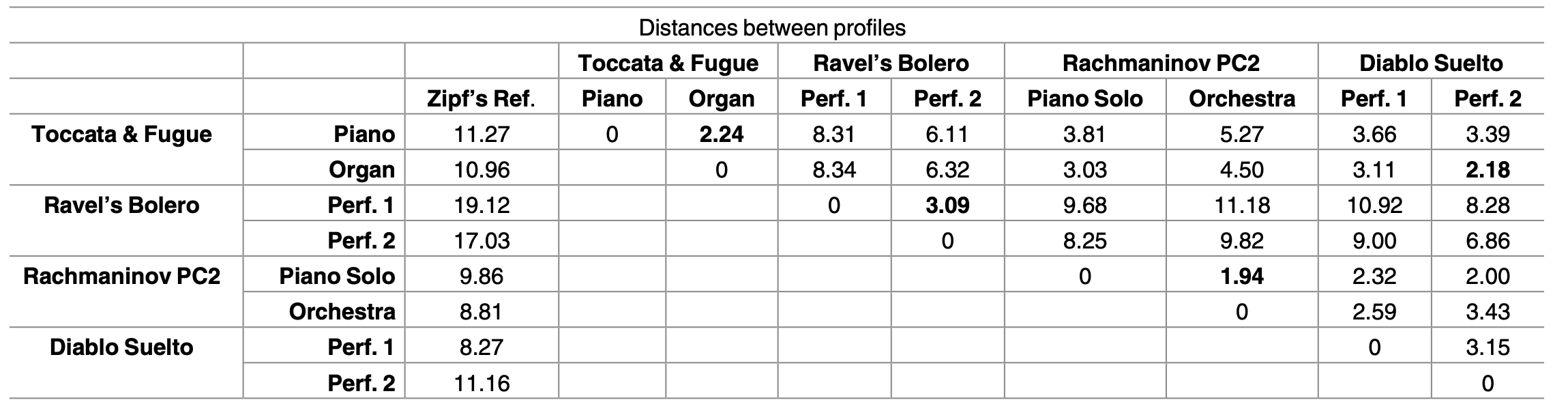

A partir de los datos de la tabla anterior y tomando como referencia la ley de Zipf, es posible calcular la distancia entre piezas musicales, como muestra la siguiente tabla. En este caso vemos incluso la distancia entre dos interpretaciones de la misma pieza, la tocata y fuga en re menor de Back interpretada al órgano y al piano. También vemos la comparación entre distintas interpretaciones de piezas de diversa índole.

Figura 7: Distancias entre piezas

Una vez que se obtienen las distancias entre las piezas se pueden estudiar aspectos interesantes tales como la agrupación (a través de árboles filogenéticos, por ejemplo) o tendencias. Febres y Jaffe proponen tres medidas de complejidad, la diversidad específica, la entropía y la entropía de segundo orden que, combinadas entre ellas, llegan al estudio del estilo más de lo que trabajos previos habían logrado. En su artículo, usando estas medidas, comparan distintos estilos musicales de los cuales llegan a identificar algunas regularidades estadísticas. La lección que sacamos del trabajo de Febres y Jaffe es que el estilo es un fenómeno complejo y que hay que estudiarlo con un arsenal diverso y profundo de medidas estadísticas. Bibliografía[Cox10] G. Cox. On the relationship between entropy and meaning in music: An exploration with recurrent neural networks. In Proceeding Annual Meeting of the Cognitive Science Society, Portland, USA, August 2010. [FJ17] G. Febres and K. Jaffe. Music viewed by its entropy content: A novel window for comparative analysis. PLoS ONE, 12(10):1–30, 2017. [Góm16a] P. Gómez. Música y Probabilidad (II), diciembre de 2016. [Góm16b] P. Gómez. Música y Probabilidad (I), noviembre de 2016. [Góm20a] P. Gómez. Música y Entropía - II, agosto de 2020. [Góm20b] P. Gómez. Música y Entropía - I, julio de 2020. [Hur06] David Huron. Sweet Anticipation. MIT Press Books, Massachusetts, 2006. [LJ83] F. Lerdahl and R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983. [Mav05] P. Mavromatis. A hidden markov model of melody production in greek church chant. Computing in Musicology, 14:93–12, 2005. [Mey56] Leonard Meyer. Emotion and Meaning in Music. University of Chicago Press, Chicago, 1956. [PI07] P. J. Ponce de Leon and J. M. Iñesta. Pattern recognition approach for music style identification using shallow statistical descriptors. IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), 37(2):248–257, 2007. [Roh11] M. Rohrmeier. Towards a generative syntax of tonal harmony. Journal of Mathematics and Computation in Music, 5:35–53, 2011. [Sha10] C. E. Shannon. A Mathematical Theory of Communication. Bell System Technical Journal, 27:379–423, 623–656, julio, octubre 2010. [vKB04] P. van Kranenburg and E. Backer. Musical style recognition–a quantitative approach. In Conference on Interdisciplinary Musicology (CIM04), pages 1–10, Graz, Austria, Abril 2004. |

| © Real Sociedad Matemática Española. Aviso legal. Desarrollo web |