Home » Cultura y matemáticas » Música y matemáticas

Música y matemáticas

El objetivo de esta sección es comprender la interesante y profunda relación de las Matemáticas con la Música.

Nuestro sincero agradecimiento a Francisco Gómez Martín (Universidad Politécnica de Madrid) por organizar y desarrollar esta sección, a sus anteriores responsables Rafael Losada y Vicente Liern, así como a todas las personas que colaboran con la misma.

Resultados 71 - 80 de 130

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

¿Qué es una paradoja? Si algo caracteriza una paradoja es la capacidad de sumirnos en un estado de perplejidad, el cual suele ir seguido de una disposición a resolver la aparente contradicción. El diccionario de la Real Academia de la Lengua [Rea14] trae varias acepciones de la palabra paradoja. En primer lugar habla de “idea extraña u opuesta a la común opinión y al sentir de las personas”. En efecto, una paradoja siempre causa extrañeza porque desafía la lógica en su sentido más habitual, porque nos muestra una situación bajo una luz diferente y cuyos resultados nos son inesperados. Enfrentados a una paradoja siempre tenemos la sospecha de que estamos en presencia de una trampa. La paradoja es más potente cuanta más perplejidad causa en nosotros. En la siguiente acepción, la RAE habla de “una aserción inverosímil o absurda, que se presenta con apariencias de verdadera”. Y he aquí una segunda característica de las paradojas: han de ser aparentemente contradictorias. El diccionario de la RAE quizás se excede en esta definición cuando dice que la aserción es absurda o inverosímil. Hay paradojas —sobre todo en matemáticas—que no fueron absurdas en su momento y que mostraron serias grietas en los fundamentos de las matemáticas; piénsese en las paradojas de Russell, de las que hablaremos más abajo. Las paradojas, empero, no se limitan a las matemáticas. Las hay lógicas, psicológicas, filosóficas, físicas, biológicas, lingüísticas y musicales, entre otras; véase [Wik14] para una lista más larga de ellas. En la columna de este mes vamos a examinar las paradojas matemáticas y las paradojas musicales.

2. Paradojas matemáticas

2.1. Las paradojas de Zenón de Elea

Las paradojas de Zenón de Elea (490-430 a.C.) se cuentan entre las más conocidas en matemáticas. Estas paradojas tienen consecuencias matemáticas y filosóficas; véanse [Sai09] y [Pal08] para más información sobre este filósofo y sus paradojas. Como ejemplo, vamos a presentar en la columna de este mes la paradoja de Aquiles y la tortuga.

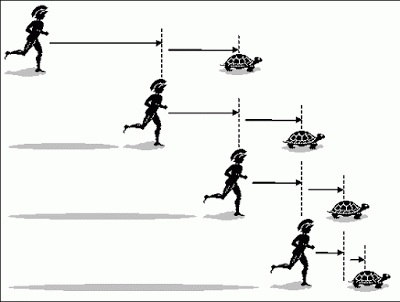

Aquiles es un famoso guerrero aqueo por la velocidad de su carrera hasta tal punto que es conocido como “el de los pies ligeros”. Entre sus hazañas se cuenta haber matado al príncipe troyano Héctor durante la guerra de Troya. La paradoja propone una carrera entre el rápido Aquiles y una tortuga. Para equilibrar la carrera, la tortuga cuenta con una ventaja inicial. La carrera empieza y Aquiles corre raudo y veloz y en poco tiempo alcanza el punto en que estaba la tortuga al inicio de la carrera. Sin embargo, la tortuga ya no está allí. En el tiempo que ha empleado Aquiles en recorrer esa distancia, la tortuga ha avanzado un cierto trecho. Aquiles corre, otra vez raudo y veloz, hasta ese nuevo punto solo para encontrarse con que la tortuga ya no está, ha seguido avanzando. Cada vez que Aquiles llega a un nuevo punto, la tortuga ya no se encuentra allí. Este proceso se repite todo el tiempo. Llegamos a la conclusión de que Aquiles, por muy raudo que sea, nunca alcanzará a la tortuga. En la figura 1 se ilustra la paradoja.

Figura 1: La paradoja de Aquiles y la tortuga (figura tomada de [Rub14]).

Como vemos, la paradoja provoca perplejidad, pues nuestra experiencia cotidiana nos dice que no ocurre lo que describe la paradoja. Sabemos que hay algo que no funciona, pero ¿qué es? Hay varias maneras de explicar la paradoja y señalar dónde está el error en la paradoja. Hay una explicación filosófica y es la de advertir que la paradoja de Zenon confunde el espacio real con su modelo matemático. Para fijar ideas, supongamos que Aquiles es diez veces más rápido que la tortuga y que la distancia inicial entre Aquiles y la tortuga era de 10 metros. Después de n pasos Aquiles se encontrará a una distancia de . Cuando n sea muy grande, esa cantidad en el mundo matemático es todavía positiva, pero en el mundo real eso significa que Aquiles ya ha alcanzado a la tortuga.

Desde el punto de vista estrictamente matemático la paradoja se puede explicar también usando series numéricas. Teniendo en cuenta la distancia inicial y la velocidad de Aquiles, la distancia que recorre Aquiles viene dada por la siguiente suma:

La serie infinita que aparece es la suma de una progresión geométrica de razón menor que uno, la cual es convergente. Tenemos entonces que:

que es una cantidad finita. Por tanto, la suma infinita de números puede dar un resultado finito. La paradoja nos estaba haciendo creer que eso era imposible y que, por tanto, Aquiles nunca alcanzaría a la tortuga. Sin embargo, los cálculos anteriores desenmascaran la paradoja.

2.2. Las paradojas autorreferenciales

Las paradojas autorreferenciales son aquellas que se derivan de enunciados que se refieren a sí mismos. La historia de estas paradojas es instructiva e interesante. A finales del siglo XIX hubo una escuela de pensamiento matemático, el formalismo, que concebía las matemáticas únicamente como un sistema formal basado en axiomas y demostraciones. Hoy en día se acepta mayoritariamente que las matemáticas tienen como características la abstracción, las demostraciones y las aplicaciones (véanse [AKL12, Sna79] para más detalles sobre las posibles definiciones de matemáticas). Obviamente, el formalismo enfatizó la segunda característica, las demostraciones. Durante un cierto tiempo los formalistas creyeron que la lógica y la teoría de conjuntos, tal cual estaban definidas entonces, constituirían los fundamentos de las matemáticas. Entonces aparecieron una serie de paradojas que les hicieron replantearse esa idea. Una de ellas fue la paradoja del barbero de Bertrand Russell.

La paradoja va como sigue. Hay una ciudad donde hay un único barbero, que resulta ser un hombre. En esa ciudad misteriosa no hay hombres que se dejen barba. Para afeitarse hacen una de las dos cosas siguientes: o bien se afeitan a sí mismos o bien acuden a la barbería para afeitarse. Además el barbero solo afeita a aquellos que no se afeitan a sí mismos. La pregunta es quién afeita al barbero. Si el barbero se afeita a sí mismo, caemos en una contradicción, ya que el barbero no afeita a quien se afeita a sí mismo. Si declaramos al barbero como miembro del conjunto de los que no se afeitan a sí mismo, por las condiciones del problema, tendría que ir a la barbería a que le afeitaran. Pero entonces se afeitaría a sí mismo y ya hemos visto que eso es contradictorio. La paradoja del barbero pone de manifiesto que no es posible definir un conjunto cuya definición se refiera a sí mismo.

Relacionadas con esta paradoja están las paradojas lógicas consistentes en enunciados cuyo valor de verdad no se puede establecer. Por ejemplo, ”esta frase es falsa”, es un ejemplo clásico (la paradoja del mentiroso). Estos enunciados no son objeto de la lógica de proposiciones, la cual requiere que todo enunciado que participe en un razonamiento sea susceptible de determinarse su valor de verdad.

La autorreferencia o circularidad ha aparecido en otros campos como la literatura o las artes plásticas. Escher la usó mucho; abajo tenemos una famosa litografía suya tratando este tema.

Figura 2: Drawing hands, de M. Escher.

2.3. Las paradojas relativas a conjuntos infinitos

A veces la paradoja no es tal, sino el producto de un sesgo cognitivo. La idea de que el todo es mayor que sus partes nos parece natural e incontestable. En realidad, eso solo ocurre para conjuntos finitos. Con los conjuntos infinitos las cosas siempre son más divertidas. Consideremos el siempre inocente y familiar conjunto de los números naturales ℕ. Ilustraremos sus curiosas propiedades a través de la paradoja del Gran Hotel debida a Hilbert (véase, por ejemplo, [Gar89, Dek14]).

El Gran Hotel es un hotel especial; tiene infinitas habitaciones, infinitas del tipo de los números naturales (el lector ya me entiende). Estamos en el fin de semana en que se celebra el aniversario del nacimiento de Martin Gardner, el ya conocido Celebration of Mind, y el hotel se encuentra totalmente lleno. No queda ni una sola habitación libre. Su recepcionista, Adolfo Diligente, es el ser más servicial que quepa imaginar, amén de un amante de las matemáticas. Cerca del mediodía llega Maryam Mirzakhani, la medalla Fields de 2014. Entre tanta entrega y homenaje, olvidó hacer la reserva y ahora no tiene habitación. Preguna, compungida, a Adolfo qué puede hacer él. Este, que la admira profundamente, responde resueltamente a su petición.

— No se preocupe, señora Mirzakhani, estamos en el Grand Hotel, un hotel infinito donde los haya, y aquí hay solución para todos los problemas. Mire lo que haré. Pediré a cada huésped que se vaya a la habitación siguiente a la suya. Esto nos dejará la habitación número uno libre para usted. Esta es, señora Mirzakhani, una de las mejores del hotel —y Adolfo sonrió cálidamente al tiempo que dejaba ver sus blancos dientes—.

— Gracias, Adolfo. Nunca olvidaré esto —dijo la señora Mirzakhani con una expresión sincera—.

Adolfo se sumió en sus quehaceres y aunque fijaba su atención en ellos se sentía secretamente feliz por haber tenido la oportunidad de hablar con una matemática de la talla de la señora Mirzakhani.

Al poco entró un grupo de viajeros. Se identificaron como matemáticos que iban a asistir a la Celebration of Mind, pero, igual que la señora Mirzakhani, habían olvidado reservar habitación. El resto de los hoteles de la ciudad eran finitos y todos, que también estaban llenos, les habían mandado al Grand Hotel, el único hotel infinito en la zona. Amablemente preguntaron a Adolfo si algo se podía hacer. Adolfo, mientras hablaba con el portavoz del grupo, los contó disimuladamente. Es un número finito, pensó, y eso se puede arreglar.

— Estimados señores, veo que su grupo consta de 25 personas. Dado que este hotel es infinito, les puedo acomodar. Pediré a cada huésped que amablemente se cambia a la habitación que marca su número más 25, salvo la primera habitación. En ella se aloja la señora Mirzakhani y no se la puede molestar, ya me comprenden ustedes —el grupo de viajero asintió con seriedad—. Tienen ustedes las habitaciones de la 2 a la 26. Permítanme su documentación, por favor.

Y así fue como Adolfo acomodó a este grupo. Dos horas más tarde, cerca de la hora del aperitivo, cuando los infinitos huéspedes departían relajadamente en el infinito salón del Grand Hotel (hotel infinito para huéspedes infinitos, claro), un nuevo grupo de viajeros llegó. Pero esta vez el grupo era diferente: era un grupo infinito de personas. Este grupo de matemáticos absortos habían tratado de probar un teorema y tal fue la concentración que pensaron que habían reservado el hotel, pero, de hecho, solo fue una intención que nunca se materializó.

Adolfo escuchó educadamente la historia de los infinitos matemáticos. Luego hizo la siguiente pregunta:

— Señor, el infinito de ustedes, ¿es numerable?, esto es, ¿es el infinito de los números naturales? En otro caso, me temo que nada podría hacer.

— Venimos en número infinito numerable, señor; nos podemos poner en biyección con los números naturales, sí, en efecto.

Adolfo sonrió e informó que sus habitaciones estarían listas después de comer. De momento, los condujo a la consigna para que dejasen sus maletas allí. Durante la comida pediría a los huéspedes que se mudasen a la habitación cuyo número es el doble de la que ahora tienen. De este modo se quedarían libres un número infinito de habitaciones. Ese infinito es numerable y, por tanto, los nuevos huéspedes cabrían. Sentía tener que mover a la señora Mirzakhani, pero estaba seguro de que era comprensiva.

Y hasta aquí nuestra versión de la paradoja del infinito. Como vemos, la paradoja apela a la intuición bastante común de que las partes son más pequeñas que el todo, pero se resuelve en cuanto estudiamos mínimamente las propiedades de los conjuntos infinitos. Se sabe que los números pares tiene el mismo cardinal que el propio conjunto ℕ; en realidad, el conjunto de los múltiplos de cualquier número k ∈ ℕ fijo tiene el mismo cardinal que ℕ.

3. Paradojas musicales

Hay varias paradojas en el mundo de la música. Vamos a describir una de las más conocidas, la paradoja del tritono, que fue descubierta por la psicóloga de la música Diana Deutsch [Deu86]. En su página web tiene un artículo excelente, donde explica con mucho detalle la paradoja y sus consecuencias; consúltese [Deu14]. Para un buen artículo de divulgación sobre las paradojas, véase Paradoxes of musical pitch [Deu92] de la la misma autora.

La paradoja del tritono presenta dos sonidos producidos uno después del otro y separados por un tritono, esto es, exactamente por la mitad de una octava. Cuando estos sonidos se tocan en sucesión ascendente ocurre que a veces se oyen como descendentes (el primer sonido es más agudo que el segundo) cuando en realidad se han tocado ascendentes (el primer sonido es más grave que el segundo). Esto no pasa en todas las ocasiones ni con todos los sujetos, pero a Deutsch le pareció que merecía la pena investigarlo.

Para ello diseñó un experimento en que presentó a los sujetos una sucesión de intervalos de tritono que primero subían y luego bajaban. Cuando un sujeto percibía que el intervalo subía, dibujaba una flecha hacia arriba; en caso contrario, dibujaba una flecha hacia abajo. El experimento se repitió varias veces con los mismos sujetos y los mismos patrones melódicos. En la figura 3 tenemos los resultados de un sujeto en particular. La gráfica muestra el porcentaje de veces que el sujeto oyó el patrón melódico como descendente. Uno esperaría que la gráfica tomase dos valores solo, 0 y 100, pero en lugar de eso vemos que hay una curva que indica que ciertos intervalos ascendentes se oyen como descendentes. Deutsch conjeturó que este fenómeno no se da uniformemente y que depende de los tonos en particular.

Figura 3: Experimento asociado a la paradoja del tritono.

También conjeturó que esa circunstancia varía de un sujeto a otro y que está relacionada incluso con la procedencia geográfica, la posesión de oído absoluto, la lengua madre o los patrones del habla a que estamos acostumbrados o expuestos. En la figura 4 vemos los resultados de otro sujeto. Son muy diferentes a los del sujeto de más arriba. Ahora la confusión en la dirección melódica ocurre cerca de de otros tonos, en este caso do# y re. Las gráficas de las dos figuras parecen casi complementarias.

Figura 4: Experimento asociado a la paradoja del tritono.

4. Conclusiones

En este artículo hemos examinado las paradojas en las matemáticas y en la música. La naturaleza de las paradojas en música es de tipo cognitivo. La sorpresa viene de que nuestro sistema cognitivo percibe un estímulo de modo incorrecto, pero nada podemos hacer al respecto (Deutsch incluyó músicos en sus experimentos y eso no cambió los resultados). En el caso de las matemáticas, las paradojas se pueden resolver bien ofreciendo explicaciones más finas (como en el caso de las paradojas de Zenón de Elea o del infinito) o bien fortaleciendo los matemáticas en sí (como en el caso de las paradojas autorreferenciales).

Bibliografía

[AKL12] A.D. Aleksandrov, A.N. Kolmogorov, and M.A. Lavrentiev. Mathematics: Its Content, Methods and Meaning. Dover Publications, 2012. Primera edición en 1956.

[Dek14] Jeff Dekofsky. The Infinite Hotel Paradox. http://ed.ted.com/lessons/the-infinite-hotel-paradox-jeff-dekofsky/, consultado en octubre de 2014.

[Deu86] D. Deutsch. A musical paradox. Music Perception, 3:275–280, 1986.

[Deu92] D. Deutsch. Paradoxes of musical pitch. Scientific American, 267:88–95, 1992.

[Deu14] D. Deutsch. Tritone paradox. http://deutsch.ucsd.edu/psychology/pages.php?i=206, consultado en octubre de 2014.

[Gar89] Martin Gardner. ¡Ajá! inspiración. Editorial Labor, 1989.

[Pal08] John Palmer. Zeno of Elea. Stanford Encyclopedia of Philosophy. Springer, 2008.

[Rea14] Real Academia de la Lengua. Diccionario de la RAE. http://lema.rae.es/drae/?val=paradoja, consultado en octubre de 2014.

[Rub14] Rosa Rubicondior. Xeno’s Religious Paradox. http://rosarubicondior.blogspot.com.es/2011/11/xenos-religious-paradox.html, consultado en octubre de 2014.

[Sai09] R. M. Sainsbury. Paradoxes. Cambridge University Press, 2009.

[Sna79] Ernst Snapper. The Three Crises in Mathematics: Logicism, Intuitionism and Formalism. Mathematics Magazine, 52(4):207–216, 1979.

[Wik14] Wikipedia. List of paradoxes. http://en.wikipedia.org/wiki/List_of_paradoxes, consultado en octubre de 2014.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

En la columna de octubre cerramos el ciclo sobre la teoría generativa de la música tonal de Fred Lerdahl y Ray Jackendoff. La expusieron en su libro A Generative Theory of Tonal Music [LJ83], publicado en 1983 (en castellano se publicó en 2003 por Akal [LJ03] con traducción de Juan González-Castelao). En los tres primeros artículos ([Góm14a], [Góm14b] y [Góm14c]) hemos glosado la teoría de estos autores en cuanto a sus aspectos descriptivos y formales. Examinamos cómo Lerdahl y Jackendoff describen el agrupamiento y la métrica y presentan las reglas de formación correcta y de preferencia. En este último artículo vamos a entrar en los aspectos analíticos de su libro. En un solo artículo de la extensión habitual de esta columna no podríamos tratarlo en suma profundidad. Daremos una visión de conjunto y remitiremos al lector interesado a los capítulos cinco a diez del libro.

1. Las reducciones en música

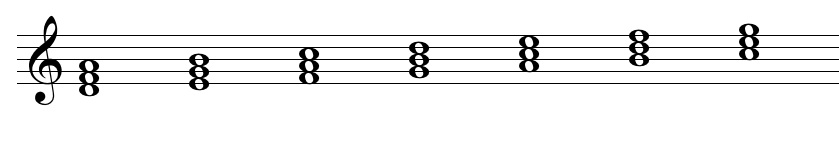

La música que escuchamos es el resultado de la compleja interacción entre sus elementos, que son múltiples: ritmo, melodía, armonía, conducción de voces, timbre, textura, forman, etc. Una manera muy frecuente de analizar la música es la reducción. Por reducción se entendemos una eliminación de los elementos no esenciales de manera que nos permitan comprender la música en cuestión. Son típicas las reducciones de una partitura orquestal a piano solo o piano a cuatro manos. En esas reducciones se eliminan los instrumentos que doblan una voz y se recoge únicamente aquel material que nos permite reconocer la pieza como tal, con la mayor parte de su personalidad (hay que alcanzar un equilibrio, pues toda reducción implica cercenar en parte el original). Hay una gran tradición de reducciones en la música tonal como instrumento de análisis. Quizás uno de los más conocidos es el análisis schenkeriano; véase [FG82] para más información. En la figura siguiente se ve una reducción de un conocido coral de Bach.

Figura 1: Reducción de un coral de Bach (figura tomada de [LJ83]).

Como el lector ya se habrá dado cuenta, no hay criterios absolutos a la hora de hacer una reducción; un problema similar aparece en la transcripción musical. Diferentes músicos pueden presentar diferentes reducciones de una misma pieza. En su libro Lerdahl y Jackendoff presentan una serie de criterios para llevar a cabo las reducciones y, por ende, el análisis musical. Esos criterios están en buena parte basados en factores psicológicos.

Como primer paso, los autores formula su hipótesis de reducción. Esa hipótesis establece que el oyente siempre intenta organizar los eventos tonales en un todo coherente de manera que estos se oigan de manera jerárquica. Una vez aceptada esta hipótesis, la reducción consistiría en detectar esa estructura y proceder a una simplificación paso a paso de la música. Lerdahl y Jackendoff, no contentos con esta primera hipótesis de reducción, la enriquecen con dos nuevas condiciones:

Los eventos tonales se oyen en estricta jerarquía según se describe en la teoría de los autores (véase [Góm14b]).

Los eventos que son estructuralmente menos importantes no se oyen como simples elementos aislados, sino en relación específica a eventos de más importancia.

Volviendo a la figura 1, esta debería leerse de arriba abajo y “cada paso debería sonar como una simplificación natural del anterior” (página 108, [LJ83]). En este punto los autores advierten de una posible confusión conceptual entre importancia estructural y prominencia musical. Con frecuencia ambas coinciden, pero no siempre. Solo la primera, la importancia estructural, es la base de las reducciones que se proponen en la teoría generativa. Por ejemplo, en la partitura de arriba, de la figura 1, el acorde de sol es prominente por la distribución de las voces, pero no tiene una importancia estructural grande y, de hecho, en la segunda reducción ya no aparece. Lerdahl y Jackendoff no desprecian la importancia musical o analítica de los eventos prominentes; sencillamente, las reducciones están pensadas para extraer la estructura generativa —gramatical, diremos—de la música.

2. Las reducciones de la teoría generativa

Lerdahl y Jackendoff rechazan el análisis schenkeriano, basado también en reducciones, por no ser un análisis como tal sino una interpretación hasta cierto punto subjetiva de la música; no obstante, reconocen la importancia del análisis schenkeriano en su momento y los caminos que abrió. Los autores se fijan como objetivo dar un conjunto de criterios para hacer las reducciones y que estos reflejen en la medida de lo posible la experiencia del oyente. Para ello, toman prestado de la lingüística la notación de árbol (si bien avisan que solo es la notación que toman prestada y que hay sustanciales diferencias en significado de estos árboles en ambas disciplinas).

Veamos cómo se construyen estos árboles y su uso como herramienta de análisis musical. Dados dos eventos tonales x e y, si y es una elaboración de x, entonces y es una rama derecha en el árbol tal y como se muestra en la figura 2 (a). Aquí se entiende que el evento y es subordinado al evento x. Si la situación contraria se produce, esto es, que x es una elaboración de y, entonces nos encontramos con una rama izquierda, como muestra la figura 2 (b). Por último, cuando no hay relaciones de dominancia clara entre los dos eventos se produce una ramificación central, como la mostrada en la figura 2 (c).

Figura 2: Ramificaciones en los árboles de reducciones (figura tomada de [LJ83]).

Huelga decir que, de acuerdo a la hipótesis de reducción formulada más arriba, estas ramificaciones tienen que cumplir con las reglas de formación correcta expuestas hasta ahora. Los árboles tienen que cumplir con las restricciones de no solapamiento, adyacencia y recursión que vimos en los tres primeros artículos de esta serie. En la figura 3 (a) a (d), vemos una serie de árboles que violan algunas de las reglas de formación correcta. Por ejemplo, en los árboles de (a) y (b) se ve que el principio de no solapamiento no se respeta puesto que hay cruces entre las ramas de los árboles. En el árbol (c) tenemos que un mismo evento tiene más de una rama, situación que está prohibida también. Finalmente, en (d) vemos un evento aislado que no recibe rama, y eso está prohibido igualmente. Los árboles (e) a (h) son árboles correctos.

Figura 3: Ejemplos de árboles de reducción (figura tomada de [LJ83]).

En la figura 4 podemos apreciar la reducción del coral de Bach más arriba junto con su correspondiente árbol de reducción. Los niveles de abstracción crecen según se va desde las hojas o nodos finales del árbol hasta su raíz.

Figura 4: Un coral de Bach junto con su árbol de reducción (figura tomada de [LJ83]).

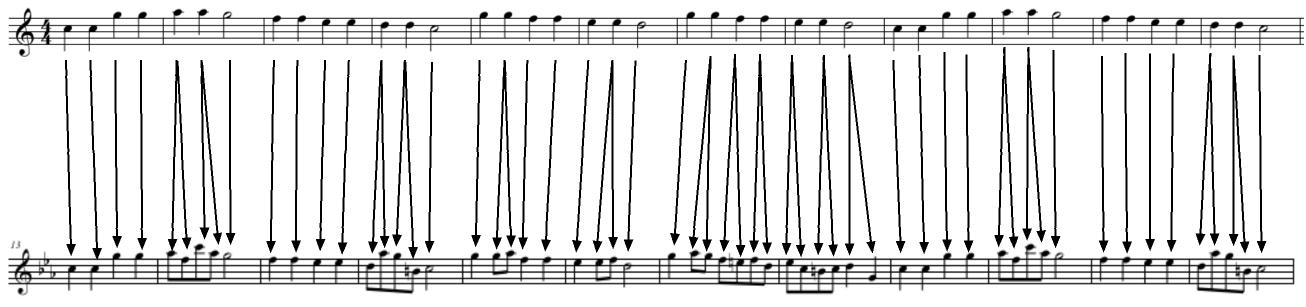

Lerdahl y Jackendoff pronto se dan cuenta que su método de análisis se quedaría corto si sus métodos de reducción se basasen únicamente en criterios tonales. Indudablemente, hay muchos aspectos musicales de importancia subordinados al ritmo o al menos cuya interacción con el ritmo desempeña un papel esencial. En consecuencia, agrupamiento y métrica se incorporan al modelo de reducciones. En la figura 5 tenemos la primera frase de la sonata número 11 en la mayor KV. 331 de Mozart con el árbol de reducción y la estructura métrica y de agrupamiento en la parte de abajo.

Figura 5: Análisis de una frase (figura tomada de [LJ83]).

Por último, Lerdahl y Jackendoff sentían que el modelo tal cual estaba especificado hasta aquí tenía todavía serias limitaciones. En particular, notaban que no explicaba la música en un sentido más horizontal. Ciertamente, explicaba con detalle los eventos tonales pero a cierto nivel local, digamos, a nivel de segmento. No explicaba, sin embargo, cómo fluía la música de un segmento a otro. Los autores ampliaron su sistema de reducción introduciendo un nuevo tipo de reducciones, las llamadas reducciones de prolongación. Por falta de espacio, en este artículo no entraremos en la descripción de las reducciones de prolongación (véanse los capítulos 8 y 9 de su libro).

3. Conclusiones

En estos cuatro artículos hemos hecho un recorrido sucinto por la A Generative Theory of Tonal Music de Lerdahl y Jackendoff, obra en la que se presenta una formalización de la música tonal y su análisis. En esa formalización hemos encontrado elementos típicamente matemáticos. Ha habido voluntad de abstracción, la cual se ha construido desde un procedimiento inductivo; ha habido afán de rigor; y hemos evidenciado una voluntad de autocrítica constante (en ese sentido el texto muestra muy claramente el camino mental que ha llevado a los autores a la construcción de su teoría). Asimismo, hemos visto en la teoría objetos tan matemáticos como recursión (en la descripción del agrupamiento y la métrica), la especificación de una sintaxis y, en general, de una gramática. Esto es muy similar a, por ejemplo, definir un lenguaje formal en computación o describir la lógica proposicional o de predicados.

Incluso aunque la formalización detrás de la teoría generativa no haya sido muy alta, es indudable que hay pensamiento matemático en su construcción. Es un ejemplo más de dónde podemos encontrar matemáticas en la música.

Bibliografía

[FG82] A. Forte and S.E. Gilbert. Introduction to Schenkerian Analysis. W. W. Norton and Co., 1982.

[Góm14a] F. Gómez. Teoría generativa de la música - I, consultado en julio de 2014.

[Góm14b] F. Gómez. Teoría generativa de la música - II, consultado en junio de 2014.

[Góm14c] F. Gómez. Teoría generativa de la música - III, consultado en septiembre de 2014.

[LJ83] F. Lerdahl and R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983.

[LJ03] F. Lerdahl and R. Jackendoff. Teoría generativa de la música tonal. Akal, 2003. Traducción de Juan González-Castelao Martínez.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

Tras el descanso de verano, continuamos con la tercera entrega de la serie sobre la obra de Fred Lerdahl y Ray Jackendoff A Generative Theory of Tonal Music [LJ83], publicada en 1983 (en castellano se publicó en 2003 por Akal [LJ03] con traducción de Juan González-Castelao). En el primer artículo de la serie [Góm14b] examinamos la génesis de esta obra y sus fundamentos teóricos generales junto con su base matemática. En el segundo artículo [Góm14a], estudiamos el agrupamiento y la métrica así como las reglas de formación del agrupamiento y las reglas de preferencia del agrupamiento. En este tercer artículo estudiaremos aquellos fenómenos que, según los autores, permiten al oyente reconocer una estructura métrica en el flujo musical (considerado este como el resultado final de todas los parámetros musicales juntos: melodía, conducción de voces, ritmo, armonía, textura, etc.). Tal y como ocurrió en el artículo anterior, las reglas se dividirán en dos tipos, las reglas de formación correcta de la métrica (RFCM de aquí en adelante) y las reglas de preferencia de la métrica (RPM por abreviar). Las RFCM describen las estructuras métricas que son posibles y las RPM especifican los criterios bajo los cuales un oyente considera más estables las estructuras métricas.

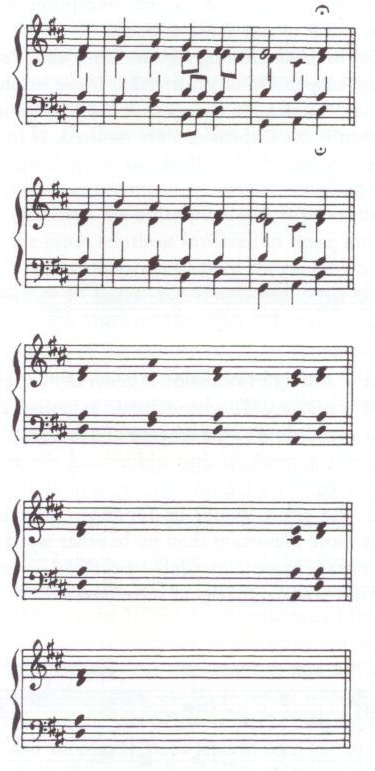

Antes de continuar, recordamos al lector que una parte en un cierto nivel que lo es también a un nivel superior se dice que es parte fuerte; en otro caso, se dice que la parte es débil. En la figura siguiente, por ejemplo, las partes 2, 5, 8 y 11 son partes fuertes al nivel de la corchea y las partes 2 y 8 son fuertes al nivel de la negra con puntillo y la blanca con puntillo. En cambio, las partes 3, 4, 6, 7, 9, 10 son partes débiles. No todas las partes fuertes tienen que serlo a todos los niveles.

Figura 1: Partes fuertes y débiles (figura tomada de [LJ83]).

1. Reglas de formación de la estructura métrica

Las reglas formuladas por Lerdahl y Jackendoff en el capítulo 4 de su libro son fundamentalmente reglas extraídas de la observación empírica, como podremos comprobar enseguida.

RFCM 1: Cada punto de ataque debe estar asociado con un tiempo en el nivel más bajo de la estructura métrica. RFCM 2: Cada parte en un nivel métrico dado tiene que ser una parte en los niveles inferiores a él. RFCM 3: En cada nivel métrico, las partes fuertes están a distancia entre sí de o bien dos partes o bien tres partes. RFCM 4: La distancia entre las partes de cada nivel métrico debe ser constante.

La primera regla establece que no hay puntos de ataque fuera de la malla proporcionada por la estructura métrica. Como es natural, el problema de los adornos o los valores irregulares no está contemplado en esta regla. Más adelante los autores tratan este problema.

La regla RFCM 2 refleja la estructura jerárquica de la métrica de la música tonal. En el ejemplo de la figura 2, parte (b) , se puede apreciar una violación de esta regla en la cuarta nota, que tiene ausencia de un tiempo en un nivel inferior de la métrica. La asignación de los tiempos en la métrica de la figura, parte (a), es correcta según la regla RFCM 2.

Figura 2: Ilustración de la regla RFCM 2 (figura tomada de [LJ83]).

La regla RFCM 3 establece nada más y nada menos que las subdivisiones de los tiempos solo pueden ser binarias y ternarias. En una gran parte de la música occidental esto es así, al menos en la música clásica del periodo de la práctica común (en la música tonal) y en la música popular moderna.

La regla RFCM 4 observa un hecho fundamental de la música tonal aquí analizada: descansa sobre una malla isócrona de pulsos regulares. La métrica se organiza alrededor de estos pulsos con un sistema de acentos recurrentes.

Cualquier lector con un mínimo de experiencia musical (bien como oyente atento o como intérprete) caerá en la cuenta de que estas reglas pecan venialmente de estrictas. Por ejemplo, en rigor sabemos que los pulsos no son regulares en todas las ocasiones. Pensemos en el rubato expresivo tan frecuente e importante en la música clásica. Incluso sin ir a algo tan patente como el rubato, basta considerar las microvariaciones rítmicas que se producen en toda interpretación y que caracterizan las interpretaciones musicales (opuesto, por ejemplo, a las interpretaciones de música hechas por ordenador).

Los mismos autores son conscientes del exceso de rigor descriptivo de las reglas y ponen el siguiente ejemplo (véase la figura 3) para ilustrar la necesidad de relajar esas reglas y hacerlas más fieles a la realidad musical. La presencia de las semicorcheas, que son meras notas de paso aquí, fuerzan una estructura métrica demasiado extensa, cuando en realidad no es necesario; la figuración rítmica gravita en torno a las corcheas con puntillo, las negras y las corcheas.

Figura 3: Niveles métricos del comienzo de la sonata KV 331 de Mozart (figura tomada de [LJ83]).

En pasajes como el de la figura 4, comunes en la música tonal, encontramos subdivisiones métricas dentro de la misma frase. La aplicación de las reglas anteriores, tal cual están formuladas, produciría una estructura métrica ciertamente farragosa, que por encima de todo no se correspondería con la escucha del oyente. El oyente no percibiría el pasaje de la figura con una métrica cuyas partes son el mínimo común múltiplo de sus partes binarias y de sus partes ternarias. Antes al contrario, interpretará, de manera natural, como que tiene una alternancia de estructuras métricas.

Figura 4: Música con diferentes subdivisiones (sonata para clarinete de Brahms) (figura tomada de [LJ83]).

Lerdahl y Jackendoff resuelven este problema introduciendo el concepto de tactus. El tactus es el nivel métrico más prominente y al cual típicamente se asocia el tempo con que el director conduce o con el que de modo natural seguimos el ritmo (con el cuerpo, dando palmas, etc.). El tactus suele ser situarse en un tempo medio. Si el tempo de la obra es rápido, el tactus tiene una figuración de notas largas; si, en cambio, es lento, la figuración es de notas cortas.

Con ayuda del tactus los autores refinan las reglas dadas más arriba. La nueva premisa es que el tactus debe ser constante, pero en función del contexto musical ciertos niveles métricos se pueden descartar, aquellos que están muy lejos del tactus, normalmente más allá de tres niveles métricos por arriba y por abajo. Las nuevas reglas RFCM 1 y RFCM 2, ahora refinadas, son las siguientes:

RFCM 1 (refinada): Cada punto de ataque tiene que estar asociado a una tiempo en el nivel métrico más pequeño que haya en ese momento preciso en la pieza. RFCM 2 (refinada): Cada parte de un nivel determinado debe ser parte en todos los niveles inferiores que haya en ese momento preciso de la pieza.

Empero, el refinamiento de estas dos reglas no soluciona el problema planteado por la pieza de Brahms más arriba (figura 4). Con el siguiente refinamiento de la regla RFCM 4 Lerdahl y Jackendoff solucionan ese caso.

RFCM 4 (refinada): El tactus y los niveles métricos inmediatamente superiores deben estar formados por partes cuya distancia sea constante en una pieza dada. En los niveles inferiores al del tactus, las partes débiles deben tener una distancia constante entre las partes fuertes.

2. Reglas de preferencia de la estructura métrica

Asociadas a una misma pieza musical varias estructuras métricas son posibles. Los autores ilustran este punto con un fragmento de la sinfonía número 40 de Mozart (figura 5). Cada una de las posibilidades métricas cumple las reglas de formación correctas de la métrica enunciadas más arriba. Entonces ¿cuál elegir como la más adecuada para describir la escucha de esta pieza por un oyente ideal? He aquí cuando entran en juego las reglas de preferencia de la métrica (RPM). Con estas reglas los autores quieren modelizar cómo escucha la música su oyente ideal. Es interesante hacer notar que Lerdahl y Jackendoff hablan constantemente del oyente ideal. Ese oyente lo tienen ellos en mente y es producto de su experiencia musical, pero tal oyente no ha sido caracterizado de modo empírico, esto es, ellos no llevaron a cabo experimentos para contrastar hasta qué punto su oyente ideal compartía características con el oyente real.

Figura 5: Varias posibles estructuras métricas asociadas a una misma pieza (figura tomada de [LJ83]).

De las tres posibles estructuras métricas presentadas abajo, Lerdahl y Jackendoff concluyen que es la primera la que mejor se ajusta a la intuición de su oyente ideal. Para formalizar tal decisión enuncian las reglas de preferencia de la métrica, que son las siguientes:

RPM 1 (paralelismo): Allá donde dos o más grupos o partes de grupo se puedan construir con paralelismo, recibirán preferiblemente una estructura métrica que refleje ese paralelismo. RPM 2 (parte fuerte pronto): Prefiérase relativamente una estructura métrica en que la parte fuerte de un grupo aparezca pronto en el grupo. RPM 3 (eventos): Prefiérase una estructura métrica en la cual un parte en el nivel Ni que da lugar a un evento tonal sea parte fuerte en Ni. RPM 4 (acento): Prefiérase una estructura métrica en la cual las partes en el nivel Ni que tienen acento son también partes fuertes en el nivel Ni. RPA 5 (duración): Prefiérase la estructura métrica en la que los tiempos relativamente fuertes tengan lugar al comienzo de: (a) o bien un evento tonal relativamente largo, (b) o bien de una duración relativamente larga de una dinámica, (c) o bien de una ligadura relativamente larga, (d) o bien de un patrón de articulación relativamente largo, (e) o bien de una duración relativamente larga de una nota en varios niveles métricos, (f) o bien de una duración relativamente larga de una armonía en varios niveles métricos.

La primera regla es bastante intuitiva. Nuestro oído tiende a percibir como similares aquellos grupos que poseen paralelismo entre sí y esto se extiende de manera natural a la estructura métrica.

Para la segunda regla los autores dan el siguiente ejemplo (la coda de la obertura Leonora de Beethoven). En él, observamos una secuencia formada por una escala descendente. La escala tiene longitud seis, pero en la realización de la séptima escala —marcada con un asterisco en la figura —encontramos que tiene longitud siete. A pesar de ello, se percibe la primera nota de cada escala como el tiempo fuerte a causa del salto interválico ascendente.

Figura 6: Segunda regla de preferencia de la métrica (figura tomada de [LJ83]).

Con respecto a la tercera regla, el ejemplo anterior sirve para su análisis. La regla RFCM 3 exige que las partes fuertes estén igualmente espaciadas. Eso no ocurre en muchas ocasiones, en el ejemplo anterior sin ir más lejos. La regla RPM 3 establece que se debe preferir una estructura métrica de modo que se minimice la quiebra de RFCM 3.

La regla RFCM 4 establece se debe preferir una métrica en que los acentos fenoménicos (véase [Góm14b]) caigan sobre las partes fuertes y que, si ello no es posible, también se minimicen las excepciones.

La regla RFCM 5 propone que la estructura métrica sea tal que los tiempos fuertes caigan sobre aquellos fenómenos musicales de longitud relativamente larga. Lerdahl y Jackendoff hacen un análisis detallado de dichos fenómenos, que van desde los eventos tonales hasta el ritmo armónico (de ahí lo prolijo de esta regla).

3. Conclusiones

Las reglas que hemos analizado en este capítulo siguen la misma filosofía que encontramos en su momento en reglas del agrupamiento. Lerdahl y Jackendoff describen primero unas reglas de formación correcta, que intentan formalizar los fenómenos observados en la práctica musical, y más tarde dan reglas de preferencia, que tratan de definir qué estructuras métricas son más naturales en la percepción de la música tonal. De nuevo, la descripción de estas reglas está hecha de manera no matemática, aunque de hecho admitirían una descripción matemática.

En el siguiente artículo de la serie, el último, estudiaremos el sistema analítico de Lerdahl y Jackendoff, el cual se basa en las reglas examinadas en estos tres primeros artículos.

Bibliografía

[Góm14a] F. Gómez. Teoría generativa de la música - I, consultado en julio de 2014.

[Góm14b] F. Gómez. Teoría generativa de la música - II, consultado en junio de 2014.

[LJ83] F. Lerdahl and R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983.

[LJ03] F. Lerdahl and R. Jackendoff. Teoría generativa de la música tonal. Akal, 2003. Traducción de Juan González-Castelao Martínez.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

Esta es la segunda entrega de la serie sobre la obra de Fred Lerdahl y Ray Jackendoff A Generative Theory of Tonal Music [LJ83], publicada en 1983 (en castellano se publicó en 2003 por Akal [LJ03] con traducción de Juan González-Castelao). En el primer artículo de la serie [Góm14] examinamos la génesis de esta obra y sus fundamentos teóricos. En este artículo estudiaremos el agrupamiento y la métrica en primer lugar; a continuación, veremos cómo es la interacción entre ambos; seguiremos con la definición de las reglas de formación del agrupamiento y acabaremos con las reglas de preferencia del agrupamiento. Cerraremos con una breve conclusión en que discutiremos las matemáticas que se encuentran en la teoría generativa de Lerdahl y Jackendoff.

1. La estructura rítmica: agrupamiento y métrica

En los primeros capítulos Lerdahl y Jackendoff estudian el ritmo en profundidad. Se fijan en dos fenómenos rítmicos en particular: el grupo y la métrica. Según estos autores, el grupo aparece de manera natural cuando un oyente escucha una pieza de música; su oído detecta los motivos, los temas, las frases, los periodos, los grupos temáticos, las secciones y finalmente integra todo en la pieza entera. A la vez, como es el caso de la música tonal analizada en el libro, se encuentra la métrica, que está relacionada con los patrones regulares de acentos fuertes y débiles. Ambos fenómenos son distintos en esencia, pero su interacción constituye una importante fuerza musical. En esta sección examinaremos cada uno por separado y en la siguiente sección la interacción entre ellos.

1.1. La estructura de la agrupación

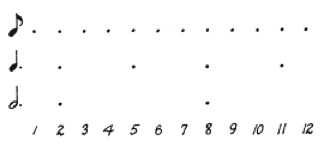

Lerdahl y Jackendoff apelan para la definición de agrupación a la tendencia del ser humano a percibir los objetos en grupos (ambos son perfectos conocedores de la teorías gestaltistas de la percepción, como se demuestra a lo largo de todo el libro). Ellos ven el grupo como un componente básico del entendimiento musical (página 13). La primera hipótesis que formulan acerca de la agrupación en la percepción musical es que esta ocurre de manera jerárquica. Por ejemplo, un motivo es parte de un tema, el cual a su vez es parte de un grupo temático formado por dos o más temas, el cual es parte de una sección, y así sucesivamente. Esta jerarquía clasifica los grupos por su tamaño (un motivo es menor que una sección) e incluye un grupo en otro mayor en base a las relaciones musicales entre ellos. En su lenguaje, si un grupo está incluido en otro se dice que el primero está subordinado al segundo; si un grupo contiene a otro, del primero se dice que domina o está superordinado al segundo. Los autores representan los grupos mediante conjuntos de ligaduras, como en el ejemplo de la figura 1. En dicha figura vemos que dos instancias del grupo p están incluidas en el grupo q.

Figura 1:

Representación de grupos (figura tomada de [LJ83]).

La segunda hipótesis sobre el agrupamiento es el solapamiento. Dada la estructura estrictamente jerárquica de los grupos, el solapamiento no está permitido entre grupos que pertenecen a un mismo grupo dominante. Así, el agrupamiento de la izquierda de la figura 2 constituye un agrupamiento aceptable, mientras que el de la derecha no lo es a causa de los solapamientos.

Figura 2:

Representación de grupos (figura tomada de [LJ83]).

A partir de estas dos hipótesis, Lerdahl y Jackendoff añaden otras dos, que ya no son tan generales y que perfilan y definen el sentido de su teoría generativa. La primera hipótesis es la estructura recursiva de los agrupamientos. Si un grupo dominante contiene un determinado número de subgrupos, esta relación, sin cambios sustanciales, se da en cualquier nivel. El ejemplo que ponen para ilustrar esto es el comienzo del scherzo de la sonata opus 2, número 2, en la mayor, de Beethoven, que vemos reproducido en la figura 3.

Figura 3:

Estructura recursiva de los grupos (figura tomada de [LJ83]).

La segunda hipótesis se refiere a la formación de los grupos y se sigue del principio de no solapamiento enunciado más arriba. Establece que el agrupamiento de grupos no contiguos no está permitido. Los grupos que pueden agruparse en otro más grande han de ser grupos contiguos. De otro modo, se producirían solapamientos prohibidos entre grupos. Así, si tenemos estos dos grupos (a,a,b) y (a,a,b) a un cierto nivel, el agrupamiento permitido es (a,a,b,a,a,b), pero no, por ejemplo, los grupos (a,a) y (b,a,a,b). Este principio aparece reflejado también en el ejemplo de la figura 3, donde todos los agrupamientos se producen entre grupos contiguos.

1.2. La estructura métrica

Siendo conscientes de los problemas terminológicos que el concepto de acento posee, Lerdahl y Jackendoff empiezan esta sección (página 17) definiendo este término de manera precisa. Distinguen tres tipos de acentos: el acento fenoménico, el acento estructural y el acento métrico. El acento fenoménico, el más general en su definición, es cualquier evento en la superficie musical que haga énfasis sobre algún elemento musical en un momento dado de la música. En el ejemplo de la figura 4, una reducción para piano de La danza de las jóvenes de La consagración de la primavera, tenemos ejemplos de acentos fenoménicos, que son los acentos que Stravinsky marcó en tiempos inesperados (marcados con el signo > en la partitura).

Figura 4:

Ejemplo de los distintos tipos de acentos.

El acento estructural es el producido por los puntos de gravedad armónicos y melódicos en una frase o sección; está fuertemente relacionado con el ritmo armónico o con el sentido final de la melodía. Por último, el acento métrico es cualquier tiempo que es relativamente fuerte en su contexto métrico. Para hablar de métrica es necesario suponer que existe una red de tiempos y que existe un patrón regular de tiempos fuertes y débiles. En el ejemplo anterior, el compás 2/4 marca que la primera negra es fuerte y la segunda débil; al nivel de la semicorchea ese patrón se hereda y tenemos cuatro corcheas en que las corcheas impares son fuertes y las corcheas pares débiles.

Obviamente, los tres tipos de acentos tienen estrechas relaciones en muchas ocasiones. A veces el acento fenoménico coincide con el métrico como pasa en el ejemplo de Stravinsky, donde algunas partes fuertes del compás de 2/4 coinciden con los acentos (pero otras, en cambio, no).

El acento fenoménico suele tener bastante relevancia perceptual y puede contradecir o no el acento métrico. Si el acento fenoménico es regular y se alinea con el métrico, se apoyan mútuamente, podríamos decir, entonces la sensación de regularidad es muy alta. Si por el contrario, el acento fenoménico, aun siendo regular, entra en claro conflicto con el métrico, entonces se produce una gran tensión rítmica.

Muy interesantes son los comentarios de la página 18 sobre la naturaleza de la métrica que hacen Lerdahl y Jackendoff (nuestra traducción).

Before proceeding, we should note that the principles of grouping structure are more universal than those of metrical structure. In fact, though all music groups into units of various kinds, some music does not have metric structure at all, in the specific sense that the listener is unable to extrapolate from the musical signal a hierarchy of beats.

(Antes de proseguir, deberíamos hacer notar que los principios de agrupamiento son más universales que los de la estructura métrica. De hecho, aunque todas las músicas agrupan en unidades de diversos tipos, algunas músicas no tienen estructura métrica en absoluto, en el sentido específico de que el oyente es incapaz de extrapolar una jerarquía de tiempos a partir de la señal musical.)

Aquí los autores reconocen que la estructura métrica es un constructo mental; en cambio, el agrupamiento es producto de un proceso perceptual.

Como dijimos arriba, los elementos básicos de la métrica son los tiempos. Estos tiempos son puntos temporales y como tales no tienen duración. La duración entre los tiempos se llama intervalo temporal y estos sí tienen duración. Una hipótesis que hacen Lerdahl y Jackendoff es que los tiempos están igualmente espaciados.

A partir de aquí, y a imagen y semejanza de lo que pasó con el agrupamiento, se dota a la métrica de una estructura jerárquica. Esto es típico de la música tonal objeto del análisis del libro, la música tonal de la práctica común. Un tiempo fuerte a cierto nivel métrico es descompuesto en dos o tres tiempos, dependiendo la división del compás, donde el primer tiempo fuerte sigue siéndolo en el nuevo nivel métrico. Los autores ilustran este punto con la siguiente figura:

Figura 5:

Jerarquía de la estructura métrica (figura tomada de[LJ83]).

Los principios que se establecieron para el agrupamiento —recursión, no solapamiento y adyacencia—se aplican con igual vigencia a la estructura métrica. En la figura 5 (a) tenemos un primer nivel en que todos los tiempos son fuertes (indicado por los puntos); en el siguiente nivel son los impares y, por último, en el siguiente nivel los tiempos fuertes son los múltiplos de cuatro. La figura 5 (b) muestra un esquema similar pero con un compás de 3/4.

En una pieza suele haber alrededor de cinco o seis niveles métricos. La métrica indicada por el compás suele ser la del nivel medio. No todos los niveles métricos se oyen con la misma prominencia. De hecho, un oyente puede centrar su atención en diversos niveles métricos a voluntad, pero los más prominentes son aquellos en que los tiempos van a una velocidad moderada.

Ledahl y Jackendoff son conscientes de los peligros que implica llevar un análisis métrico a gran escala. Ilustran estos peligros con el análisis del comienzo de la sinfonía número 40 de Mozart. Mientras que el análisis de la estructura métrica a pequeña escala es claro y unívoco, al análisis a gran escala (analizaron solo 9 compases) presenta muchas dificultades formales, hasta el punto que ellos mismos hablan ya de interpretación y no de análisis en sí mismo. Esta es una de las virtudes metodológicas de este libro: en general, delimita muy bien el alcance de sus hipótesis tanto por la discusión desarrollada como por los ejemplos que poner.

2. La interacción entre el agrupamiento y la estructura métrica

Para los autores es importante que las propiedades del agrupamiento y la estructura métrica, aunque sean semejantes, se mantengan separadas para el análisis. Ello no obsta para que investiguen sus interacciones, si bien desde definiciones formales diferentes. El siguiente pasaje del minueto de la sinfonía de Haydn número 104, en el que se ven ambos análisis, el de agrupamiento y el métrico, esclarece el porqué de ese empeño.

Figura 6:

Interacción entre agrupamiento y estructura métrica (figura tomada de [LJ83]).

Vemos que el agrupamiento no está alineado con la estructura métrica, que lleva su propia regularidad independiente de esta. Hay tiempos fuertes que caen en diversas partes de los grupos. Sin embargo, lo que oímos es el resultado de ambas interacciones.

3. Reglas de formación del agrupamiento

Esta sección es una síntesis del capítulo 3 del libro, capítulo que dedica a estudiar la organización de la superficie musical en grupos (página 36). Desde el primer momento, los autores mantienen que las reglas de formación del agrupamiento son independientes del lenguaje musical concreto. Esto significa que un oyente poco familiarizado con un lenguaje musical puede inferir el agrupamiento de una pieza en ese lenguaje. Aunque el libro fue publicado en el año 83, cuando la cognición musical ya había empezado a desarrollarse con fuerza, se echa de menos en esta parte referencias a la investigación empírica. Esta afirmación de que la formación de grupos es un principio general y que no depende del lenguaje musical requiere referencias a estudios con sujetos procedentes de diversas culturas. Hoy en día sabemos que, aunque es cierto que hay principios perceptuales que operan de modo general, hay muchos mecanismos de agrupación que provienen de la enculturación, sea esta consciente o no.

Tras los dos primeros capítulos, donde Lerdahl y Jackendoff describieron el agrupamiento y la métrica e hicieron las pertinentes hipótesis, ahora se centran en detallar la gramática generativa. Para ello dan una serie de reglas de formación correcta del agrupamiento (abreviadamente de aquí en adelante como RFCA). Antes de empezar a enumerar, los autores ponen encima de la mesa una limitación en el alcance de la teoría. Su teoría solo explica la música que es esencialmente homofónica y no la polifónica. Dejan como problema abierto esta cuestión, es decir, generalizar esta teoría de modo que pueda explicar la música contrapuntística y heterofónica.

Las reglas de formación especifican en qué condiciones se pueden formar los grupos. Estas reglas rezan como sigue:

RFCA 1: Cualquier sucesión contigua de eventos tonales, golpes de tambor o similares pueden constituir un grupo, y solo sucesiones contiguas pueden constituir grupos. RFCA 2: Una pieza constituye un grupo. RFCA 3: Un grupo puede estar constituido por otros grupos. RFCA 4: Si un grupo G1 contiene parte de otro grupo G2, entonces tiene que contener a todo G2 entero. RFCA 5: Si un grupo G1 contiene un grupo más pequeño G2, entonces G1 tiene que descomponerse en grupos más pequeños.

Para ilustrar estas reglas, los autores toman los primeros compases de la sinfonía de Mozart número 40, en sol menor. En la figura 7 vemos la formación de grupos a tres niveles, las cuales se han realizado acorde a las RFCA.

Figura 7:

Reglas de formación correcta del agrupamiento (figura tomada de [LJ83]).

La regla RFCA 1 no es más que la consecuencia inmediata de las definiciones de agrupamiento dadas más arriba, en la sección 1.1. Esta regla, por ejemplo, impide que las notas re del pasaje anterior se puedan considerar un grupo, ya que no son contiguas. Aquí se percibe que detrás de esta regla está el principio de contigüidad de la psicología gestaltista.

Las reglas RFCA 2 y RFCA 3 son una especie de condición de frontera; la pieza entera ha de percibirse como un todo y no como sucesión aislada de eventos.

Las reglas RFCA 4 y RFCA 5 tienen más calado musical. Determinan cómo ha de realizarse la inclusión de unos grupos dentro de otros. La regla RFCA 4 está pensada para que agrupaciones como las de abajo no ocurran:

Figura 8:

Agrupamientos incorrectos (figura tomada de [LJ83]).

Estos agrupamientos tienen solapamiento (el de la izquierda) y también vemos que G1 contiene parcialmente una instancia de G2 (ejemplo de la derecha).

La regla RFCA 5 por su parte prohibe estructuras de agrupamiento como la de la figura 9.

Figura 9:

Otros agrupamientos incorrectos (figura tomada de [LJ83]).

En estos agrupamientos vemos descomposiciones en grupos incompletas; la unión de G2 y G3 no da el grupo G1. Esta regla no prohibe, sin embargo, la descomposición de un grupo mientras que otra instancia de ese mismo grupo pueda no estar descompuesta. Véase el agrupamiento en el ejemplo de Mozart de la figura 7, en los tres primeros compases.

Lerdahl y Jackendoff son perfectamente conscientes que estas reglas no cubren todos los casos que se pueden encontrar en la práctica musical. En particular, no cubren las solapamientos de grupos y elisiones. La manera de tratar estos dos fenómenos musicales en su teoría no fue la de ampliar las reglas anteriores, sino crear una nueva categoría de reglas, llamadas reglas de transformación, que presentarán más tarde. Estas reglas de transformación tratarán el problema del solapamiento de grupos y las elisiones.

4. Reglas de preferencia del agrupamiento

De nuevo, con su habitual honestidad intelectual, Lerdahl y Jackendoff reconocen que las reglas que han enumerado hasta ahora pueden dar lugar a agrupamientos que van en contra de la intuición musical más básica. De hecho, ellos mismos ponen los siguientes ejemplos (página 39).

Figura 10:

Agrupamientos poco intuitivos permitidos por las RFCA (figura tomada de [LJ83]).

En efecto, parece que ninguna de estas agrupaciones podría corresponder al agrupamiento “natural” (bien van contra armonía, o contra la agrupación melódica). Los autores no se enfrentan a esta situación aumentando las reglas de formación. En su lugar, proporcionan un nuevo tipo de reglas, las reglas de preferencia de la agrupación (RPA a partir de ahora) . Estas reglas de preferencia se basan fuertemente en los principios gestaltistas de proximidad y similitud (y en el libro emplean un buen número de páginas a explicarlas a partir de ejemplos tomados del campo visual).

Las reglas de preferencia están divididas, a su vez, en dos categorías: las reglas de detalle local y las reglas de alto nivel. Dentro de la jerarquía ascendente de agrupamiento, las reglas de detalle local formalizan los grupos a bajo nivel y las reglas de alto nivel, los grupos que comprenden los grupos más grandes. Empezaremos por las reglas de detalle local, que son las siguientes:

RPA 1: Evítense los grupos que contengan un único evento. RPA 2 (proximidad): Considérense cuatro notas (n1,n2,n3,n4). Si el resto permanece igual, la transición n2 - n3 se puede oír como la frontera de un grupo si:

(Ligadura/silencio) el intervalo de tiempo desde el final de n2 hasta el principio de n3 es mayor que el del final de n1 al principio de n2 y que el del final de n3 al principio de n4, o bien si

(Punto de ataque) el intervalo de tiempo entre el ataque de n2 y n3 es mayor que el que va de n1 a n2 y el que va de n3 a n4.

RPA 3 (cambio): Considérense cuatro notas (n1,n2,n3,n4). Si el resto permanece igual, la transición n2 - n3 se puede oír como la frontera de un grupo si:

(registro) la transición n2 -n3 implica una distancia interválica mayor que la de n1 -n2 y la de n3 - n4, o si

(dinámica) la transición n2-n3 implica un cambio en dinámica y las transiciones n1-n2 y la de n3 - n4 no tienen ese cambio, o si

(articulación) la transición n2 - n3 implica un cambio de articulación y las transiciones n1 - n2 y la de n3 - n4 no tienen ese cambio, o si

(longitud) n2 y n3 son de diferente longitud y los dos pares n1,n2 y n3,n4 no difieren en longitud.

La primera regla RPA 1 tiene la intención de recoger la idea de que no se tiende a oír notas aisladas como eventos musicales significativos, sino que se tiende a integrarlos en grupos mayores. Solo en casos muy justificados (por otros elementos musicales apoyando fuertemente) podría identificarse una sola nota como un evento musical.

La segunda regla de preferencia RPA 2 establece las condiciones en que se forman las fronteras entre grupos consecutivos. La regla trata el caso de cuatro notas, donde la frontera se crea entre las notas segunda y tercera. Esta creación ocurre cuando hay un elemento musical más prominente (distancia interválica, dinámica o articulación) exactamente antes y después. En el ejemplo de abajo vemos la aplicación de esta regla de preferencia. Gracias a ella se puede explicar como las tres primeras notas en (a), (b) y (c) de la figura 11 se oyen como un grupo y el resto de las notas como perteneciente a otro grupo distinto.

Figura 11:

Reglas de preferencia de proximidad (figura tomada de [LJ83]).

La regla RPA 3 tiene bastantes paralelismos con la RPA 2. Los propios autores afirman en su libro que otros elementos musicales se pueden incorporar a esta regla, tales como la textura o el timbre. En la figura 12 tenemos un ejemplo en que se dan los cuatros casos de la regla de preferencia de cambio.

Figura 12:

Reglas de preferencia de cambio (figura tomada de[LJ83]).

Por último, tenemos en la figura 13 el mismo pasaje de la sinfonía número 40 de Mozart donde se pueden apreciar distintas aplicaciones de las reglas de preferencia anteriores.

Figura 13:

Reglas de preferencia de cambio (figura tomada de [LJ83]).

A continuación detallamos las reglas de organización de alto nivel. Son reglas que tratan de explicar y formalizar periodos más grandes de música que el motivo o simplemente que unos pocos compases. Para la regla RPA 7 necesitamos presentar dos nuevos conceptos, la reducción del tramo temporal y reducción de prolongación. La primera se refiere a cómo asignar a las alturas una jerarquía de importancia estructural con respecto a su posición en el agrupamiento y la métrica. La reducción de prolongación asigna a las alturas una jerarquía que expresa la tensión y relajación así como continuidad y progresión en los elementos armónicos y melódicos. En el artículo de septiembre se desarrollarán más a fondo estos dos conceptos.

RPA 4 (intensificación): Fórmese una frontera que dé lugar a un grupo mayor allí donde los efectos dados por las reglas RPA 2 y RPA 3 sean más pronunciados. RPA 5 (simetría): Prefiéranse los análisis de agrupamientos que se acerquen más al ideal de subdivisión de un grupo en dos subgrupos de igual longitud. RPA 6 (paralelismo): Allí donde dos o más segmentos de la música se puedan concebir como paralelos, preferiblemente deberán formar partes paralelas de un mismo grupo. RPA 7 (estabilidad del intervalo temporal y de prolongación): Prefiérase una estructura de agrupamiento que dé como resultado un intervalo temporal o una reducción de prolongación más estable.

En el ejemplo de la figura 14, la mera aplicación de las reglas RPA 2 (a) y (b) detectaría correctamente las fronteras entre los grupos de tresillos. Sin embargo, no marcaría la agrupación al siguiente nivel, el segundo, ya que esas reglas construyen las fronteras sobre las ligaduras y los ataques. La regla RPA 4 sí permite obtener las agrupaciones posteriores.

Figura 14:

Agrupaciones asociadas a tresillos (figura tomada de [LJ83]).

Las reglas RPA 5 y RPA 6 construyen las fronteras de los grupos a base de maximizar la simetría y el paralelismo. En el caso de la simetría, la regla de preferencia aconseja que en lo posible los subgrupos tengan la misma duración. En la figura 15vemos dos conjuntos de tresillos. En la figura 15 (a), dado que son cuatro tresillos, es inmediato que la agrupación natural es la que está desarrollada ahí. En figura 15 (b) tenemos seis grupos de tresillos y ahora estamos en presencia de dos interpretaciones posibles, la (i) y la (ii). Ninguna de las dos satisface a todos los niveles la regla RPA 5. En este caso, hay que acudir a otras consideraciones (ritmo armónico, textura u otros).

Figura 15:

Diversas agrupaciones posibles asociadas a tresillos (figura tomada de [LJ83]).

Para el caso del paralelismo, la regla RPA 6, tenemos el siguiente ejemplo.

Figura 16:

Agrupación basada en el paralelismo (figura tomada de [LJ83]).

El grupo de notas de la figura 16 (a) puede agruparse de varias maneras, pero según la regla RPA 6 esto ha de hacerse en grupos de tres notas porque de este modo el paralelismo entre los grupos se hace patente. Lo mismo puede decirse de la figura 16 (b), en este caso siendo la agrupación de cuatro notas.

En el próximo artículo se desarrollará y pondrán ejemplos de aplicación de la regla RPA 7.

5. Conclusiones

Del estudio de las reglas anteriores se extraen interesantes conclusiones. Lerdahl y Jackendoff optan por una descripción no matemática de su teoría, incluso aunque esta sea claramente matematizable. La formalización del agrupamiento, como hemos visto arriba, lleva implícita el concepto de recursión, concepto matemático donde los haya. Además la formación de los grupos es muy similar a una relación binaria tal como puede ser la inclusión; dicha relación de formación de grupos posee unas reglas para evitar los solapamientos y las elisiones. La formalización para la métrica es muy similar a la del agrupamiento, incluyendo también el concepto de recursión. Los casos que faltan por cubrir en el primer estadio de la formalización se suplen con la definición de las reglas de preferencia, que recogen fenómenos musicales más complejos (creación de grupos en base a articulación, diferencia interválica o de longitud, paralelismo, simetría, etc.). Como vemos, la teoría generativa tiene un sustrato matemático nítido.

La razón por la que Lerdahl y Jackendoff no exponen su teoría con un lenguaje abiertamente matemático (con símbolos y una formalización más dura) es porque no tienen interés en probar teoremas a partir de esta formalización (página 53, último párrafo). En su caso, se conforman con la exposición de su teoría en lenguaje natural (lo cual no quita que lo hagan con rigor) y confían en crear un sistema formal que constituya una buena descripción de la música tonal, que cubra cuanta más música posible y, por último, que sea lo más predictivo posible. También rechazan los aspectos cuantitativos de la teoría. No se esfuerzan en ningún momento en asignar funciones que puedan devolver números que expresen, por ejemplo, el grado de reducción de prolongación o la intensidad de la creación de la frontera de un grupo. Reconocen con total honestidad que no están interesados en esa cuantificación. Ellos quieren identificar las variables que son relevantes a la hora de establecer la intuición musical así como esas variables interactúan entre sí (página 54), pero no desde un punto de vista numérico.

Bibliografía

[Góm14] F. Gómez. Teoría generativa de la música - I, consultado en junio de 2014.

[LJ83] F. Lerdahl and R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983.

[LJ03] F. Lerdahl and R. Jackendoff. Teoría generativa de la música tonal. Akal, 2003. Traducción de Juan González-Castelao Martínez.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

Inauguramos una serie de artículos en la que estudiaremos la obra de Fred Lerdahl y Ray Jackendoff A Generative Theory of Tonal Music [LJ83], publicada en 1983. En castellano se publicó en 2003 por Akal [LJ03] con traducción de Juan González-Castelao. En este primer artículo estudiaremos la génesis de esta obra y sus fundamentos teóricos. En los siguientes artículos describiremos con cierto detalle las ideas de estos autores. Estos autores proponen una teoría generativa de la música tonal, es decir, una teoría que a partir de la definición de una serie de conceptos y reglas jerárquicas describan la estructura de una pieza de música tonal.

Figura 1:

Portada del libro original en inglés.

1. La génesis de la obra

El director de orquesta Leonard Bernstein, hombre por otro lado profundamente interesado en la teoría, fue un impulsor de la obra de Lerdahl y Jackendoff. En el otoño de 1973, Bernstein se encontraba impartiendo un seminario en la universidad de Harvard. Los trabajos de Noam Chomsky [Cho65] en pos de la construcción de una teoría generativa en el campo de la lingüística habían impresionado a Bernstein y este se preguntaba si esa teoría no se podía transferir al campo musical. ¿Era posible construir una gramática musical que explicase el fenómeno de la escucha musical?, tal era la pregunta que planteaba Bernstein a sus alumnos en aquel seminario. Entre los asistentes se encontraba el músico, compositor y teórico Fred Lerdahl y el lingüista y clarinetista Ray Jackendoff. Bernstein pedía a sus alumnos que expusiesen los resultados de su trabajo ante la clase cada semana y era frecuente que los alumnos se ayudasen entre sí. Jackendoff y Lerdahl se leían mutuamente sus trabajos en busca de la crítica constructiva del otro. Como fruto de esto, se percataron de que tenían preocupaciones intelectuales similares y empezaron a colaborar más seriamente. Con el tiempo fueron dando forma a sus ideas y estas cuales acabaron por cristalizar en A Generative Theory of Tonal Music. En el prefacio del libro (página x), hablan de la división del trabajo en el libro entre los dos autores. Lerdahl, el músico, planteaba problemas en términos musicales y proporcionaba ejemplos, y Jackendoff, el lingüista, construía los sistemas formales que trataban de explicar los fenómenos musicales. Sin embargo, Lerdahl conocía muy bien los sistemas formales en lingüística y Jackendoff era clarinetista con una sólida formación musical. Ambos estaban perfectamente capacitados para contribuir con ideas y críticas en ambos aspectos de la obra y así lo reconocen explícitamente en su obra (Our individual contributions are hopelessly intertwined.)

Tras el seminario impartido por Bernstein, Lerdahl y Jackendoff continuaron trabajando asiduamente hasta el año 1979. Se reunían semanalmente para desarrollar su teoría, la cual fueron presentando en diversos seminarios y publicando por partes en varias revistas (Journal of Music Theory, The Music Quaterly y en el libro Music, Mind and the Brain). Con el tiempo se dieron cuenta de que el material que habían producido daba de de sí como para escribir un libro en lugar de presentarlo en artículos sueltos o en conferencias. Después del año 79, la colaboración siguió, aunque no tan intensa, pues Lerdahl se fue a la Universidad de Columbia. En el año 83 publicaron su obra. Para una visión de uno de los autores (Lerdahl) sobre la génesis de este libro, véase [Ler09].

2. Teoría de la música como objeto de estudio psicológico

El capítulo uno de su libro abre con la siguiente declaración de intenciones (las cursivas son suyas; nuestra traducción):

We take the goal of a theory of music to be a formal description of the musical intuitions of a listener who is experienced in a musical idiom.

(Nos hemos fijado el objetivo de una teoría de la música que sea una descripción formal de las intuiciones musicales de un oyente que tenga experiencia en una tradición musical.)

Esta frase marca el tono de la obra y su metodología. Lerdahl y Jackendoff buscan una nueva manera de analizar la música. Para ello, recurren a la psicología para construir esa nueva metodología. Ambos autores tenían un gran conocimiento de la bibliografía relevante y en particular estaban familiarizados con las obras de Meyer y Cooper (especialmente [Mey56] y [CM63]), Narmour, Sloboda, Bregaman y Krumhansl, entre otros. Para justificar este nuevo análisis formulan una crítica de las viejas metodologías de análisis. Está, por un lado, el análisis de piezas individuales, un análisis clásico que se vale del estudio melódico, armónico, rítmico, entre otros, y que persigue resaltar facetas interesantes de la pieza. Para ellos, sin embargo, este tipo de análisis, aunque revela hechos interesantes sobre una pieza, no es riguroso ni sistemático en muchas ocasiones, y no permite generalizaciones o una sistematización útil. Con frecuencia depende de la habilidad y la brillantez del crítico a la hora de analizar la pieza. La opción contraria es crear un sistema altamente riguroso y formalista dentro del cual estudiar todas las piezas de una tradición musical. Los ejemplos históricos que ponen los autores tampoco les convencen: la teoría musical de la Edad Media, basada en la teología; los sistemas de Rameau y Hindemith, basados en los principios físicos de la serie de armónicos; o las teorías matemáticas de la música del siglo XX.

Merece la pena detenerse en este último punto, sobre todo por el tema de una columna como esta. Lerdahl y Jackendoff objetan al hecho de que las matemáticas den fundamento a los constructos y relaciones en la teoría de la música porque “las matemáticas son capaces de describir cualquier tipo de organización concebible”. Una teoría satisfactoria no solo debe ser capaz de describir ciertos constructos, sino además determinar porque se usan unos ciertos constructos y no otros. La crítica hacia el uso de las matemáticas que hacen los autores refleja excesos formalistas del pasado. A la vista de la cantidad de investigación que ha habido en música desde un punto de vista matemático desde la publicación de A Generative Theory of Tonal Music, y teniendo en cuenta la calidad y la metodología de dicha investigación, su crítica aparece teñida de cierta ingenuidad. Si la formalización matemática ignora la realidad que analiza y se convierte en un mero juego axiomático-deductivo, ¿qué significado asignará a esa formalización? Ninguno, claro; pero ese es un uso incorrecto de las matemáticas. La formalización correcta parte de los hechos musicales y trata de explicarlos y predecir otros, y en última instancia está siempre sometida al contraste con la propia música.

Por último, los autores rechazan el análisis basado puramente en la intuición artística. No desprecian este análisis; simplemente no creen que la música se deba analizar únicamente con dicho método.

¿Qué método, pues, proponen Lerdahl y Jackendoff? Uno basado en la psicología. Por un lado, sostienen que una pieza de música es una entidad construida mentalmente (página 2). Su objetivo es explicar la música como el sonido organizado en nuestra mente. Desde este punto de vista, la música es objeto de estudio psicológico. La teoría de estos autores necesita la introducción de un concepto nuevo: las intuiciones musicales de un oyente experimentado (página 3). Por intuiciones musicales se refieren a procesos inconscientes de escucha musical que vienen determinados por la enculturación del oyente en cierto lenguaje musical. Además, el concepto de oyente experimentado es una idealización del oyente y del grado de conocimiento de un lenguaje musical. Esa asimilación dentro de un lenguaje musical dado viene gobernada por ciertas reglas y con su teoría Lerdahl y Jackendoff persiguen describir esas reglas en términos de una gramática formal de la música. Hay una segunda idealización de este oyente y su escucha y es que en la teoría generativa se explica el estado final del entendimiento musical y no explica la percepción durante la la escucha musical.

3. Teoría de la música y lingüística

A pesar de su inspiración en la teoría generativa de Chomsky, Lerdahl y Jackendoff ponen mucho énfasis en distinguir lenguaje y música y en que ambas teorías -si bien se encuentran paralelismos importantes entre ambas- son esencialmente diferentes. En particular, los autores rechazan los peligros de sobreformalización que puede llevar una aplicación excesivamente literal de la teoría generativa de Chomsky a la música. Entre esos peligros los autores apuntan a un afán de validación de la teoría en meros términos computacionales, perder de vista el papel que juega el significado en la música y en el lenguaje -papel que difiere en una y otra-, o pasar inadvertidas las diferencias estructurales entre música y lenguaje.

4. La forma general de la teoría generativa

Lerdahl y Jackendoff proponen una estructura jerárquica compuesta por cuatro partes y que forma la base sobre la cual proporcionarán una descripción estructural de una pieza musical. Esas cuatro jerarquías son:

Estructura de agrupación. Expresa la segmentación jerárquica de la pieza en términos de motivos, frases y períodos.

Estructura métrica. Expresa los fenómenos métricos, esto es, los relacionados con la alternancia de tiempos fuertes y débiles.

Reducción interválica-temporal. Asigna una jerarquía a los tonos de una pieza en función de la estructura de agrupación y métrica.

Reducción de prolongación. Más abstracta que las anteriores, asigna a los tonos una jerarquía que expresa la dialéctica tensión-relajación en los aspectos armónicos y melódicos.

La teoría generativa además proporciona dos tipos de reglas, las de formación correcta y las de preferencia. Su función es determinar qué descripciones estructurales son correctas y sobre estas cuáles tienen más preferencia. Como dicen los mismos autores, el criterio empírico de éxito de la teoría es cuán adecuadamente describe las intuiciones musicales. Estas reglas están concebidas con este objetivo. Cuando empezaron a probar su teoría con ejemplos musicales concretos, vieron que las reglas de formación correcta no eran suficientes e introdujeron las reglas de transformación. La figura de abajo, tomada de su libro, representa un esquema de la teoría generativa de la música.

Figura 2:

Esquema de la teoría de Jackendoff y Lerdahl.

Bibliografía

[Cho65] N. Chomsky. Aspects of the theory of syntax. MIT Press, Cambridge, Massachussetts, 1965.

[CM63] G. Cooper and L.B. Meyer. The Rhythmic Structure of Music. University of Chicago Press, Chicago, 1963.

[Ler09] F. Lerdahl. Genesis and architecture of the gttm project. Music Perception, 26:187–194, 2009.

[LJ83] F. Lerdahl and R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983.

[LJ03] F. Lerdahl and R. Jackendoff. Teoría generativa de la música tonal. Akal, 2003. Traducción de Juan González-Castelao Martínez.

[Mey56] Leonard Meyer. Emotion and Meaning in Music. University of Chicago Press, Chicago, 1956.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

En la columna de este mes de febrero vamos a glosar un artículo del famoso teórico de la computación Donald Knuth [Wik14] cuyo título reza Randomness in Music (La aleatoriedad en la música) y que aparece en el excelente volumen recopilatorio The best writing on mathematics 2013 [Knu13]. Este volumen comprende los mejores escritos de matemáticas publicados en el año 2013 (según, al menos, sus editores), pero recomendamos su lectura (toca temas que van desde la definición de las matemáticas, la importancia de estas, la ansiedad matemática, y otros temas apasionantes).

Respecto al autor, es sobradamente conocido. Se le considera el padre del análisis de los algoritmos pues ha contribuido decisivamente a su fundamentación teórica. Escribió The Art of Computer Programming (El arte de programar ordenadores) [Knu97], donde describió algoritmos fundamentales así como estructuras de datos y proporcionó el análisis de su complejidad. Knuth es también el creador del programa TeX, el editor de textos científicos universal por antonomasia, así como del diseño de tipos Metafont. Aquí en España fue galardonado en 2010 con el Premio Fundación BBVA Fronteras del Conocimiento en la categoría de Tecnologías de la Información y la Comunicación.

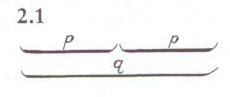

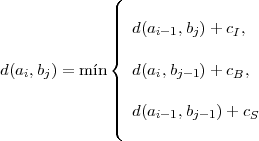

1. Armonizaciones matemáticas

En su artículo Knuth propone un método para armonizar melodías a partir de un algoritmo matemático, el cual introduce aleatoriedad en dichas armonizaciones. Knuth elabora el concepto de imperfección planeada, la idea de que los sistemas perfectos no producen belleza y que la presencia de microvariaciones en los patrones musicales o visuales hacen a estos más atractivos. La idea que presenta se le ocurrió a partir de las clases de armonía que tomó (Knuth es también músico) con David Kraehenbuehl en el Westminter Choir College. El texto de Knuth nos dará una buena oportunidad de analizar críticamente las relaciones entre las matemáticas y la música —una vez más—.

1.1. Conceptos previos de música