Home » Cultura y matemáticas » Música y matemáticas

Música y matemáticas

El objetivo de esta sección es comprender la interesante y profunda relación de las Matemáticas con la Música.

Nuestro sincero agradecimiento a Francisco Gómez Martín (Universidad Politécnica de Madrid) por organizar y desarrollar esta sección, a sus anteriores responsables Rafael Losada y Vicente Liern, así como a todas las personas que colaboran con la misma.

Resultados 51 - 60 de 130

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

Esta es la última entrega de la serie sobre composición algorítmica. Inicialmente, teníamos planeado que esta entrega versara principalmente sobre música fractal. Tras sopesarlo cuidadosamente y escuchar a unos cuantos amigos músicos, hemos pensado que la música fractal merece una serie por sí misma. En este artículo, en su lugar, describiremos de modo general algunas de las técnicas de composición algorítmica que más lejos han llegado. Es imposible tratarlas todas con detalle, pero daremos sus principales características y proporcionaremos al lector la bibliografía adecuada para que profundice llegado el caso. En la primera entrega [Góm16d] estudiamos qué es un algoritmo. En la segunda entrega [Góm16e] nos centramos en el fenómeno de la composición musical; nuestra aproximación conceptual incluía, como decíamos allí, un gran rango de prácticas. En la tercera entrega [Góm16a] examinamos los algoritmos genéticos con cierto detalle y desarrollamos unos cuantos ejemplos en que se aplicaban esas técnicas a diversos elementos musicales (seguimos en nuestra exposición de esta parte el trabajo de Bruce Jacob [Jac96]).

2. Técnicas matemáticas de composición

Aunque es muy difícil caracterizar las técnicas matemáticas de composición en general, por su variedad y riqueza, un rasgo común que se aprecia en todas ellas es la importancia que posee la obtención de modelos computacionales. No puede haber composición algorítmica sin modelos computacionales de la música. Estos modelos se generan observando qué características musicales son susceptibles de ser traducidas a términos computacionales. Hay muchas características musicales que tienen tal susceptibilidad, desde la altura del sonido, que se rige por principios físicos, hasta la duración, que en la misma tradición occidental es divisiva y, por tanto, se puede describir mediante teoría de números; pero también de otras características, en principio más alejadas de una descripción computacional, como puede ser la armonía, la conducción de voces o el timbre, se han descrito modelos computacionales bastante potentes. Véase, para mayor información sobre este tema, el excelente libro de Benson [Ben06] Music: A Mathematical Offering; para ver un ejemplo de cómo Xenakis modeliza los parámetros musicales, véase en esta columna el número de octubre de 2010 [Góm16c]. Los primeros modelos computacionales eran pobres, entre otras razones porque no tuvieron en cuenta la cognición musical, esto es, los fenómenos perceptuales y psicológicos de la escucha musical. Posteriormente, los modelos poco a poco empezaron a incorporar la información sobre los procesos cognitivos y entonces mejoraron sustancialmente; véase [PHG+08] para más información sobre modelos computacionales de la percepción y la cognición. Una vez que el problema del modelo computacional de la música estuvo resuelto, o al menos mínimamente encaminado, frente al compositor se abrieron muchas posibilidades para la composición algorítmica. ¿Qué se puede hacer con esos modelos? ¿Cómo manipularlos de modo que salga música con significado?

Dos grandes categorías de técnicas compositivas se pueden reconocer en la composición algorítmica: la composición basada en conocimiento y la composición estocástica. La primera categoría es muy amplia e incluye, por ejemplo, la composición basada en gramáticas o la composición basada en patrones. La segunda no es menos amplia y en ella encontramos la composición mediante algoritmos genéticos, la composición basada en modelos matemáticos (al estilo de Xenakis, por ejemplo) o la composición basada en modelos de Markov.

3. Composición basada en conocimiento

Tanto la composición basada en gramáticas como la basada en patrones buscan extraer cierta información esencial de la música para, una vez descrita en términos computacionales, diseñar algoritmos para producir nueva música. En el caso de las gramáticas, sus teóricos ven la música como un lenguaje y como tal tiene una gramática, con su sintaxis, su semántica, su pragmática y sus reglas de estilo. Chomsky, con su teoría generativa del lenguaje [Cho65], mostró cómo era posible formalizar las reglas del lenguaje. Veinte años después de Chomsky, en 1983, Lerdahl y R. Jackendoff [LJ83], formalizaron la música tonal occidental en el libro A Generative Theory of Tonal Music. Estos dos autores mostraron que la música occidental tiene una cierta estructura recursiva y que existen ciertas reglas que permiten una descripción satisfactoria de la música en términos computacionales.

Como ejemplo de composición algorítmica basada en gramática tenemos el algoritmo de William Shottstaedt [Sho89] que genera piezas contrapuntística basadas en las reglas de contrapunto del Gradus ad Parnassum establecidas por Johann Joseph Fux (1660–1741), un teórico del Barroco tardío. El algoritmo contiene más de 75 reglas para producir las melodías. Entre esas reglas están la prohibición de las quintas paralelas y de los tritonos en ciertas situaciones. Kemal Ebcioglu [Ebc90] desarrolló un algoritmo que generaba corales a cuatro voces en el estilo de Bach teniendo en cuenta más de 350 reglas. Estos son ejemplos de algoritmos usados para la composición y que están basados en reglas. Véase el artículo Algorithmic composition, a definition [Bur] para más información sobre estas técnicas.

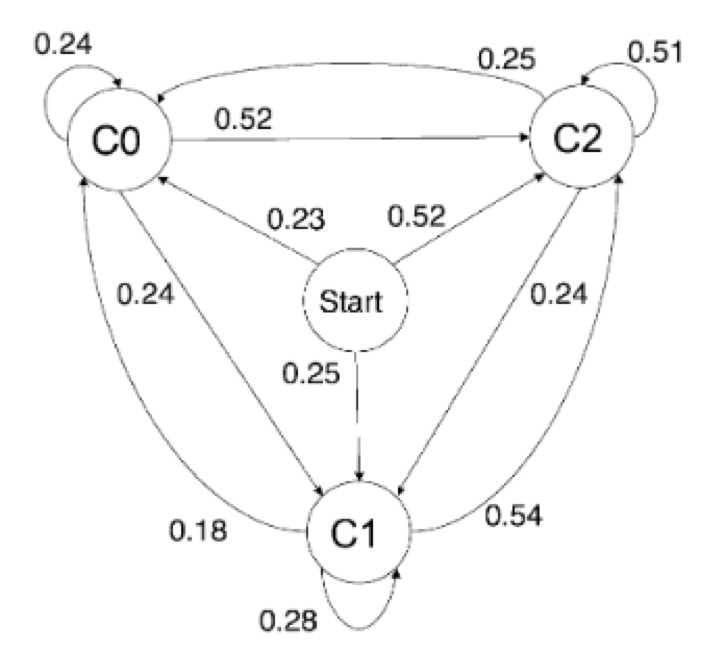

En los ejemplos anteriores las gramáticas musicales se extrajeron de modo manual, por mediación humana. Sin embargo, el gran reto es llegar a un modelo computacional en que la intervención humana no sea necesaria y que los resultados sean de calidad. Con el avance de las técnicas de aprendizaje automático, basadas a su vez en técnicas estadísticas de gran potencia, la caracterización automática de las gramáticas musicales fue posible. Gillick, Keller y Tang presentaron en 2010 [GKT10] un sistema de aprendizaje automático de gramáticas de jazz llamado Impro-Visor (es un programa de libre distribución). Empezaron escogiendo un autor concreto y un corpus de sus solos transcritos por expertos. A partir de él y usando cadenas de Markov y técnicas de aprendizaje automático generaban solos en el estilo del autor. La primera dificultad estriba en la representación de la gramática. El algoritmo busca patrones rítmicos y melódicos y a partir de ellos crea cadenas de Markov; para más información sobre este proceso en concreto, véase el artículo del mes de mayo de 2016 escrito por Kristy Yun y Mariana Montiel [JM16] en esta misma columna. En la figura 1 vemos el grafo asociado a una cadena de Markov para unos ciertos estados. Obsérvese que la suma de los pesos de las aristas de salida de cualquier nodo es 1, como corresponde a una distribución de probabilidad.

Figura 1: Cadenas de Markov para el aprendizaje automático de gramáticas musicales (figura tomada de [GKT10])

Los autores describen el proceso de generación de la gramática como sigue:

Descomponer el corpus en fragmentos melódicos, típicamente de un compás aproximadamente.

Traducir cada fragmento en una melodía abstracta. Esta melodía está compuesta por los contornos melódicos, categorías de notas, duraciones y otras características.

Ejecutar un algoritmo de agrupamiento en las melodías abstractas. La salida del algoritmo dará grupos, que normalmente tendrán unas diez melodías en media.

Comparar los grupos con el corpus para determinar el orden en que aparecen los grupos en el corpus.

Extraer los n-gramas de los grupos, donde n típicamente varía entre 2 y 4. Este parámetro lo ajusta el usuario. Véase la columna [Góm16b] para mayor información sobre el uso de los n-gramas en música.

Los autores dieron a un grupo de expertos los resultados para que evaluasen la calidad de los solos. Para solos de entre 4 y 8 compases, el algoritmo es capaz de generar solos la mayor parte de las veces que suenan razonablemente bien como el autor del corpus. Solos más largos de 8 compases ya no suenan bien, sobre todo por la falta de finalidad melódica. Los resultados mejores se obtienen para 4-gramas, que permiten sacar solos convincentes de mayor longitud. Los solos que se generan con n-gramas con n ≥ 5 no se parecen a los del autor del corpus. Los solos con 2-gramas o 3-gramas no dan resultados coherentes de modo regular.

El otro enfoque dentro de los métodos de composición basados en conocimiento es el de patrones. En el contexto de la improvisación, que sin duda es una forma de composición, hay dos teorías que tratan de explicar su funcionamiento. Una teoría se basa en la idea, de nuevo, de las gramáticas y sus defensores sostienen que los improvisadores aprenden la gramática del estilo musical dado y luego la ponen en juego en tiempo real; digamos, que sencillamente hablan en el lenguaje que han aprendido. Esa gramática consiste en una serie de reglas sintácticas y estilísticas; el trabajo de Gillick y sus colaboradores es un exponente de este enfoque. La otra teoría mantiene que el improvisador aprende en base a patrones. Tras estudiar el estilo aprende que ciertos patrones son musicalmente idiomáticos y otros no, y en tiempo de improvisación los combina dentro unos límites y bajo una sintaxis. Martin Norgaard y sus colaboradores [NSM13] diseñaron y programaron un algoritmo que obtenía los patrones más importantes de un corpus para un autor dado y creaba una base de datos con ellos. A partir de esa base de datos se construía una cadena de Markov que luego era capaz de generar una improvisación en el estilo del autor. Los resultados de este algoritmo fueron satisfactorios, pero solo incluían el ritmo y la altura del sonido. Defensores de ambas teorías reconocen que lo más probable es que en la práctica la improvisación sea una combinación de ambos enfoques, que se aprendan a la vez la gramática y los patrones característicos; sin embargo, nadie sabe cómo funciona esa combinación.

Los avances en inteligencia artificial han hecho también que algunos algoritmos sean capaces de crear sus propias gramáticas musicales a partir de gramáticas aprendidas de un cierto estilo. Algunos algoritmos han producido obras que imitan los estilos de los grandes maestros de la música clásica y cuyos resultados son bastante convincentes; véase el trabajo de Maurer [Mau] para más información.

4. Composición estocástica

El pionero indiscutible de composición estocástica en el sentido moderno del término es Xenakis. Antes que él ya había habido intentos de componer aleatoriamente: Mozart tirando los dados para componer melodías o John Cage con su indeterminismo. Xenakis rechaza el indeterminismo de Cage por su falta de un principio causal en la concepción musical. Escuchando Music for piano, de Cage, por ejemplo, donde las alturas del sonido están elegidas en base alas imperfecciones de un papel, Xenakis se preguntaba cuál es el sentido musical y estético de tal elección. El crítico Pousseur [Pou66] apoya esta objeción y añade que “donde se usan las más abstractas construcciones, uno tiene la impresión de encontrarse ante la presencia de las consecuencias de sonidos tocados libre y aleatoriamente”. En el caso de Xenakis, hay que insistir vehementemente en que no usaba el ordenador para producir la música en forma final, sino que se servía del ordenador como ayuda a causa de su rápida capacidad de procesamiento. En Xenakis, el concepto artístico es lo principal y todo lo demás está subordinado a él, incluso los mismos conceptos matemáticos y computacionales; véase su libro Formalized music [Xen01] para una exposición completa de sus ideas musicales y estéticas. En cambio, otros compositores, como Hiller e Isaacson [HI79], delegan en el ordenador la toma de las decisiones creativas.

En una columna de Divulgamat [Góm16c] analizamos la obra de Xenakis Pithokrapta, que se puede considerar una representación sonora (una sonificación [vaaat10]) del fenómeno físico de los gases ideales. En esta obra Xenakis aplicó dos principios musicales: primero, el sonido ha de tener total independencia; segundo, la música ha de poseer un significado global, derivado éste de la acumulación de los efectos individuales de las partes. La manera en que Xenakis fundió ambos principios es ingeniosa y original. Acudió a la ley de los grandes números, que enunciamos más abajo.

Teorema 4.1 (Ley débil de los grande números.) Sean X1, X2,... una sucesión infinita de variables aleatorias independientes con la misma media μ y varianza σ2, ambas finitas. Sea = la media muestral de las n primeras variables aleatorias y ϵ > 0 un número real positivo. Entonces se tiene:

Este importante y bellísimo teorema nos explica por qué observamos causas macroscópicas como resultado de la acción de múltiples causas pequeñas e independientes. Aquí el significado musical resultante está representado por la media μ común a todas las variables independientes. Xenakis asignó a grupos de cuerda pequeñas voces que actuaban de manera independiente respecto al total, pero que sin embargo generaban un resultado global claro. En la figura de abajo se ve el resultado final de Pithokrapta en forma de partitura gráfica.

Figura 2: Grafo de Pithoprakta

El problema de la composición estocástica en que el algoritmo toma decisiones estético-musicales es la evaluación final del resultado. En el caso de Xenakis no hay tal delegación de esas decisiones y el resultado es totalmente coherente con su visión estética. Cuando es el algoritmo el que dicta la estética resultante los resultados no son tan convincentes. Discutiremos estas cuestiones en la sección de conclusiones.

5. Conclusiones

Por mucho que ensanchemos hasta sus límites el concepto de composición musical, siempre tiene que haber una evaluación musical y estética de esas composiciones. Entonces, la pregunta es: ¿cómo decidimos si una composición que usa algoritmos tiene mérito estético? Algunos autores han considerado que el mérito estético de la composición algorítmica residía en la propia belleza del algoritmo, pero aquí la cuestión es juzgar el mérito estético y no la del algoritmo que la produce. Otros autores mantienen que se debe juzgar ambos aspectos, el algoritmo y su resultado musical. El argumento que se esgrime en contra de la evaluación estética de los algoritmos es que estos son meros medios para conseguir un resultado artístico y que, por tanto, no son susceptibles de juzgar su mérito estético en el contexto musical.

En su libro digital Algorithmic composition: a gentle introduction to music composition using common LISP and common music, Simoni [Sim03] (capítulo 2, sección final) hace las siguientes reflexiones sobre la cuestión estética (nuestra traducción):

All of these responses to the process and product of algorithmic composition are valid as each view is simply a manifestation of a personal aesthetic. Unfortunately, composers of algorithmic music have not been formally surveyed regarding their views on the aesthetics of algorithmic composition so we do not know how many composers fall into which category at any given time or if there are more categories to consider.

In the absence of a formal survey, we let the repertoire of algorithmic composition speak for itself. In reviewing algorithmic processes throughout the twentieth century, the number of compositions that are supported by documented algorithms are dwarfed by those that are not. In fact, when asking composers to provide algorithms accompanied by software implementation for this book, many composers confided that their code is not up to Knuth’s standards of simplicity, elegance, parsimony, and tractability.

[Todas las anteriores respuestas (las dadas al principio de estas conclusiones) al proceso y resultado de la composición algorítmica son válidas en cuanto que cada juicio es simplemente la manifestación de una estética personal. Desafortunadamente, los compositores de música algorítmica no han evaluado formalmente sus juicios sobre la estética de la composición algorítmica, de modo que no sabemos cuántos compositores caen en cada categoría en un momento dado o si ni siquiera hay más categorías que considerar.

En ausencia de una evaluación formal, dejemos que sea el repertorio de la composición algorítmica el que hable por sí mismo. Revisando las composiciones algorítmicas a lo largo del siglo XX, el número de composiciones que tienen sus algoritmos documentados es nimia comparado con los que no lo tienen. De hecho, cuando se pidió a los compositores que proporcionaran algoritmos acompañados por programas implementados para este libro, muchos revelaron que el código no estaba a la altura de los estándares de Knuth en cuanto simplicidad, elegancia, parsimonia y tratabilidad. ]

Otros artistas, incidiendo en el aspecto conceptual del arte, defienden que el criterio estético para juzgar esta música debería ser la calidad poética de la visión del artista. Aquí incluyen elementos como la idea artística y su materialización, la eficacia con que dicha idea se transmite, la superación de los medios tradicionales para comunicar la idea y la originalidad asociada a la idea y/o su materialización. Estos criterios presuponen un gran conocimiento del artista y de su ideal estético, lo cual, desgraciadamente, no ocurre con mucha frecuencia.

Como puede apreciar el lector, la cuestión de la evaluación estética de la música algorítmica está más que abierta a discusión.

Bibliografía

[Ben06] D. Benson. Music: A Mathematical Offering. Cambridge University Press, 2006.

[Bur] Kristine Burns. Algorithmic composition, a definition. http://music.dartmouth.edu/~wowem/hardware/algorithmdefinition.html.

[Cho65] N. Chomsky. Aspects of the theory of syntax. MIT Press, Cambridge, Massachussetts, 1965.

[Ebc90] Kemal Ebcioglu. An expert system for harmonizing chorales in the style of Bach. Journal of Logical Programming, 8:145–185, 1990.

[GKT10] J. Gillick, R. M. Keller, y M. Tang, K. Machine learning of jazz grammars. Computer Music Journal, 34:56–66, 2010.

[Góm16a] P. Gómez. Composición algorítmica (iii). Consultado en diciembre de 2016.

[Góm16b] P. Gómez. Distancia y similitud musical - ii. Consultado en diciembre de 2016.

[Góm16c] P. Gómez. Las matemáticas en la música de xenakis - i. Consultado en diciembre de 2016.

[Góm16d] P. Gómez. Composición algorítmica (i). Consultado en julio de 2016.

[Góm16e] P. Gómez. Composición algorítmica (ii). Consultado en octubre de 2016.

[HI79] L. A. Hiller y L. M. E. Knuth Isaacson. Experimental music: Composition with an electronic computer. Greeenwood Publishing Group Inc., 1979.

[Jac96] B.L. Jacob. Algorithmic Composition as a Model of Creativity. Organized Sound, 1(3):157–165, 1996.

[JM16] Kristy Jun y Mariana Montiel. Cadenas de markov con restricciones aplicadas a modelos cognitivos en la improvisación del jazz. Consultado en diciembre de 2016.

[LJ83] F. Lerdahl y R. Jackendoff. A Generative Theory of Tonal Music. MIT Press, Cambridge, Massachussetts, 1983.

[Mau] John Maurer. A Brief History of Algorithmic Composition. https://ccrma.stanford.edu/~blackrse/algorithm.html.

[NSM13] M. Norgaard, J. Spencer, y M. Montiel. Testing cognitive theories by creating a pattern-based probabilistic algorithm for melody and rhythm in jazz improvisation. Psychomusicology, 23:243–254, 2013.

[PHG+08] Hendrik Purwins, Perfecto Herrera, Maarten Grachten, Amaury Hazan, Ricard Marxer, y Xavier Serra. Computational models of music perception and cognition i: The perceptual and cognitive processing chain. Physics of Life Reviews, 5(3):151 – 168, 2008.

[Pou66] Henry Pousseur. The question of order in the new music. Perspectives in New Music, 1:93–111, 1966.

[Sho89] William Shottstaedt. Current directions in computer music research. chapter Automatic Counterpoint, pages 199–214. MIT Press, Cambridge, MA, USA, 1989.

[Sim03] Mari Simoni. Algorithmic composition: a gentle introduction to music composition using common LISP and common music. SPO Scholarly Monograph Series. The Scholarly Publishing Office, The University of Michigan, University Library, Ann Arbor, Michigan, 2003. https://quod.lib.umich.edu/s/spobooks/bbv9810.0001.001/1:1/--algorithmic-composition-a-gentle-introduction-to-music?rgn=div1;view=fulltext.

[vaaat10] Varios autores asociados a International Community for Auditory Display. Sonification report: Status of the field and research agenda. http://www.icad.org/websiteV2.0/References/nsf.html, accedido en septiembre de 2010.

[Xen01] Iannis Xenakis. Formalized Music: Thought and Mathematics in Composition. Number 6 in Harmonologia. Pendragon Press, Hillsdale, NY, 2001.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1.Técnicas matemáticas de composición

Esta entrega es la tercera de la serie composición algorítmica. En la primera [Góm16a] dimos una visión general de algoritmo (con ejemplos tomados de [CLRS01, Knu73]) e ilustramos ese concepto con algoritmos de ordenación. Allí insistimos en la importancia de distinguir entre algoritmo y código. En la segunda entrega [Góm16b] reflexionamos sobre la definición de composición musical. Como decíamos en la introducción de esa entrega, por composición musical se puede entender un gran rango de prácticas y merecía la pena reflexionar sobre ellas antes de entrar en la descripción de las técnicas de composición algorítmica propiamente dichas. En este artículo estudiaremos algoritmos genéticos y los procesos estocásticos.

La idea de componer mediante algoritmos ya apareció antes de la propia invención del ordenador. Si se interpreta el concepto de algoritmo como una solución constructiva a un problema, entonces se encuentran precedentes de la composición algorítmica moderna ya en el Renacimiento. Durante este periodo eran relativamente populares los juegos de dados para componer música. Componían a partir de un conjunto de fragmentos que juntaban según el orden dado por las tiradas de un dado. La primer pieza de que tenemos noticia que se compuso con un ordenador fue escrita por Hiller e Isaacson [HI79] en 1957. Era un cuarteto de cuerda y usaron un ordenador de la Universidad de Illinois. La composición algorítmica cobró un gran impulso cuando en 1991 Horner y Goldberg en la IV Conferencia Internacional sobre Algoritmos Genéticos presentan un artículo [HG91] donde muestran como aplicar los algoritmos genéticos a la composición musical. Los algoritmos genéticos como tales fueron presentados por John Holland a principios de los años 70 [Hol92].

2. Algoritmos genéticos y composición musical

2.1. Descripción de los algoritmos genéticos

La expresión algoritmo genético viene de que están inspirados (y descritos) en la biología, en particular, en la teoría de la evolución genético-molecular. Vamos a describir los elementos formales de un algoritmo genético y luego ver cómo se aplican a la composición musical.

Un algoritmo genético está diseñado para resolver algún tipo de problema (para nosotros será obtener una composición musical). La solución se obtiene a través de un proceso iterativo que converge hacia dicha solución. Un algoritmo genético tiene los siguientes elementos:

Una población inicial de candidatos a solución del problema. La población inicial recibe otros nombres como soluciones potenciales, individuos, criaturas. Los individuos tienen una serie de características que los definen y que son los fenotipos.

La información del fenotipo es codificada de una manera específica (binaria, con frecuencia). Esta codificación constituye el genotipo. Cada conjunto de valores del genotipo recibe el nombre de cromosomas.

Se empieza un proceso iterativo, llamado evolución, en el cual el fenotipo de la población cambia a través de una serie de operaciones, llamadas operadores genéticos, entre los que se incluyen selección, recombinación o cruzamiento, mutación y reemplazo.

Para evaluar la idoneidad de un candidato a solución se define una función de aptitud, o simplemente función de evaluación, sobre los candidatos y que toma valores numéricos. La función se aplica en cada paso de la evolución y se espera que las soluciones sucesivas mejoren las propiedades de las generaciones anteriores. Este proceso se llama también evaluación de la descendencia.

Un aspecto importante a tener en cuenta en el diseño de los algoritmos genéticos es cómo codificar la información. Los operadores genéticos actuarán sobre la codificación de las propiedades de los candidatos a solución. La codificación tiene que ser lo suficientemente potente y flexible como para que recoja las propiedades y sea fácil aplicar los operadores genéticos. Véase el libro de Melanie Mitchell [Mit96] para más detalles técnicos sobre el diseño de algoritmos genéticos.

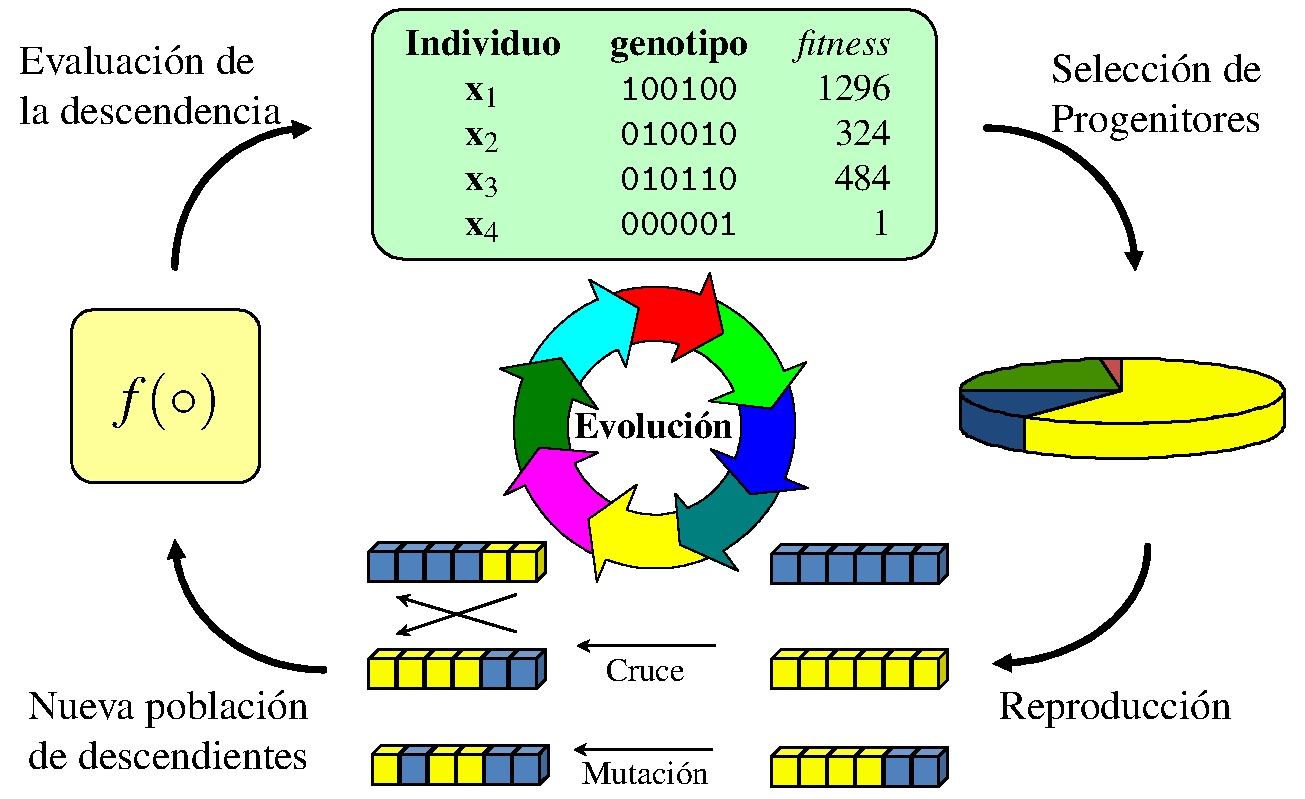

En la figura 1 se muestra un esquema del funcionamiento de un algoritmo genético.

Figura 1: Esquema del funcionamiento de un algoritmo genético (figura tomada de [Lat16])

Vamos a poner un ejemplo tomado de unas notas de clase bastante claras e instructivas publicadas por el Intelligent System Group de la Euskal Herriko Unibertsitatea [Int16]. La descripción del algoritmo se basará en la figura 2, que proporciona un pseudocódigo del algoritmo genético estándar.

Figura 2: Pseudocódigo de un algoritmo genético (figura tomada de [Int16])

Los algoritmos genéticos tratan de resolver problemas de optimización, con frecuencia la obtención de un máximo o mínimo global de una función. Como dijimos arriba, la población inicial representa las soluciones potenciales del problema. La codificación típica suele ser binaria, en parte porque es muy flexible y en parte por tradición histórica (Holland lo presentó así en su trabajo inicial [Hol92]). En nuestro ejemplo, usaremos también la codificación binaria. En realidad, la elección de la codificación depende en buena medida del problema. La analogía entre genotipo —la composición genética de un organismo—y el fenotipo —y la forma en que esa composición se expresa—se traslada aquí asignando a los valores de las variables independientes el papel del fenotipo y al de su codificación final el papel del genotipo. Los valores de las variables independientes, vistas como vectores numéricos, son los cromosomas. La función de adaptación sirve para evaluar la adaptación al problema de un cierto individuo (solución potencial al problema). La figura 3 ilustra estos conceptos para la función de una variable f(x) = x2. La primera columna es el número de individuo; la segunda contiene los fenotipos o valores de la variable independiente así como su codificación binaria o genotipo; la tercera columna, el valor decimal del genotipo; la cuarta columna muestra el valor de la función de adaptación.

Figura 3: Genotipo, fenotipo y función de adaptación (figura tomada de [Int16])

Durante la fase reproductiva (las iteraciones sucesivas del algoritmo), se seleccionan individuos de la población para cruzarse (véase la quinta columna de la figura 3). Dicho cruce ocurre por medio de los operadores genéticos. Una vez seleccionados dos individuos para cruzarse, sus cromosomas se combinan. El cruce y la mutación son dos de los operadores más frecuentes. En el operador de cruce se elige un punto al azar del cromosoma y se intercambian los códigos genéticos entre dos individuos; véase la figura 4.

Figura 4: Operador de cruce (figura tomada de [Int16])

El operador de cruce no se aplica a todos los individuos sistemáticamente, sino que se establece una función de probabilidad para determinar las parejas de individuos que sufrirán el cruce genético.

El otro operador, el de mutación, no consiste más que en cambiar un valor del cromosoma de un individuo. También lleva asociado una distribución de probabilidad. Se aplica a cada hijo, pero la probabilidad de mutación suele ser pequeña; véase la figura 5.

Figura 5: Mutación de un cromosoma (figura tomada de [Int16])

Si el algoritmo genético está implementado correctamente, entonces se supone que la adaptación media y la adaptación del mejor individuo se acercarán al máximo o mínimo global buscados. Normalmente, se toma como solución final la adaptación del mejor individuo.

2.2. Algoritmos genéticos aplicados a la composición musical

La composición a través de algoritmos genéticos despertó un gran interés desde principios de los años 90 y existe una gran variedad de caminos para usarla. Algunos de esos caminos son:

Composición de variaciones de un motivo o composición existentes [Ral95, Jac96].

Composición de música similar a otra composición dada [Hoc06].

Composición de solos o improvisación de melodías a partir de plantillas existentes (por ejemplo, se dan las duraciones o las secuencias de acordes) [Jac96, OE08].

Composición de las alturas y de las duraciones a la vez a través del algoritmo genético [Jac96, Bil94].

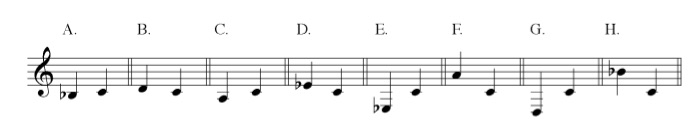

Veamos a continuación cómo pasar los elementos del algoritmo genético al contexto musical. En nuestro ejemplo tomaremos dos parámetros musicales: altura y ritmo. Para el caso de la altura, fijaremos el do central como nota de referencia y a partir de ella, contando en semitonos, codificamos las alturas; véase la figura 6.

Figura 6: Codificación de altura de sonidos

La duración se puede codificar de muchas maneras. A veces se codifica dando el tiempo en milisegundos; otras veces se define una duración mínima y todas las demás duraciones son múltiplos de esta; o también se puede usar el sistema del midi, donde se define el número de pulsos por negra en relación al tempo expresado en partes por minuto. En nuestro caso, supondremos que la duración mínima es la semicorchea y pondremos todas las duraciones en función de ella. Hay que añadir una variable que indique si estamos en presencia de un silencio o de una nota; será 0 si es silencio y 1 si es nota. Entonces, la codificación para el primer compás de la figura 6 es:

(0,0,2),(3,1,2),(6,1,2),(7,1,2),(8,1,6),(7,1,2)

donde el primer campo es la altura, el segundo el indicador de nota o silencio y el último la duración.

Elegir una función de adaptación que tenga significado musical es todavía un problema abierto. La música es demasiado compleja para que haya una función de expresión sencilla que produzca resultados aceptables. La forma general de la función de adaptación que se ha empleado en diversos sistemas es:

f = a1 ⋅ f1 + a2 ⋅ f2 + ...+ an ⋅ fn

donde cada fi es un factor musical del sistema y ai un peso que se da a dicho factor. Ejemplos de dichos factores podrían ser el número de intervalos disonantes, el número de apariciones de ciertos patrones interválicos, la frecuencia de ciertos intervalos, el rango de la melodía, entre muchos otros. La determinación de los pesos ai es también una cuestión muy delicada; no se sabe cómo elegirlos y normalmente se hace de una manera subjetiva o al menos aproximada. Esta fórmula implica que los factores fi tienen la misma preponderancia en todos los compases o en todas las partes de la composición. Se puede generalizar la función para que los pesos de los factores cambien de compás a compás. Si suponemos que la pieza tiene m compases la función es ahora

f = a11 ⋅ f1 + a21 ⋅ f2 + ...+ an1 ⋅ fn + ......+ a1m ⋅ f1 + a2m ⋅ f2 + ...+ anm ⋅ fn

donde el peso aij representa el peso del factor i en el compás j.

Los operadores genéticos se pueden definir de muchas maneras en la codificación musical. He aquí una breve descripción de las más frecuentes:

Cruzamiento de la melodía. Se toman dos melodías, se cortan en cierto puntos y se intercambian los fragmentos entre sí. La tonalidad se tiene en cuenta y se trasponen acorde a ella.

Mutaciones. En el ámbito de las alturas se tienen: cambios de octava en un tono (para evitar, por ejemplo, los intervalos grandes); cambio de un tono; cambio de una nota cromática. En el ámbito de las duraciones: cambios de las duraciones (con los correspondientes ajustes en el compás); cambio de figuración.

En la figura siguiente tenemos el resultado musical obtenido por Bruce Jacob [Jac96]. En este ejemplo se ha partido de unos motivos básicos que han constituido la población inicial. La función de evaluación incluye parte de evaluación humana.

Figura 7: Composición musical usando algoritmos genéticos (figura tomada de [Jac96]

En el siguiente vídeo tenemos una charla en la que se explica detalladamente una implementación de los algoritmos genéticos en Phyton:

En este otro vídeo se ve la evolución de una melodía. Los factores usados son autosimilitud, linealidad, tonalidad y rango.

Bibliografía

[Bil94] J.A. Biles. Genjam: A genetic algorithm for generating jazz solos. In Seventh International Conference on Genetic Algorithms, 1994.

[CLRS01] Thomas H. Cormen, Charles E. Leiserson, Ronald L. Rivest, and Clifford Stein. Introduction to Algorithms. McGraw-Hill Book Company, Cambridge, London, 2. edition, 2001. 1. editon 1993.

[Góm16a] P. Gómez. Composición algorítmica (i). Consultado en julio de 2016.

[Góm16b] P. Gómez. Composición algorítmica (ii). Consultado en octubre de 2016.

[HG91] A. Horner and D. Goldberg. Genetic algorithms and computer-assisted music composition. In Fourth International Conference on Genetic Algorithms, San Mateo, CA, 1991.

[HI79] L. A. Hiller and L. M. E. Knuth Isaacson. Experimental music: Composition with an electronic computer. Greeenwood Publishing Group Inc., 1979.

[Hoc06] R. Hochreiter. Audible Convergence for Optimal Base Melody Extension with Statistical Genre-Specific Interval Distance Evaluation. Lecture Notes in Computer Science, 3907, 2006.

[Hol92] John Holland. Adaptation in Natural and Artificial Systems. MIT, Cambridge, MA, 1992. Edición revisada de la de 1975.

[Int16] Intelligent System Group (EHU). Algoritmos genéticos. Consultado en octubre de 2016.

[Jac96] B.L. Jacob. Algorithmic Composition as a Model of Creativity. Organized Sound, 1(3):157–165, 1996.

[Knu73] Donald E. Knuth. The Art of Computer Programming, Volume I: Fundamental Algorithms, 2nd Edition. Addison-Wesley, 1973.

[Lat16] Proyecto Latin. Algoritmos genéticos clásicos. Consultado en octubre de 2016.

[Mit96] Melanie Mitchell. An Introduction to Genetic Algorithms. MIT Press, Cambridge, MA, 1996.

[OE08] E. Özcan and T. Erçal. A Genetic Algorithm for Generating Improvised Music. Lecture Notes in Computer Science, 4927, 2008.

[Ral95] D. Ralley. Genetic algorithm as a tool for melodic development. In Proceedings of the 1995 International Computer Music Conference, San Francisco, CA, 1995.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

Este es el segundo artículo de la serie composición algorítmica. En el primero [Góm16] exploramos la definición formal de algoritmo ([CLRS01, Knu73]) y proporcionamos algunos ejemplos (algoritmos de ordenación). Hicimos hincapié en la importante distinción entre algoritmo y código, distinción que de no hacerse en tiempo y forma convierte al estudiante de computación en un profesional superficial. En esta segunda entrega nos centraremos en la composición musical propiamente dicha. Merece la pena una reflexión y una formalización sobre el concepto de composición musical antes de entrar en las siguientes entregas, donde estudiaremos las principales corrientes dentro de la composición algorítmica.

2. La creación musical

La pregunta del título de la sección es, como era de esperar, complicada, llena de matices, y sin una respuesta cerrada. Se puede elaborar una respuesta desde una perspectiva histórica y ver cómo en una cultura determinada el concepto de composición ha evolucionado. También es posible estudiar la composición musical en varias culturas y resaltar sus diferencias y analogías. Por último, es posible especular sobre el concepto de composición de una manera abstracta. En este artículo combinaremos estos tres puntos de vista.

En su forma más simple, la composición musical es el proceso de crear música, lo cual deja la dificultad conceptual en el término música. En su definición más general, se puede decir que la música es una actividad artística y cultural cuyo medio es el sonido y el silencio. Si atendemos a las implicaciones artísticas y culturales de esta definición, entonces hemos de admitir que la música no existe en sí misma sino en cuanto significado construido por seres humanos, en cuanto constructo cultural. La experiencia musical consiste en un diálogo entre el oyente y la composición musical en que aquel ha de estar dispuesto a dejar que la música le hable, le muestre su sentido interno, su significado último. En esa escucha el oyente verá cuestionadas sus expectativas musicales y ello producirá progreso en el discurso musical percibido. Y es en este diálogo entre oyente y música que se produce el significado musical. Véase [Cli83] para una discusión más en profundidad de estas cuestiones.

La definición de música implica a su vez que el sonido tiene algún tipo de organización para poder ser clasificado como música. Y aquí aparece la fascinante cuestión de si la música es un fenómeno universal o un constructo cultural. Algunos autores sostienen que existen ciertos universales musicales; he aquí algunos que aparecen en la bibliografía:

Ideales musicales que poseen una estructura profunda;

Estrategias para agrupar el sonido;

El uso de alturas de referencia para crear estabilidad;

La división de la octava para crear escalas;

El uso de pulsos de referencia;

La formación de patrones rítmicos a través de la división asimétrica de pulsos temporales.

Otras investigaciones apuntan a que la música tiene aspectos típicos de un constructo cultural. Ciertas obras han sonado como ruido al público de una determinada época pero más tarde fueron comprendidas y subidas al rango de música. Ejemplos de obras así son la La gran fuga opus 133 de Beethoven, La consagración de la primavera de Stravinsky, Ionisation de Varèse, entre otras muchísimas. Recomendamos vivamente al lector el libro de Slonimsky Lexicon of Musical Invective: Critical Assaults on Composers Since Beethoven’s Time [Slo00] para una recopilación de obras que sonaron “ruidosas” en su estreno —y cuyos críticos masacraron inmisericordemente en las recensiones— per que más tarde fueron reconocidas en su justa valía. Para más información sobre los aspectos culturales de la música y en particular sobre la función social de la música, véase el libro de Radocy y Boyle [RB06] y las citas contenidas en él.

Si atendemos a otras culturas que no sean la occidental, veremos que muchas no tienen el concepto de música como género artístico. La música tiene una componente funcional muy fuerte y es sencillamente parte de la vida cotidiana. No poseen un grupo de miembros de su cultura que se dedica en exclusiva a la música, sino que todos los miembros de esa sociedad participa en distinto grado en el fenómeno musical. Además, la mayor parte de las culturas son de transmisión oral y no se pueden describir con la notación musical occidental.

Si la música implica la organización del sonido, tendremos qué señalar qué parámetros del sonido son susceptibles de dicha organización. En las próximas secciones daremos aquellos parámetros más comunes y aportaremos ejemplos para ilustrarlos.

2.1. Altura del sonido y melodía

La altura del sonido se refiere a la cualidad que nos hace distinguir un sonido grave de uno agudo; dicha cualidad está relacionada con la frecuencia. Un sonido complejo puede estar formado por la superposición de varias frecuencias simultáneas. Cuando un sonido tiene una frecuencia clara y estable hablamos más bien de notas, como por ejemplo las notas de la mayor parte de los instrumentos musicales (la caja clara, por ejemplo, no tiene una frecuencia definida). En muchas culturas la organización del sonido en notas es la base de su estructura musical. La elección de las notas se obtiene dividiendo la octava en partes fijas. Es muy frecuente encontrar escalas pentatónicas (de cinco sonidos) y heptatónicas (de siete sonidos). La octava se divide en doce semitonos en la música occidental; en otras tradiciones musicales, como la árabe se divide en más partes que doce, lo hace en diecisiete.

Asociada a la altura del sonido está la melodía, que en su definición más amplia es la presentación de una sucesión de tonos. Hay dos aspectos a considerar aquí: las relaciones entre las notas, sobre todo entre las notas consecutivas, y su duración en el tiempo. Obviamente, no toda sucesión de notas constituye una melodía. Autores como Lundin [Lun67] ya propusieron atributos como propincuidad, repetición y finalidad para definir con más precisión el concepto de melodía. Propincuidad alude a la propiedad de que la melodía principalmente se mueva por grados conjuntos dentro de la escala; repetición se refiere a que la melodía repita partes de ella a fin de consolidar su percepción; y finalidad significa que la melodía tenga ciertas intenciones musicales que le den coherencia. Ilustremos con un ejemplo lo anterior; en la figura 1 tenemos la melodía del capricho número 24 de Paganini.

Figura 1: Melodía del capricho número 24 de Paganini

Se trata de un tema con variaciones y lo que está en esta figura es la melodía principal el tema. El tema, que está en la menor, tiene dos partes claras, que hemos llamado antecedente y consecuente. El antecedente está armonizado con una alternancia de tónica-dominante (grado I y grado V de la escala, respectivamente). La función del antecedente es presentar el material melódico principal, que en este caso es un pequeño motivo que se repite constantemente; ese motivo tiene el rango de una tercera y se mueve principalmente por grados conjuntos (propincuidad y repetición). El consecuente presenta variación melódica del antecedente, creando tensión. La armonización del consecuente es (repetida dos veces):

I–IV–VII–III–VI-II-V–I

El consecuente termina con una cadencia implicada por la melodía (II–V–I) que sirven para reforzar el sentido conclusivo de la melodía (finalidad). Como vemos en el breve análisis de esta melodía, las tres características mencionadas arriba están presentes. En el vídeo de la figura 2 tenemos la interpretación del capricho entero con la partitura.

Figura 2: Capricho número 24 de Paganini (vídeo con partitura)

El ejemplo anterior está tomado de la música occidental. En otras culturas el concepto de melodía puede variar bastante y de nuevo aparece el debate de los universales musicales versus los constructos culturales. En el siguiente ejemplo tenemos el placer de escuchar una pieza de shakuhachi, una flauta de bambú que se usa en la música tradicional japonesa (en el vídeo hasta el minuto 6:05).

Figura 3: Música tradicional japonesa para shakuhachi (flauta de bambú)

En este caso la melodía se desvía de algunas de las características señaladas más arriba. Ya no hay tanto movimiento por grados conjuntos; de hecho, abundan los saltos. El timbre desempeña un papel muy importante y hay transiciones continuas entre notas (portamenti). La repetición motívica no está presente como en el caso de Paganini. Sin embargo, el sentido de finalidad es claro en la pieza.

Varios autores, tras el análisis de melodías de numerosas culturales, llegan al consenso de que una melodía tiene los siguientes atributos estructurales: (1) primera y última nota; (2) nota más grave y más aguda; (3) notas repetidas; (4) tamaño de los intervalos melódicos; (5) dirección melódica (contorno melódico); (6) proximidad entre notas; (7) énfasis en grupos de notas; (8) las relaciones interválicas; (9) grado de énfasis en las notas. Véase [RB06], página 209 y siguientes para una discusión sobre las características estructurales de la melodía.

2.2. Armonía

La melodía representa la dimensión horizontal de las notas y la armonía, en cambio, la dimensión vertical; esto es, cómo suenan varias notas al mismo tiempo. La armonía es particularmente importante en la música occidental, pero no lo es en otras tradiciones musicales. Muchas tradiciones no occidentales no tienen armonía alguna o está basada en escalas distintas a las occidentales con funciones distintas también. Es muy común la música monofónica (una sola voz) y la música heterofónica (con más de una voz, con variaciones de una sola línea melódica).

Varios autores (Lundin [Lun67] y otros) mantienen que la respuesta a la armonía es un fenómeno cultural. Se sabe que la respuesta a la armonía se produce a la totalidad y no a cada acorde individual. Solo a través de un entrenamiento especial el oyente puede reconocer y analizar los acordes individualmente. Hay tres atributos que son importantes en la armonía: la tonalidad, el movimiento armónico y la finalidad. Tonalidad se refiere aquí a la organización armónica alrededor de un tono especial, que tiene mayor relevancia y que representa el centro tonal de la pieza. Típicamente, cuando se dice que una obra está en do mayor, por ejemplo, estamos especificando el centro tonal, la nota do, y la escala, la escala mayor.

En la música occidental el movimiento armónico es un fenómeno relativo que ocurre en función de la tonalidad de referencia. Existen ciertas convenciones, que han cambiado a lo largo de la historia, sobre cómo enlazar los acordes entre sí. En el ejemplo del vídeo de la figura 4 podemos apreciar el movimiento de los acordes en el rondo a la turca de Mozart de su sonata KV 331. Los acordes en ese vídeo se han representado por números romanos, donde cada número representa un grado de la escala; los números en mayúsculas son los acordes mayores y los que van en minúsculas, los acordes menores. El lector se percatará de que en muchos compases solo hay un acorde y de que cuando Mozart quiere crear tensión aumenta el ritmo al que los acordes cambian.

Figura 4: Movimiento armónico en el movimiento final del rondo a la turca de Mozart, KV 331

Asimismo, el lector apreciará que hay un gran sentido de la finalidad en la elección de los acordes, el cual acompaña igualmente a la melodía. El uso de ciertas cadencias al final de las frases es un ejemplo de ello (los acordes con sextas aumentadas, la progresión ii-V-I). Las cadencias son secuencias de acordes que se usan para el fin de una frase, sección o pieza musical.

2.3. Ritmo

El ritmo es todo aquello que se refiere a la cualidad temporal de la música. En sí el ritmo es un elemento unificador de los otros aspectos musicales. Hay muchas teorías del ritmo, más de las que podemos glosar con solvencia en el breve espacio de este artículo. En general, los investigadores coinciden en que las propiedades del ritmo incluyen: (1) tempo o velocidad a que va la pieza; (2) las duraciones de las notas; (3) las relaciones de agrupamiento; y (4) la métrica. Por relaciones de agrupamiento nos referimos a conjuntos de duraciones que en función de mecanismos perceptuales (leyes de continuación y otras leyes de psicología de la forma) son percibidas como un todo. La métrica es más difícil de explicar y hay que tener en cuenta que es un constructo típico de la música occidental; la mayor parte de las tradiciones musicales carecen de la métrica tal cual la conocemos en la cultura occidental. La manera de marcar el compás en la música occidental es por medio de una fracción. El denominador indica la figura rítmica básica (corchea, negra, blanca, etcétera). El numerador indica el número de esas unidades rítmicas por compás. Así un compás de 3/4 indica que cada compás tiene tres negras (el 4 es el número de la negra). Pero el numerador aporta más información que el número de partes. Nos dice que hay un patrón de partes en que la primera es acentuada y las dos siguientes no, esto es, un patrón fuerte-débil-débil. Observe el lector que en la música occidental se supone que hay un pulso regular, en nuestro ejemplo, de negras, y que la métrica impone un patrón de acentos sobre dichos pulsos. Cuando un patrón rítmico contradice la métrica durante un periodo corto de tiempo se dice que es una síncopa.

Cambiando las duraciones de los patrones rítmicos se consigue generar relaciones de tensión y relajación en la música. Como ejemplo, veamos en el canon en re de Pachelbel cómo los cambios en las duraciones dan cohesión y dinamismo a la pieza. El vídeo es autoexplicativo.

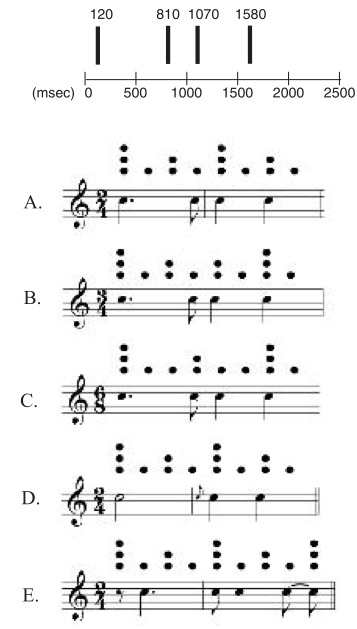

Figura 5: Las transformaciones rítmicas en el canon en re de Pachelbel

Consideremos ahora un ejemplo tomado de una tradición musical donde el ritmo tiene otra concepción muy distinta a la occidental. En la música occidental la armonía ha restringido el desarrollo rítmico porque los cambios de acordes suelen producirse en las partes fuertes, sobre todo a principio de compás. En otras culturales el ritmo ha alcanzado cotas altísimas de desarrollo. En el gahu, que es música de la cultura Ewe de Ghana, el ritmo posee un papel primordial. Este género está asociado a la danza y al canto y su instrumentación consiste en tambores de distintos tamaños, campanas (gankoguis) y voz (coros). En la tradición musical de los Ewe existe el concepto de pulso, pero no el de métrica; además los ritmos no se piensan de modo divisivo sino más bien aditivo. La campana gankogui toca un ritmo que actúa de elemento unificador. Cada tambor (sogo, kidi y kaganu) toca un ritmo y debido a las texturas de los tambores y a los acentos de los ritmos surgen melodías rítmicas, si así podemos llamarlas; en la figura 6 aparece una transcripción de los ritmos básicos del gahu con círculos en esas melodías rítmicas. Para un estudio serio y profundo del gahu recomendamos el libro Drum Gahu: An Introduction to African Rhythm [Loc98] del etnomusicólogo David Locke.

Figura 6: Transcripción a notación occidental del gahu

En el vídeo de la figura 7 el lector puede disfrutar de una interpretación de gahu.

Figura 7: Danza gahu en el Teatro Nacional de Ghana

Otra tradición que se basa fuertemente en el ritmo es la japonesa, con sus famosos tambores taiko. Los tambores taiko varían desde aquellos con 30 centímetros de diámetro hasta los de un metro y medio de diámetro. Los patrones rítmicos, los acentos, la textura y la velocidad son los parámetros con que juega este género; la melodía y la armonía están ausentes en este género. En la figura 8 podemos ver una actuación con tambores taiko.

Figura 8: Actuación de percusionistas de taiko

2.4. Textura

La textura musical es el resultado final en términos de sonido que percibimos al escuchar una pieza musical. Es la suma de los sonidos individuales. Una pieza para un instrumento solo tiene una textura simple comparada a una pieza de orquesta. Se habla, pues, de textura más densa o menos densa en función de las voces que intervienen en la pieza en concreto. La textura, empero, no depende solo del número de voces, sino que es función también de la melodía, la armonía, el ritmo y de cómo se combinan entre sí. Por ejemplo, voces que no se contradicen entre sí musicalmente o que no crean tensión entre sí dan la sensación de una textura más ligera.

Atendiendo al número de voces, clasificamos las texturas en monofónicas, heterofónicas, polifónicas y homofónicas. Las texturas monofónicas están compuestas de una única voz. En el ejemplo de más abajo tenemos al extraordinario Agujetas cantando un martinete a capella.

Figura 9: Monofonía ilustrada con unos martinetes cantados por Agujetas

En la heterofonía dos instrumentos o voces tocan la misma melodía, pero uno de los intérpretes hace variaciones de dicha melodía. Este tipo de textura es común en tradiciones no occidentales tales como el bluegrass o el gamelán (música tradicional de Indonesia). En el siguiente vídeo podemos ver un ejemplo de heterofonía con el gamelán.

Figura 10: Heterofonía en la música de gamelán

Las texturas polifónicas se dan cuando varias voces independientes se combinan entre sí. La música coral del Renacimiento y de buena parte del Barroco tenían esta escritura. En las texturas polifónicas la armonía toma un papel especialmente importante pues ha de regir cómo combinar las voces de manera acorde al estilo dado. En el vídeo siguiente tenemos un ejemplo de una gran tradición polifónica, los cantos de Georgia (el país de Europa Oriental; no confundir con el estado del mismo nombre en EEUU).

Figura 11: Polifonía en la tradición vocal de Georgia

Por último, la textura homofónica, que es similar a la polifónica pero ahora una de las voces toma el protagonismo melódico y el resto proporciona soporte armónico. Otra manera de describirlo es decir que la textura homofónica es melodía con acompañamiento. El ejemplo dado en la figura 4, con el rondo a la turca de la sonata KV 331 de Mozart, es textura homofónica.

2.5. Timbre

El timbre es la cualidad característica de cada instrumento en términos de su sonido. Una misma nota tocada en un violín suena distinta a la de una flauta porque cada instrumento produce distintos armónicos (las frecuencias secundarias asociadas a una nota). Los compositores siempre tienen una gran preocupación por el timbre de su música. En una orquesta sinfónica hay muchos grupos de instrumentos y la combinación sonidos es importante en el discurso musical. Como ejemplo llamativo de textura musical, sugerimos al lector la escucha del concierto para violín, percusión y mesa de ping-pong de Andy Akiho, obra de 2015. Sí, ha leído bien el lector, mesa de ping-pong.

Figura 12: Concierto para violín, percusión y mesa de ping-pong

2.6. Forma

En general, la música no occidental tiene una forma más libre que la música occidental. Ello es comprensible dado que muchas tradiciones musicales no occidentales se basan en la improvisación de un material previo. Por forma entendemos la estructura de una pieza y por estructura, la organización del material a nivel local, digamos al nivel de frase, hasta al nivel de la misma pieza, como cuando describimos esta por sus secciones. Ejemplos de formas que han surgido a lo largo de la historia de la música occidental son las formas de danza (allemande, bourrée, chaconne, gavotte, menuet, entre otras), la fuga, la invención, la sonata, el tema y las variaciones, el concierto, la sinfonía concertante y la sinfonía. Además, varios de estas formas evolucionaron a los largo de la historia; no es lo mismo la forma sonata en el clasicismo temprano que en el post-romanticismo.

En una forma dada se especifican las secciones y el material que hay en ellas. En una forma sonata típica hay una sección de exposición en la que se presentan dos temas. Después de exponer el primer tema en la tonalidad de la pieza, es frecuente que el segundo tema aparezca en la dominante. La exposición de estos dos temas constituye la llamada sección A de la sonata o sección de exposición; se suele repetir dos veces. Tras la sección A viene la sección del desarrollo, que es una sección mucho más libre, donde se modula a otras tonalidades y se desarrolla motívicamente los temas de la sección A. La sección del desarrollo desemboca en la reexposición de la sección A. En esta segunda exposición es normal que el segundo tema se presente en la tonalidad de la pieza para dirigirnos a su conclusión. A veces la sonata termina con una coda o pasaje de carácter conclusivo donde se resume el material presentado en la pieza. La estructura de la sonata es, pues, A+A+B+A+C. En el vídeo siguiente tenemos los conceptos anteriores explicados sobre la sinfonía número 29 de Mozart.

Figura 13: La forma sonata con la sinfonía número 29 de Mozart

Otro ejemplo menos ortodoxo es el que se puede ver en el vídeo de más abajo, que es la forma musical en el tema Overworld del videojuego Mario Bros. En este caso la estructura es

Introducción+A+B+B+C+Introducción+A+D+D+C+D

Figura 14: Forma musical en el tema Overworld del videojuego Mario Bros.

3. ¿Qué es composición musical?

Tras todo lo visto hasta ahora comprendemos que el concepto de composición musical es muy amplio. Implica la elección de unos cuantos parámetros musicales y su manipulación para conseguir una organización del sonido que sea significativa. El término significativo aquí estará muy en función del contexto cultural. Composición se puede entender como improvisación, como por ejemplo en el caso de muchas tradiciones orales, o bien como una obra escrita en notación hasta sus últimos detalles. Los ejemplos que nos aguardan en las siguientes entregas de esta serie, donde examinaremos la composición algorítmica, requerirán de un concepto muy flexible de composición.

Bibliografía

[Cli83] Thomas Clifton. Music as Heard: A Study in Applied Phenomenology. Yale University Press, 1983.

[CLRS01] Thomas H. Cormen, Charles E. Leiserson, Ronald L. Rivest, and Clifford Stein. Introduction to Algorithms. McGraw-Hill Book Company, Cambridge, London, 2. edition, 2001. 1. editon 1993.

[Góm16] P.. Gómez. Composición algorítmica (i). http://vps280516.ovh.net/divulgamat15/index.php?option=com_content&view=article&id=17290&directory=67, consultado en julio de 2016.

[Knu73] Donald E. Knuth. The Art of Computer Programming, Volume I: Fundamental Algorithms, 2nd Edition. Addison-Wesley, 1973.

[Loc98] David Locke. Drum Gahu: An Introduction to African Rhythm. White Cliffs Media, Gilsum, New Hampshire, 1998.

[Lun67] R.W. Lundin. An objective psychology of music. Ronald Press, 1967.

[RB06] Rudolf E. Radocy and J. David Boyle. Psychological Foundations of Musical Behavior. Charles C Thomas, Illinois, 2006.

[Slo00] Nicolas Slonimsky. Lexicon of Musical Invective: Critical Assaults on Composers Since Beethoven’s Time. W W Norton & Co Inc., 2000.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

Este artículo inaugura una serie sobre un tema apasionante: la composición algorítmica. Si queremos una definición concisa y breve, diríamos que la composición algorítmica se refiere al uso de algoritmos para la composición musical. En este viaje pretendemos que nuestros lectores, tanto músicos como matemáticos y en general cualquier lector curioso, comprendan los fundamentos de la teoría de algoritmos, de la composición musical y en última instancia cómo se han usado los algoritmos para componer música. En esta primera entrega trataremos los algoritmos y su definición formal y daremos ejemplos. En la segunda entrega examinaremos la definición de composición musical y sus características. En las siguientes entregas estudiaremos las principales corrientes dentro de la composición algorítmica.

2. ¿Qué es un algoritmo?

El concepto de algoritmo está asociado a la resolución de problemas. Desde este punto de vista, los algoritmos son una manera de pensar. En general, esos problemas han de ser susceptibles de ser cuantificables numéricamente y resolubles por medios matemáticos. Por ejemplo, cuando nos referimos al algoritmo de Euclides [Wik] estamos hablando de un procedimiento para resolver el problema de hallar el máximo común divisor de dos números. Sin embargo, no toda solución de un problema es un algoritmo. La solución necesita tener unas características especiales, como vamos a ver enseguida. La definición de algoritmo ha ido evolucionando según el nivel científico de la época, desde los tiempos del matemático al-Khwarizmi (siglo IX d.C.) en que algoritmo se refería a reglas aritméticas de cálculo, pasando por la formalización de Touring, hasta llegar a la definición de Donald Knuth [Knu73], una de las más aceptadas modernamente y que seguiremos aquí. Dado un problema a resolver, un algoritmo es un procedimiento que toma una entrada o valores iniciales del problema y, después realizar una serie de operaciones bien definidas, produce una salida o solución del problema. La definición de Knuth identifica cinco propiedades que un algoritmo ha de tener:

Entrada: Los valores iniciales del problema.

Precisión: Todo algoritmo tiene que estar definido de manera precisa de modo que no haya ambigüedad. En particular, los algoritmos están basados en un conjunto normalmente pequeño de operaciones básicas, que se suelen llamar operaciones primitivas. Estas suelen ser las operaciones matemáticas y reglas lógicas.

Finitud: Todo algoritmo tiene que terminar después de un número finito de pasos (y cuanto menor sea ese número, mejor).

Salida: Todo algoritmo ha de devolver un resultado.

Efectividad: Las operaciones que intervienen en el algoritmo han de ser suficientemente básicas.

Por supuesto, todo algoritmo que (aparentemente) resuelva un problema tiene que ir acompañado de una prueba matemática de que, en efecto, resuelve tal problema. Puesto que un algoritmo tiene que terminar en un número finito de pasos, los problemas que pueden resolverse de manera algorítmica deben tener una cierta naturaleza discreta (los problemas debe ser o bien finitos o bien si son infinitos tener una caracterización finita). Por ejemplo, el problema de enumerar todos los números primos implica dar una salida que es infinita y, en la definición dada aquí, no hay algoritmo que realice tal tarea. Sin embargo, para calcular el máximo común divisor de dos números sí es posible diseñar un algoritmo para resolver tal problema. El máximo divisor de dos números siempre existe y es un número finito comprendido entre los divisores de ambos números.

Un problema inherente a los algoritmos es su descripción. Los algoritmos pueden expresarse de muchas maneras: en primer lugar, en lenguaje natural, pero también como pseudocódigo y en última instancia en términos de un lenguaje de programación. Un algoritmo se puede ver como una serie de reglas formales para resolver un problema y su descripción es la enumeración de dichas reglas en el lenguaje apropiado. El inconveniente que surge al describir un algoritmo con lenguaje natural es que el grado de ambigüedad en su descripción puede ser demasiado alto porque el lenguaje natural es ambiguo. Consideremos el problema siguiente:

Problema: Dado un conjunto M de n números reales y otro número x, determinar si x está en el conjunto M.

Este problema es conocido como el problema de la búsqueda. Supongamos que los elementos de M son M[1],M[2],…,M[n]; note el lector que nos referimos a los elementos de M a través de un índice en notación matricial. Una manera de describir un algoritmo en lenguaje natural sería la siguiente:

Algoritmo en lenguaje natural: Para cada elemento M[i] de M, con i = 1 hasta i = n, comprobar si dicho elemento es x.

Se puede apreciar que en esta descripción aparecen las características de la definición de algoritmo dadas anteriormente. Empero, esta descripción es más abstracta e ignora ciertos detalles técnicos. La idea que transmite es de que la solución se encuentra comparando cada elemento de M con x. Con frecuencia la descripción en lenguaje natural no es suficiente para detallar las ideas detrás de un algoritmo y a veces tampoco para probar su corrección. El siguiente paso es definir una serie de operaciones básicas y estructuras de datos con que describir el algoritmo. Esa descripción se llama pseudocódigo. Por ejemplo, el siguiente pseudocódigo corresponde al algoritmo de búsqueda.

BÚSQUEDA-LINEAL(M, x)

1

i ← 1

2

while i ≤ length(M)

Bucle que recorre la matriz

3

if M[i] = x then

Comprueba si x es el elemento i

4

r ← i

5

i ← length(M) + 2

Fuerza la salida del bucle

6

if i = length(M) + 1 then r = -1

7

return r

Figura 1: El algoritmo de búsqueda lineal

La entrada está especificada en la línea BÚSQUEDA-LINEAL(M, x) y es el conjunto M y el número x. El cuerpo del pseudocódigo contiene instrucciones de control, tal como el bucle while o la sentencia condicional if. En el pseudocódigo ya aparecen objetos matemáticos, tales como variables (la variable i), y operaciones entre ellos, tales como la asignación de valores, con el operador ← (líneas 4 y 5), o la comparación de valores, con el operador = (línea 6). La salida se produce en la línea 7 con la instrucción return. Este pseudocódigo facilita la prueba de la corrección del algoritmo. En este artículo no entraremos en la delicada cuestión de la prueba de algoritmos. Recomendamos al lector interesado acudir al magnífico libro de Cormen, Leiserson y Rivest [CLRS01] Introduction to Algorithms para profundizar en este importante tema.

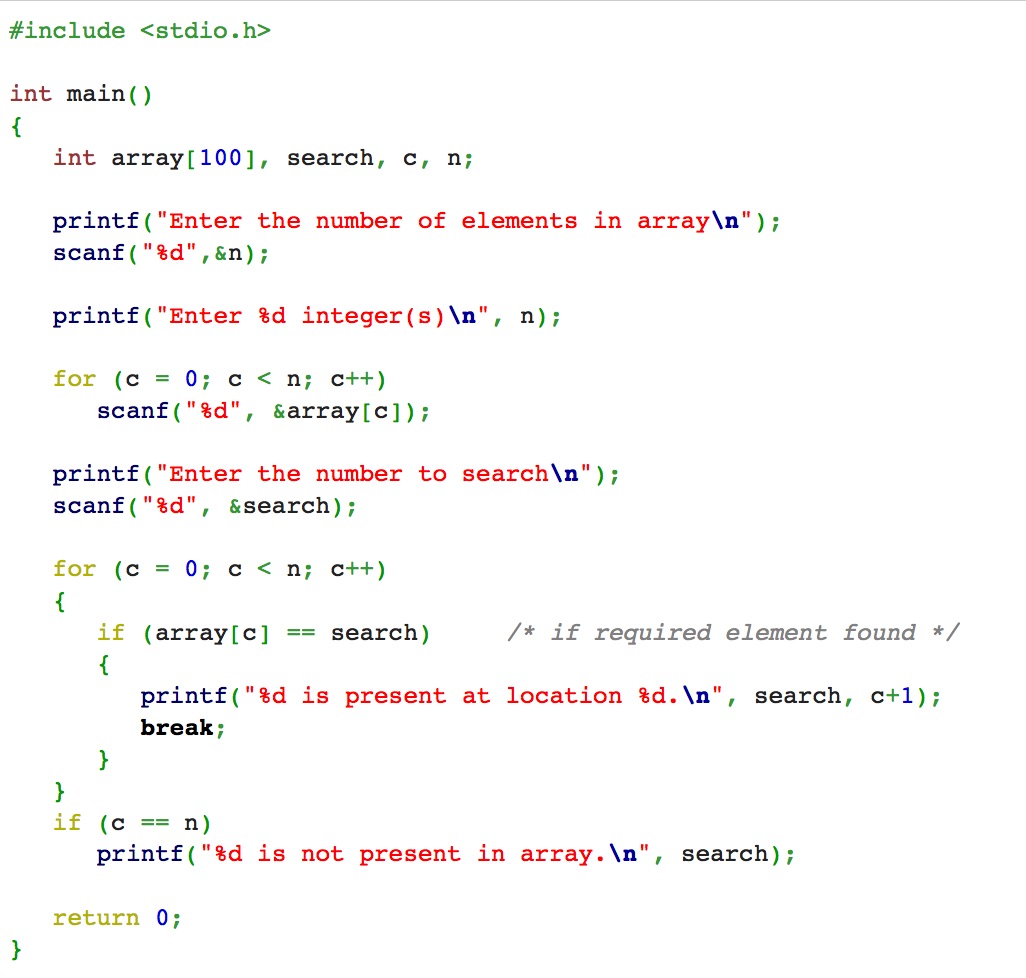

En la figura 2, por último, tenemos el algoritmo codificado en lenguaje C. Como se puede observar ya no hay lenguaje natural y los detalles del algoritmo están entreverados con los detalles propios del lenguaje. Para más información sobre programación de algoritmos en lenguajes de programación, véanse [GBY91, Sed90].

Figura 2: Búsqueda lineal codificada en lenguaje C.

El orden natural de abstracción es el presentado aquí. Primero se describe el algoritmo en lenguaje natural; se comprueba que las ideas contenidas en esa solución algorítmica descrita en lenguaje natural son correctas y que poseen esa naturaleza algorítmica, que cumplen con la definición de Knuth. Después se escribe en pseudocódigo y se prueba formalmente el algoritmo; la prueba ha de ser una prueba matemática, que con frecuencia es por inducción. Por último, se codifica en el lenguaje de programación elegido.

Un aspecto que no tratamos aquí es el de la complejidad de los algoritmos. La complejidad de un algoritmo es una medida del tiempo que tarda en resolver el problema en función del tamaño de la entrada. Para los propósitos de esta serie de artículos, la complejidad no desempeña un papel importante. El lector interesado puede consultar el libro de libro de Cormen, Leiserson y Rivest [CLRS01].

3. Algoritmos y música

La música, como ya hemos dicho muchas veces, es un fenómeno muy complejo, compuesto por una multitud de otros fenómenos provenientes a su vez de otros campos. La música tiene una dimensión física, pues es sonido. Ese sonido es oído por el ser humano que lo procesa según leyes básicas de la percepción pero también a través del crisol cultural, el cual puede incluir desde la exposición a un estilo determinado hasta la asociación emocional con la música. Para un estudio profundo y exhaustivo de todas estas cuestiones, recomendamos al lector la lectura del libro de Radocy y Boyle [RB06].

Pero la música posee una riqueza interminable en términos de patrones y estructuras y, por tanto, puede ser objeto de estudio de las matemáticas. Muchos de los fenómenos que constituyen la música son matematizables (por ejemplo, la armonía a través de la teoría de grupos) y en buena medida susceptibles de tratamiento algorítmico. En la mayoría de las culturas, la altura de sonido está discretizada. En el caso de la música occidental, al menos en la práctica común, se tiene una división de la octava en 12 notas. Esta discretización del continuo de la altura de sonido permite ya tratamiento algorítmico. En las duraciones de las notas, la situación es similar. El conjunto de duraciones posibles es finito y relativamente pequeño. Todo esto permite que se pueda modelizar la música (algunos aspectos de la música) matemática y algorítmicamente.

Los algoritmos de ordenador suelen tratar la música usando un formato llamado MIDI. Existe una asociación [Ass], The Midi Association, en cuya página web el lector encontrará abundante información sobre este importante estándar. El estándar MIDI no es solo una manera de codificar la música sino que también se ocupa de la comunicación entre instrumentos que funcionan con este estándar.

Un fichero MIDI contiene al menos la siguiente información: ataques de las notas, duración de las notas, altura de sonido como nota en una escala de igual temperamento, la voz en que suena la nota, la intensidad de volumen de la nota, la letra asociada (si la hay) y la información de los acordes.

Una vez que la música está codificada en formato numérico las posibilidades son infinitas. Todas las técnicas matemáticas están al servicio del tratamiento de la información musical, en particular al servicio de la composición musical a través de algoritmos. En el próximo artículo examinaremos los fundamentos básicos de la composición musical de modo similar a como hicimos en este artículo con los algoritmos.

Bibliografía

[Ass] The Midi Association. The Midi Associaton.

[CLRS01] Thomas H. Cormen, Charles E. Leiserson, Ronald L. Rivest, and Clifford Stein. Introduction to Algorithms. McGraw-Hill Book Company, Cambridge, London, 2. edition, 2001. 1. editon 1993.

[GBY91] G.H. Gonnet and R. Baeza-Yates. Handbook of Algorithms and Data Structures. Addison-Wesley, 1991.

[Knu73] Donald E. Knuth. The Art of Computer Programming, Volume I: Fundamental Algorithms, 2nd Edition. Addison-Wesley, 1973.

[RB06] Rudolf E. Radocy and J. David Boyle. Psychological Foundations of Musical Behavior. Charles C Thomas, Illinois, 2006.

[Sed90] R. Sedgewick. Algorithms in C. Addison-Wesley, Reading, MA, 1990.

[Wik] Wikipedia. Euclidean algorithm.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Kristy Yun y Mariana Montiel (Georgia State University)

Este mes vamos a presentar un trabajo hecho por Kristy Yun y Mariana Montiel, de Georgia State University, en Atlanta (donde estoy pasando mi sabático). Kristy es una estudiante de licenciatura que está a punto de obtener su título. En las universidades americanas los estudiantes de licenciatura acuden a unas conferencias llamadas conferencias de investigación para alumnos de grado. En esas conferencias los alumnos de licenciatura presentan pequeños proyectos de investigación supervisados por un profesor. Ni en el campo de las matemáticas ni en el de la música existen en España estas conferencias. Y es una pena. Primero, habla del nivel de nuestras universidades. ¿Es que no pueden nuestros alumnos de los últimos años de grado adentrarse en el mundo de la investigación y presentar pequeños resultados en una conferencia de estas características? Constituyen una experiencia previa para ellos que es muy valiosa en tantos aspectos: se enfrentan a problemas de investigación; se prueban a sí mismos; conviven con su profesor; supone una gran emoción presentar su trabajo antes sus compañeros (normalmente, en forma de póster o de comunicación corta); ponen en práctica sus habilidades de escritura y orales, entre otras.

Me llamó la atención el trabajo de Kristy Yun y Mariana Montiel en la conferencia de este año y les propuse publicarlo en formato divulgativo en esta columna. Les agradezco profundamente que hayan aceptado la invitación. Espero que este ejemplo cunda y empecemos a celebrar este tipo de conferencias para alumnos de licenciatura en España también de modo generalizado. Los investigadores más productivos que he conocido siempre han tenido una amplia red de alumnos a su alrededor con quienes han desarrollado relaciones personales excelentes y en quienes han podido depositar sus ideas para llevarlas a cabo, todo ello en el contexto de una cálida simbiosis humana y científica.

Paco Gómez Martín (Universidad Politécnica de Madrid)

Resumen del estudio

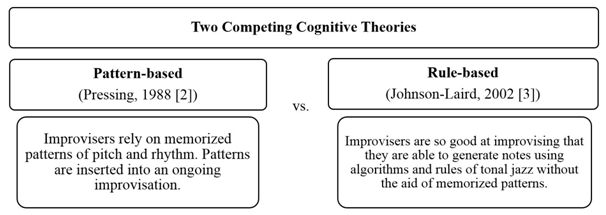

Las improvisaciones en el jazz consisten en ciertos patrones rítmicos y melódicos que oímos en cierto orden. Por medio del estudio de la genésis de estos patrones podemos entender el proceso de la toma de decisiones en tiempo real en el contexto de una estructura dada en que consiste la improvisación. No hay teorías que describan a fondo y con precisión la improvisación, pero entre las existentes destacan dos escuelas de pensamiento: una es la teoría basada en patrones; la otra se basa en gramáticas o reglas. La primera teoría propone que los improvisadores se nutren de un corpus de patrones rítmicos y melódicos memorizados y que dichos patrones se insertan en el proceso de una improvisación en curso dentro de unas ciertas reglas de estilo. Otra teoría, encontrada con la primera, asevera que los improvisadores generan notas por medio de los algoritmos y las reglas del jazz tonal, sin la ayuda de patrones memorizados. Para comprobar la validez de estas teorías, en un estudio previo [7] llevado a cabo por Martin Norgaard y sus coloaboradores se analizó un corpus de 48 solos improvisados por el gran saxofonista de jazz Charlie Parker. Los resultados del estudio mostraron que la incidencia de patrones en el corpus de Charlie Parker coincide con el algoritmo basado en patrones implementado en ese estudio. En cambio, las improvisaciones generadas por Impro-Visor, un software desarrollado en base a gramáticas y reglas tomadas de los acordes musicales introducidos por el usuario, no generó una presencia de patrones similar a la del corpus real de Parker. En vista de los resultados positivos del algoritmo, el siguiente paso era la incorporación de acordes; sin embargo, se quería evitar que dichos acordes dictasen la melodía y el contorno de la salida musical de manera excesivamente estricta, ya que la coincidencia de patrones era muy apegada a las improvisaciones de Parker. Se vio que una posible solución era el empleo de modelos de Markov no homogéneos, en que los acordes se entendiesen como restricciones. Cabe mencionar que podría haber aplicaciones de ese algoritmo que transcendiesen el género de jazz y aún la música, ya que se basa en patrones. La creatividad en áreas tales como los video juegos se puede modelar, dado que los jugadores deben responder de forma creativa en tanto adquieren ciertos patrones de respuesta con restricciones inherentes al contexto.

Introducción

Normalmente, cuando los músicos profesionales de jazz tocan en pequeños grupos no leen partituras, sino que improvisan. Los ejecutantes escogen frases que al público podría parecerles prescritas, pero que realmente se crean en el acto. Estos músicos profesionales desarrollan una forma muy intrincada de tema y variación; cada uno es consciente de su tonada y su papel; esto explica la razón por la que la improvisación de jazz sirve como un paradigma excelente para el estudios de la creatividad en tiempo real. La improvisación en el jazz es también un prototipo de la actividad mental común al reconocimiento del habla y otras áreas de interés en la inteligencia artificial.

Actualmente hay dos teorías encontradas en el estudio de la improvisación en el jazz: (1) el enfoque basado en los patrones y (2) el enfoque basado en reglas; la figura 1 ilustra esta situación esquemáticamente (se ha dejado el texto en el inglés original).

Figura 1. Teorías cognitivas encontradas

Hay varios softwares para la improvisación en el jazz que se basan en una de las teorías descritas más arriba, patrones o reglas. Un ejemplo de un software basado en reglas es Impro-Visor, un software para la notación musical diseñada para ayudar a los estudiantes de jazz componer y escuchar solos similares a los que podrían improvisarse sobre los acordes dados. Martin y sus colaboradores [7], en un artículo de 2013, analizaron las dos teorías cognitivas prevalecientes por medio del análsis de un corpus de solos de Charlie Parker. Los resultados del estudio (mostrados en la figura 2, primera parte) demostró que el porcentaje de notas que inician un patrón de 4 intervalos como una función del número de veces el patrón ocurre en las improvisaciones no es coherente con el corpus de Charlie Parker cuando se emplea el software Impro-Visor (mostrados en la figura 2, segunda parte).

Figura 2 (primera parte). Comparación del porcentaje de notas que inician un patrón de 4 intervalos como una función del número de veces que el patrón ocurre en el corpus. [2]

Figura 2 (segunda parte). Comparación de los porcentajes de notas que inician en un patrón de 4 intervalos como una función del número de veces que el patrón ocurre en 1) una melodía generada según la gramática de Parker en el software Impro-Visor y 2) utilizando nuestro algoritmo. [2]

No obstante, un algoritmo basado en patrones melódicos parece reflejar el corpus de Parker con mucha más fidelidad. Tras los buenos resultados conseguidos por este último algoritmo, los autores pensaron en incorporar los acordes a la generación de los solos. Los acordes son fundamentales en la improvisación en el jazz y existe una íntima relación entre melodía y acordes que no es posible deslindar en modo alguno en este estilo. Existía, empero, el peligro de que la incorporación de los acordes restringiese excesivamente las posibilidades de elección de los patrones si dicha incorporación no se hacía de modo cuidadoso. Entonces, para incorporar los acordes y, a la vez, modificar lo menos posible las improvisaciones que resultan de nuestro algoritmo, decidimos explorar las cadenas de Markov no homogéneos.

Modelos de Markov

Los procesos de Markov son una herramienta popular de modelaje que se emplean en la generación de contenido, tales como la generación de textos, la composición musical y la interacción. El principio básico de la suposición de Markov es que los estados futuros dependen sólo del pasado inmediato y de la sucesión de eventos que ocurrió anteriormente. Matemáticamente, para una sucesión :

p(qi|q1,...,qi-1) = p(qi|qi-1)(1)

Ejemplo de un proceso de Markov[4] El pronóstico del tiempo consiste en adivinar el estado del clima mañana basado en una historia de observaciones en torno al tiempo. En base a la tabla 1 de números escogidos aleatoriamente, mas el autómata generado de esta tabla en la figura 3, intentaremos pronosticar el tiempo.

Tabla 1. Probabilidades escogidas aleatoriamente para el tiempo.

Figura 3. Autómatas generadas de la Tabla 1.

Por ejemplo, en vista de que hoy es un día soleado, ¿cuál es la probabilidad que mañana sea soleado y que el día siguiente sea lluvioso? Esto se traduce en los siguientes cálculos:

P(q2 = soleado, q3 = lluvioso | q1 = soleado)

= P(q3 = lluvioso | q2 = soleado, q1 = soleado) x

P(q2 = soleado | q1 = soleado)

= P(q3 = lluvioso | q2 = soleado) x

P(q2 = soleado | q1 = soleado)

= (0.05)(0.8)

= 0.04

Esta probabilidad también se puede obtener a través del autómata de la figura 3, multiplicando las probabilidades correspondientes en el proceso.

Resultados