Home » Cultura y matemáticas » Música y matemáticas

Música y matemáticas

El objetivo de esta sección es comprender la interesante y profunda relación de las Matemáticas con la Música.

Nuestro sincero agradecimiento a Francisco Gómez Martín (Universidad Politécnica de Madrid) por organizar y desarrollar esta sección, a sus anteriores responsables Rafael Losada y Vicente Liern, así como a todas las personas que colaboran con la misma.

Resultados 41 - 50 de 130

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Ritmos equilibrados y euclídeos

La columna de este mes de mayo estará dedicada a la síncopa. Este es un fenómeno siempre fascinante y al que le hemos dedicado en esta columna varios artículos; véase, por ejemplo, la serie Medidas matemáticas de síncopa [Góm11c, Góm11b, Góm11a] en el año 2011, o recientemente la serie Medidas de complejidad rítmica [Góm17a, Góm17b, Góm18]. En este artículo vamos a examinar un trabajo de Chunyang Song y sus coautores, Syncopation and the Score (la síncopa y la partitura) [SAJRCA+13]. En este interesante trabajo sus autores investigan la relación entre el ritmo escrito (la partitura) y la síncopa percibida. Dado que este trabajo versa sobre la síncopa percibida, esto es, la sensación de síncopa comunicada por sujetos, claramente se trata de un estudio de cognición musical.

2. Síncopa y partitura

Rememorando lo dicho en nuestra serie sobre la síncopa de 2011 [Góm11c], volvemos al fidedigno Harvard Dictionary of Music [Ran86] para una definición conceptual sólida: “Síncopa: una contradicción momentánea de la métrica o pulso predominante”. El autor de la definición la amplía y enseguida añade que “la síncopa se puede crear por los los valores de las notas mismos o por la acentuación, la articulación, el contorno melódico o el cambio armónico en el contexto por otro lado de una sucesión de notas no sincopadas”. Los autores del artículo, sin duda conscientes de esta definición, la desarrollan en el dominio de la cognición musical. Así, definen pulso como el percepto periódico subyacente que los oyentes humanos extraen de los patrones temporales de la música. Por percepto, aquí se entiende el objeto tal y como lo percibe el sujeto. La definición de pulso está tomada de Trainor [Tra07]. Cuando los oyentes humanos infieren una estructura a partir de las periodicidades destacables en los grupos de pulsos, se produce un constructo abstracto de duraciones temporales que se conoce como métrica. Esas agrupaciones de duraciones temporales se pueden a varios niveles y por tanto la métrica posee una estructura jerárquica.

La partitura se puede concebir como una codificación simbólica que describe los eventos que ocurren en una pieza musical. Estos eventos han de ser interpretados por un músico para que el oyente pueda percibir el resultado de la partitura. Si nos restringimos a la música occidental (que en el artículo de Song y sus coautores es una hipótesis implicita), la partitura estará escrita en un compás dado. El compás indica en qué tipo de métrica va a estar la pieza. Hay dos tipos de compases principales: los de subdivisión binaria y los de subdivisión ternaria. Los primeros nos dicen que la agrupación de las duraciones se hará en grupos de dos, mientras que en el caso ternario dicha agrupación será en grupos de tres.

Como decíamos arriba, cuando la estructura métrica predominante es contradicha momentáneamente, hablamos de síncopa. Para que dicha contradicción tenga lugar hace falta que la estructura métrica se haya establecido durante un tiempo suficientemente largo como para que el oyente la integre en la escucha de la pieza. Los autores del artículo, y con bastante razón, argumentan que muchas de las medidas de síncopas definidas hasta la fecha no tienen en cuenta este hecho.

Una vez establecido el contexto métrico, ¿cómo se produce la síncopa? Se sabe que hay varios mecanismos para ello y Song y sus coautores los identifican con exhaustividad. En la partitura, hay síncopas que se indican poniendo acentos en las partes débiles de la métrica. Son las llamadas síncopas por acentuación (Stravinsky es un experto en este tipo de síncopas). Otro tipo de síncopa es la llamada síncopa de ataque; consiste en que una nota que empieza en parte débil es prolongada hasta otra parte débil. Típicamente, esto se consigue poniendo silencios en partes fuertes o ligando notas entre partes débiles consecutivas. Otra forma de síncopa es la polirritmia. Una polirritmia es la presentación de dos o más ritmos que no comparten las mismas agrupaciones temporales, lo que con frecuencia da una sensación de métricas que compiten entre sí. Hay unas cuantas tradiciones musicales en que es normal las polirritmicas, especialmente las africanas y las afro-cubanas. En la serie Transformaciones rítmicas: de binarizaciones y ternarizaciones [Góm13] del año 2013 analizamos las polirritmias en las tradicionales musicales de la franja atlántica del continente americano; se remite al lector a esa serie para más información sobre este asombroso fenómeno musical y también al libro de Simha Aaron African Polyphony and Polyrhythm [Aro91].

Los autores son conscientes de las medidas de síncopa que hay en la bibliografía y mencionan, entre otras, las siguientes: la medida de complejidad cognitiva de Pressing [Pre99], la medida de síncopa de Longuet-Higgins [LHC84], la medida de complejidad rítmica de Lempel y Ziv [LZ76], la medida de síncopa de Keith [Kei91], o la medida WBND [GMRT05] (WBND significa distancia ponderada de pulso a nota en sus siglas inglesas). Véase [Góm11c, Góm17a, Góm17b, Góm18] para un exposición divulgativa de esos trabajos. Para la definición operativa de polirritmia, Song y sus coautores se basan en el trabajo de Handel y Oshinsky[SJ81].

3. Síncopa percibida

3.1. Las preguntas de investigación

Los autores del trabajo midieron la síncopa percibida a través de experimentos con sujetos. Se reclutaron a 10 músicos, voluntarios, sin pago alguno por la participación en el experimento, con una media de 15 años de formación y práctica (desviación típica 5). Seis de los participantes eran multi-instrumentistas. Las hipótesis que los investigadores querían estudiar eran las siguientes:

El papel de la métrica en la percepción de la síncopa;

El papel que desempeña la presencia o ausencia de la parte fuerte en la percepción de la síncopa;

Si la síncopa se percibe más fuertemente en presencia de polirritmos o bien en presencia de ritmos simples;

El papel de la posición de la síncopa dentro del compás.

3.2. Los experimentos

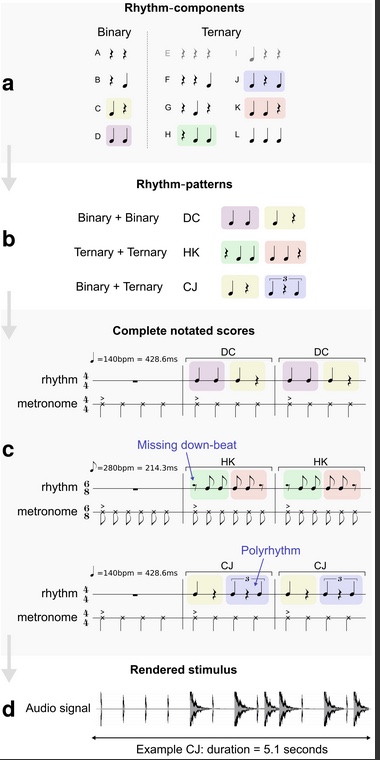

La música que escucharon los sujetos estaba compuesta por tres compases, bien en 4/4 o bien en 6/8. El primer compás era siempre el pulso dado por un metrónomo. El segundo y el tercer compás era una repetición de un ritmo que a su vez estaba compuesto por dos medios ritmos básicos. Estos ritmos básicos se combinaban de varias maneras para generar todos los estímulos a que se exponían a los sujetos. La figura 1 muestra un esquema de cómo funciona la generación de los ritmos. Los ritmos básicos tienen o bien dos o bien tres notas. Cada uno de los ritmos básicos se combina con otro para dar un ritmo principal. Las letras mayúsculas en la figura de abajo designan los ritmos básicos, que van desde la A hasta la L. Así, DC quiere decir la combinación del ritmo D con el C en ese preciso orden. El metrónomo se toca al mismo tiempo que los ritmos como referencia.

Figura 1: Generación de los ritmos para los experimentos (figura tomada de [SAJRCA+13])

Los ritmos básicos contienen todas las categorías de síncopas (síncopas de acentuación, síncopas de ataque y polirritmias) descritas más arriba. Se generaron en total 99 patrones rítmicos y se aleatorizó la presentación dentro de las categorías de síncopas. El estímulo final fue el de una caja clara para el patrón principal y de un cencerro para el metrónomo. El metrónomo fue acentuado ligeramente en dinámica cuando caía en la primera nota del compás. El tempo del metrónomo fue de 140 pulsos por minuto para el compás de 4/4 y de 280 para el de 6/8. Los sujetos escuchaban los ritmos y tenían que puntuarlos entre 0 y 4, donde 0 es no hay síncopa y 4 tiene máximo nivel de síncopa. Los sujetos podían escuchar tantas veces como quisieran los patrones rítmicos. Además, tuvieron sesiones de práctica para entender bien el procedimiento experimental. Los investigadores sugerían a los sujetos que tomasen descansos para evitar el cansancio auditivo.

3.3. Los resultados

La figura 2 muestra un resumen de los resultados. La matriz mostrada en (a) contiene una representación de la media de las puntuaciones para cada patrón rítmico. El eje horizontal muestra el primer ritmo básico y el eje vertical el segundo. La parte (b) muestra la matriz de (a) ahora descompuesta en regiones que corresponden a los patrones rítmicos de los experimentos. La parte (c) muestra intervalos de confianza al 95% para las puntuaciones dadas por los sujetos. Por último, (d) muestra intervalos de confianza para la media de las puntuaciones por ritmo básico.

Figura 2: Generación de los ritmos para los experimentos (figura tomada de [SAJRCA+13])

Los resultados que se desprenden de los experimentos de Song y sus coautores son los siguientes:

El compás de 6/8 es más sincopado que el de 4/4.

Los polirritmos son más sincopados que los ritmos simples.

La ausencia de notas en las partes fuertes dan más sensación de síncopa.

El cambio de orden en los ritmos básicos afecta a la sensación de síncopa.

Dónde se produce la síncopa dentro del compás afecta a su percepción.

4. Conclusiones

El trabajo de Song y sus coautores es profundo y metodológicamente impecable. En la parte final del artículo discuten varias medidas de síncopa y señalan fallos de diseño en dichas medidas. Todas las medidas mencionadas en la sección 2, por ejemplo, no tienen en cuenta la posición de la síncopa dentro del compás y dan el mismo peso a la síncopa ocurra donde ocurra. Es el caso de la medida WBND (uno de cuyos coautores es el humilde redactor de este artículo). Esta medida cuantifica la síncopa en base a las notas en parte débil tomando la distancia de la parte débil a la siguiente parte fuerte, pero no modifica la distancia en función de dónde ocurre la nota en parte débil. Lo mismo ocurre con la distancia de Longuet-Higins.

La razón por la que hemos analizado este artículo en esta columna es que muestra cómo el rigor que proporcionan las matemáticas es necesario para cualquier investigación mínimamente seria sobre cualquier tema, en este caso el maravilloso mundo de las síncopas.

En resumen, un buen artículo, bien escrito, bien investigado, que trata un tema fascinante: la síncopa.

Bibliografía

[Aro91] Simha Arom. African Polyphony and Polyrhythm. Cambridge University Press, Cambridge, England, 1991.

[GMRT05] Francisco Gómez, Andrew Melvin, David Rapapport, and Godfried Toussaint. Mathematical measures of syncopation. In Proceedings of BRIDGES: Mathematical Connections in Art, Music and Science, pages 73–84, Banff, Alberta, July 31 - August 3 2005.

[Góm11a] Paco Gómez. Medidas matemáticas de síncopa (III). Diciembre, 2011.

[Góm11b] Paco Gómez. Medidas matemáticas de síncopa (II). Noviembre, 2011.

[Góm11c] Paco Gómez. Medidas matemáticas de síncopa (I). Octubre, 2011.

[Góm13] Paco Gómez. Transformaciones rítmicas: de binarizaciones y ternarizaciones (I). Agosto, 2013.

[Góm17a] Paco Gómez. Medidas de complejidad rítmica (I). Octubre, 2017.

[Góm17b] Paco Gómez. Medidas de complejidad rítmica (II). Octubre, 2017.

[Góm18] Paco Gómez. Medidas de complejidad rítmica (III). Enero, 2018.

[Kei91] Michael Keith. From Polychords to Pólya: Adventures in Musical Combinatorics. Vinculum Press, Princeton, 1991.

[LHC84] H.C. Longuet-Higgins and C.S. The rhythmic interpretation of monophonic music. Music Perception, 1:424–441, 1984.

[LZ76] A. Lempel and J. Ziv. On the complexity of finite sequences. IEEE Transactions on Information Theory, 22(1):75–81, 1976.

[Pre99] J. Pressing. Cognitive complexity and the structure of musical patterns, 1999.

[Ran86] Donald Randel(editor). The New Grove Dictionary of Music and Musicians. Akal, London, 1986.

[SAJRCA+13] Chunyang Song, Simpson Andrew J. R., Harte Christopher A., Pearce Marcus T., and Sandler Mark B. Septiembre de 2013.

[SJ81] Handel S. and Oshinsky JS. The meter of syncopated auditory polyrhythms. Percept Psychophys, 30:1–9, 1981.

[Tra07] L. J. Trainor. Do preferred beat rate and entrainment to the beat have a common origin in movement? Empirical Musicology Review, 2:17–21, 2007.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Ritmos equilibrados y euclídeos

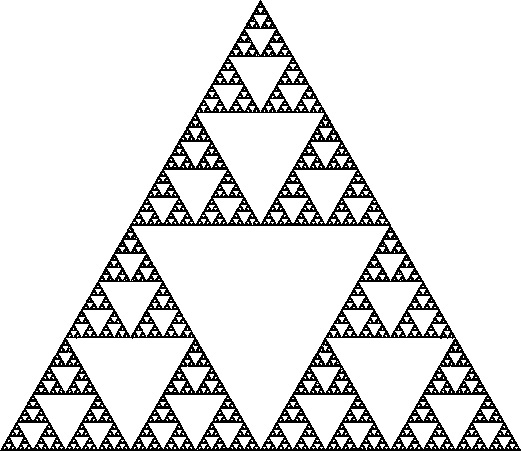

La representación geométrica de ritmos y escalas ha sido con frecuencia una herramienta útil para su análisis y para el descubrimiento de nuevos objetos musicales. En esta columna vamos a tratar los patrones rítmicos y de escalas llamados equilibrados y también examinaremos una herramienta, XronoMorph, diseñada por Andrew Milne y Roger Dean [MD16], que permite experimentar con esos ritmos. Para las definiciones que vamos a presentar, necesitamos previamente fijar una circunferencia en la que pondremos los objetos musicales —alturas de sonido o duraciones —. En el vídeo siguiente, A different way to visualize rhythm, John Varney habla de las ventajas de la representación geométrica del ritmo, sobre todo cuando los ritmos son cíclicos y estos se visualizan en una circunferencia.

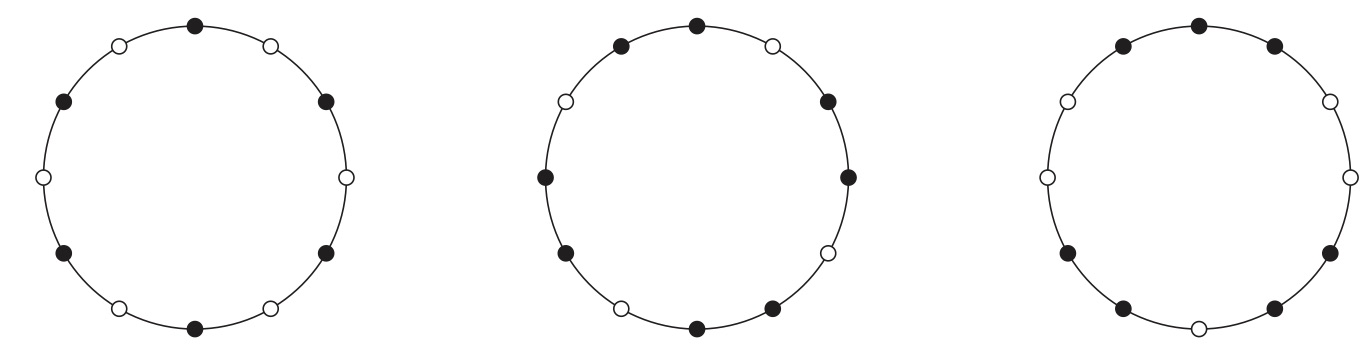

Por sencillez de la exposición, supondremos que los objetos musicales ritmos y, por tanto, los puntos en la circunferencia marcan duraciones consecutivas. El análisis es el mismo si tratamos las escalas. Un ritmo es equilibrado si el centro de gravedad es el propio centro de la circunferencia. Para hablar con propiedad del centro de gravedad, supondremos que cada nota sobre la circunferencia tiene masa unidad y entonces dicho centro es el punto de aplicación de la resultante de todas las fuerzas de gravedad dada por las notas. Por ejemplo, en la figura de abajo, los tres ritmos, dados por los círculos negros, son ritmos equilibrados; aquí se ha tomado doce como número de pulsos para los ritmos.

Figura 1: Ejemplos de ritmos equilibrados.

El concepto de ritmo equilibrado está relacionado con el de ritmo regular. Un ritmo regular es aquel que tiene las notas distribuidas tan regularmente como sea posible a lo largo del círculo. Se sabe que los ritmos regulares solo pueden tener una o dos duraciones posibles y que estas tienen que estar colocadas en un orden especial. Se conocen varios algoritmos para generar ritmos regulares; entre ellos los más importantes son el de Bjorklund [GMTT09b], el de Clough y Douthett [CD91], o el mismísimo algoritmo de Euclides, que cuando se adapta a la formación de grupos, produce ritmos regulares. Los dos primeros ritmos de la figura 1 son regulares. En una columna anterior [Góm12], Amalgamas, aksaks y métricas euclídeas, se trataron a fondo los ritmos regulares, también llamados ritmos euclídeos. Para información más sobre los algoritmos, propiedades de los ritmos regulares y sus aplicciones en música, véanse [DGMM+09, GMTT09b, GMTT09a, CD91].

En lo que sigue usaremos tres notaciones para designar los ritmos: la notación de ceros y unos, adecuada para el tratamiento algorítmico; la notación de x y ., que es cómoda para la lectura musical; y la notación de distancia. Si no se dice nada en contra, cuando un ritmo se represente sobre el círculo, empezaremos a describirlo desde las doce del mediodía. Así, los ritmos de la figura 1, de izquierda a derecha, se designan por

R1 = [101010101010 ] = [x . x .x .x .x .x ] = (222222)

R2 = [101101101101] = [x .x x . x x . x x . x] = (21212121)

R3 = [110011011001] = [x x ..x x . x x . .x] = (1312131)

2. Ritmos equilibrados y euclídeos

2.1. Ritmos euclídeos

En lo que sigue vamos a seguir la exposición del trabajo Si Euclides lo supiese... se sentiría orgulloso [Góm09] del propio autor de estas líneas. El algoritmo de Euclides consiste en hacer divisiones sucesivas para hallar el máximo común divisor de dos números positivos (m.c.d. de aquí en adelante). Si queremos hallar el m.c.d. de dos números a y b, suponiendo que a > b, primero dividimos a entre b, y obtenemos el resto r de la división. Euclides se dio cuenta de que el m.c.d. de a y b era el mismo que el de b y r. En efecto, cuando dividimos a entre b, hallamos un cociente c y un resto r de tal manera que se cumple que:

a = c⋅b + r

Esta ecuación nos dice que todo divisor común de a y b tiene que serlo también de r. En particular, el m.c.d. de a y b es el m.c.d. de b y r. Por ejemplo, calculemos el máximo común de 17 y 7. Como 17 = 7 ⋅ 2 + 3, entonces el m.c.d.(17, 7) es igual al m.c.d.(7, 3). De nuevo, como 7 = 3 ⋅ 2 + 1, entonces el m.c.d.(7, 3) es igual al m.c.d.(3, 1). Aquí es claro que el m.c.d. entre 3 y 1 es simplemente 1. Por tanto, el m.c.d entre 17 y 7 es 1 también.

¿Cómo se transforma el cálculo del máximo común divisor en un método para generar patrones distribuidos con regularidad máxima?

Ilustraremos el proceso con un ejemplo de ritmos. Supongamos que tenemos 17 pulsos y queremos distribuir de forma regular 7 notas entre los 17 pulsos. Sigamos los pasos dados en la figura 2. Primero, alineamos el número de notas y el número de silencios (siete unos y diez ceros); véase la figura 2-paso (1). A continuación, formamos grupos de 7, los cuales corresponden a efectuar la división de 17 entre 7; obtenemos, pues, 7 grupos formados por [1 0] (en columnas en el paso (2) de la figura 2). Sobran tres ceros, lo cual indica que en el paso siguiente formaremos grupos de 3. Tras formar el primer grupo —véase el paso (3) de la figura 2— nos quedamos sin ceros. Continuamos agrupando de 3 en 3 tomando los grupos de la otra caja, en la que quedan 4 columnas (figura 2-paso (4)). Procedemos así que queden uno o cero grupos; de nuevo, esto es equivalente a efectuar la división de 7 entre 3. En nuestro caso, queda un solo grupo y hemos terminado (paso (5)). Finalmente, el ritmo se obtiene leyendo por columnas y de izquierda a derecha la agrupación obtenida (paso (6)).

Figura 2: El algoritmo de Euclides para generar ritmos regulares.

Aquí cada 1 representa una nota [x] y cada 0, un silencio [.]. El ritmo que hemos generado con nuestra notación se escribe entonces como [x . . x . x . . x . x . . x . x .].

Los ritmos generados por este método se llaman ritmos euclídeos. El ritmo euclídeo de k notas y n pulsos se designa por E(k,n). Otra manera útil de designar un ritmo es mediante las duraciones de las notas en términos de pulsos. El ritmo euclídeo que acabamos de obtener con esta notación se escribe E(7,17) = [x . . x . x . . x . x . . x . x .]= (3232322).

Demain y sus coautores [DGMM+09] probaron formalmente que este algoritmo proporciona, salvo rotaciones, la única manera de distribuir k objetos entre n del modo más regular posible. Aún más, había varios algoritmos propuestos de manera independiente y ellos probaron que, en realidad, eran todos equivalentes al viejo algoritmo de Euclides.

Damos a continuación una pequeñísima muestra de ritmos euclídeos que se encuentran en las músicas tradicionales del mundo.

E(5,8) =[x . x x . x x .]= (21212) es el cinquillo cubano, así como el malfuf de Egipto, o el ritmo coreano para tambor mong P’yon. Si el ritmo se empieza a tocar desde la segunda nota aparece un popular ritmo típico de Oriente Próximo, así como el timini de Senegal. Si se empieza en la tercera nota tenemos el ritmo del tango.

E(5,12) =[x . . x . x . . x . x .]= (32322) es un ritmo muy común en África central que tocan los pigmeos aka. Cuando se toca desde la segunda nota es, entre otros, la clave columbia de la música cubana y el ritmo de la danza chakacha de Kenya.

E(5,16) =[x . . x . . x . . x . . x . . . ]= (33334) es el ritmo de la bosa-nova de Brasil. Este ritmo se toca a partir de la tercera nota.

Existen cerca de dos centenares de ritmos de músicas del mundo documentados que son generados por el algoritmo de Euclides. De nuevo, véase el artículo The distance geometry of music de Demain y sus coautores [DGMM+09].

He aquí una lista de las principales propiedades de los ritmos regulares o ritmos euclídeos:

Los ritmos euclídeos tienen solo una o dos duraciones. En el caso de dos duraciones, estas difieren exactamente en una unidad. Por ejemplo, en este ritmo euclídeo (21212) hay dos duraciones de valor 2 y 1.

Cuando el número de notas no es primo relativo del número de pulsos, los ritmos euclídeos están formados por la repetición de un patrón. En caso contrario, el ritmo está compuesto por un patrón repetido un número máximo de veces más un único patrón más pequeño, que además es subpatrón del patrón que se repite.

Los patrones que forman los ritmos euclídeos son a su vez euclídeos. Esto crea una jerarquía de ritmos euclídeos anidados.

La rotación de un ritmo euclídeo es también euclídeo. Esto es consecuencia de que los ritmos euclídeos maximizan las distancias intercordales entre las notas y dichas distancias no cambian con las rotaciones.

Tomar el complementario de un ritmo euclídeo (esto es, intercambiar ceros por unos) devuelve un ritmo euclídeo.

Los ritmos regulares son ritmos equilibrados, pero el recíproco no es cierto.

2.2. Ritmos equilibrados

Cuando se considera el círculo donde se inscriben los ritmos, si el polígono resultante al unir las notas consecutivas del ritmo es regular, entonces el ritmo es equilibrado. De nuevo, el recíproco no es cierto, como atestiguan los polígonos de la figura de arriba. En el artículo Perfect balance: A novel principle for the construction of musical scales and meters, de Milne y coautores [MBHW15], se estudian a fondo las propiedades de los ritmos equilibrados. En dicho artículo los autores asocian a cada ritmo una serie de Fourier discreta uno de cuyos coeficientes es una medida del equilibrio del ritmo. La condición de ser equilibrado se puede pensar como la varianza circular. Si el ritmo tiene varianza cero, entonces se reduce a un único punto. En cambio, si la varianza es máxima entonces el ritmo será equilibrado; véase el artículo mencionado para los detalles técnicos.

3. XronoMorph: una aplicación para la experimentación rítmica

Para terminar, querríamos comentar el programa XronoMorph. Se trata de una aplicación que permite experimentar con ritmos equilibrados y ritmos euclídeos. Es una aplicación gratis y funciona en los sistemas operativos Mac OS X y Windows. Usa como objeto centrar para la representación una circunferencia y permite describir polirritmos en términos de polígonos inscritos. Abajo tenemos un vídeo donde se ve la interfaz.

En el vídeo de abajo podemos ver un ejemplo en que varios polígonos regulares se superponen. Estos polígonos representan ritmos euclídeos y aparecen organizados en una polirritmia.

En el siguiente vídeo tenemos ritmos equilibrados que también forman una polirritmia, en este caso la superposición de un ritmo binario con uno ternario.

En este otro vídeo vemos un 3 contra 5.

Por último, XronoMorph permite varias operaciones con polígonos, como por ejemplo, la rotación. Se pueden componer polirritmias muy complicadas asignando un instrumento a cada rotación de un polígono. Véase una muestra en el siguiente vídeo.

Bibliografía

[CD91] J. Clough and J. Douthett. Maximally even sets. Journal of Music Theory, 35:93–173, 1991.

[DGMM+09] Erik D. Demaine, Francisco Gomez-Martin, Henk Meijer, David Rappaport, Perouz Taslakian, Godfried T. Toussaint, Terry Winograd, and David R. Wood. The distance geometry of music. Computational Geometry: Theory and Application, 42(5):429–454, 2009.

[GMTT09a] F. Gomez-Martin, P. Taslakian, and G. T. Toussaint. Interlocking and euclidean rhythms. Journal of Mathematics and Music, 3(1), 2009.

[GMTT09b] F. Gomez-Martin, P. Taslakian, and G. T. Toussaint. Structural properties of euclidean rhythms. Journal of Mathematics and Music, 3(1), 2009.

[Góm09] Paco Gómez. Si Euclides lo supiese... se sentiría orgulloso, Noviembre, 2009.

[Góm12] Paco Gómez. Amalgamas, aksaks y métricas euclídeas, Noviembre, 2012.

[MBHW15] A. Milne, D. Bulger, S. Herff, and Sethares W. Perfect balance: A novel principle for the construction of musical scales and meters. In T. Collins, D. Meredith, and A. editor Volk, editors, Proceedings of the 5th International Conference on Mathematics and Computation in Music, pages 97–108. Springer, Berlin, 2015.

[MD16] Andrew J. Milne and Roger T. Dean. Computational creation and morphing of multilevel rhythms by control of evenness. Computer Music Journal, 40(1):35–53, 2016.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

Este artículo es la continuación de la serie sobre medidas de complejidad rítmica. Los dos primeros artículos fueron las columnas de octubre [Góm17a] y noviembre [Góm17b], respectivamente. En estas dos columnas se presentaron las principales medidas de complejidad rítmica, que se dividieron en dos grandes categorías: la primera, las medidas métricas, las medidas basadas en patrones y las medidas basadas en distancias; la segunda, las medidas formales de complejidad, tales como las medidas basadas en la entropía de la información, las basadas en los histogramas de intervalos entre notas consecutivas y las llamadas de irregularidad matemática, que incluyeron el índice de asimetría rítmica y la medida de contratiempo. En esta tercera columna, la última de la serie, tratamos la evaluación perceptual de esas medidas. Sabemos que cada medida ha sido diseñada poniendo atención a ciertos aspectos del fenómeno rítmico. El objetivo final es que las medidas reflejen lo más fielmente posible la medida humana de la complejidad rítmica. Tal medida humana es, por sí misma, un objetivo muy difícil de definir y aun más de medir. Varias preguntas de manera natural e inmediata surgen. ¿Es la percepción humana de la complejidad rítmica un universal? Si no lo es, ¿depende de la cultura?, ¿de la exposición a determinado estilo?; ¿varía con la predisposición genética? Para un individuo fijo, ¿es dicha percepción consistente en el tiempo?; ¿o depende del estado emocional, de su cansancio o de otros factores?; y si es así, ¿de qué factores? En general, ¿cómo se debería medir la complejidad rítmica? ¿Como ritmos puros o bien inmersa en la melodía o en un contexto armónico? En este último caso, ¿cómo se aísla la complejidad melódica de la complejidad rítmica? ¿Qué factores generales afectan la percepción de la complejidad rítmica? Por ejemplo, Vinke [Vin10], en su tesis de maestría, identifica varios factores tales como tempo, formación musical, timbre, acciones motrices asociadas o producidas durante la percepción de los ritmos, pero sabemos que hay otros factores, como el agrupamiento.

En su tesis de maestría Thule [Thu08] contesta en parte a estas preguntas, apoyándose en experimentos que psicólogos de la música habían llevado a cabo para tratar de medir la complejidad rítmica. El mérito de Thul y Toussaint, su director de tesis, fue usar esas medidas cognitivas para evaluar la bondad de las múltiples medidas que se habían propuesto, pero que inexplicablemente no se habían evaluado. Puede parecer extraño que un investigador presente una medida de complejidad rítmica y no la evalúe con datos reales para determinar su efectividad. Sin embargo, esta ha sido la situación para la gran parte de las medidas examinadas por Thul.

2. Las medidas humanas de complejidad rítmica

En esta sección examinaremos los datos experimentales de tres trabajos diferentes, el de Povel y Essens [PE85], el de Shmulevich y Povel [SP00], y el de Fitch y Rosenfield [FR07], y que sirvieron de base para obtener las medidas humanas de complejidad rítmica. Los dos primeros estudios usan los mismos ritmos como estímulo de entrada, los cuales se pueden ver en la figura 1 más abajo. El primer estudio, el de Povel y Essens, data de 1985 y en él estos autores investigaron la medida de la complejidad rítmica de la ejecución. Estrictamente hablando, no es una medida de la complejidad rítmica, pero la hipótesis subyacente era que la complejidad rítmica y de reproducción están estrechamente relacionadas. Al fin y al cabo, un ritmo complejo debería ser más difícil de reproducir que uno que no lo es. Quince años más tarde, en 2000, Shmulevich and Povel usaron los mismos ritmos para su propio estudio, pero esta vez el objetivo sí era la complejidad rítmica. En 2007 Fitch y Rosenfeld estudiaron la complejidad de la ejecución así como la complejidad métrica; estos autores usaron otros ritmos diferentes a los de los dos primeros estudios.

2.1. Los datos de Povel y Essens

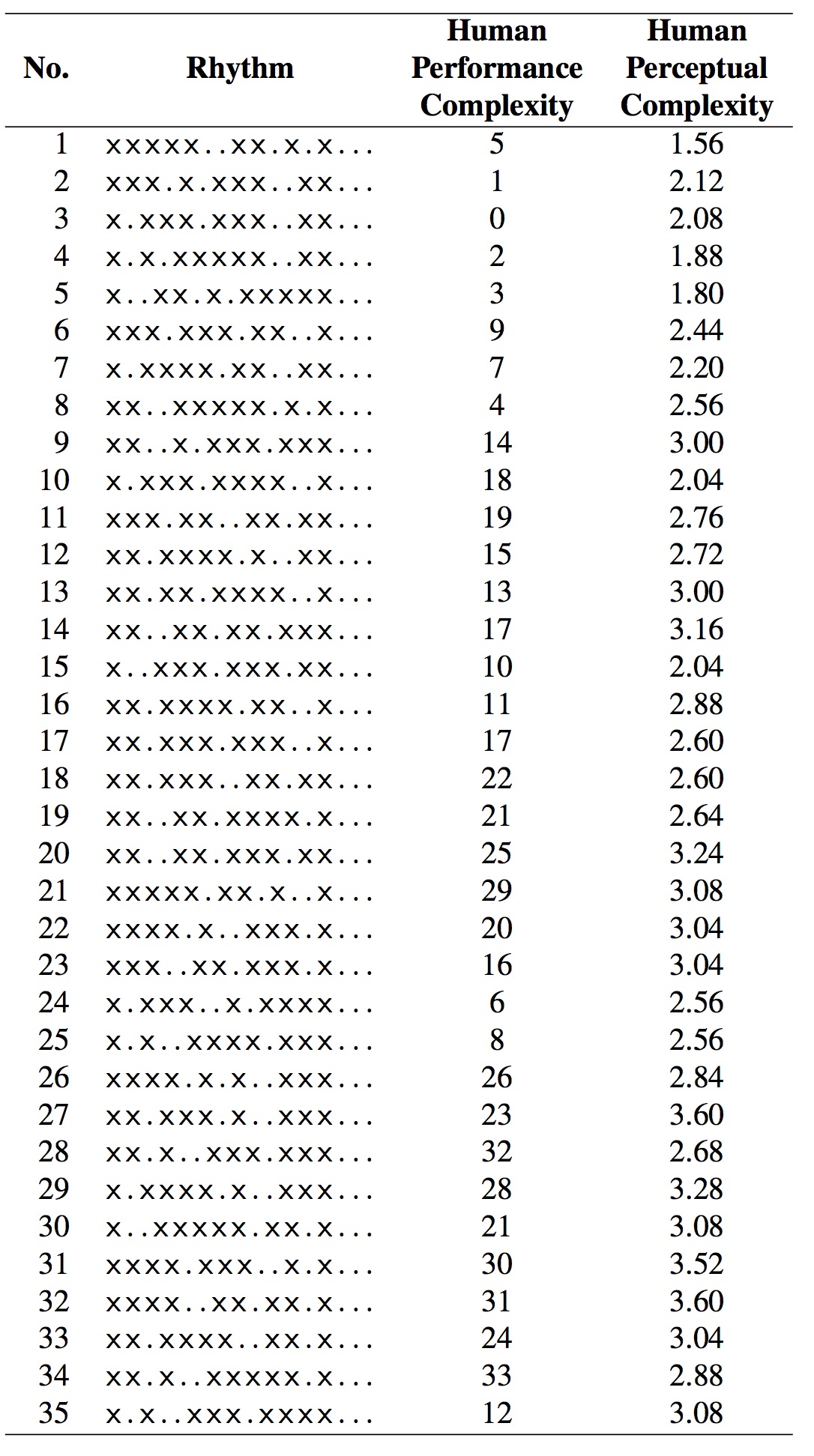

Povel y Essens decidieron en su estudio usar ritmos sintetizados por un ordenador con el fin de aislar variables tales como el timbre o la altura del sonido. Los ritmos se pueden ver en la figura 1.

Figura 1: Ritmos usados en los experimentos (figura tomada de [Thu08])

La pregunta de investigación que se plantearon estos autores tenía un carácter muy cognitivo. Querían comprobar si los ritmos que inducen un carácter métrico fuerte generan mejores representaciones internas que los ritmos que tienen un carácter métrico débil. En el lenguaje de Povel y Essens, el carácter métrico es descrito como un reloj interno. Los ritmos que usaron en sus experimentos tienen una estructura muy fija. Son todas las permutaciones del patrón de los intervalos de duraciones entre notas consecutivas (IDNC) del conjunto . Según estos autores, este conjunto solo admite variaciones estructurales. Nos queda la duda, sin embargo, de qué resultados se habrían obtenido con un conjunto de ritmos más variado. Por ejemplo, los ritmos en este estudio tienen el mismo número de notas, pero sabemos que la medida de complejidad variaría notablemente con el número de notas.

El estudio usa 24 sujetos, los cuales tenían que reproducir un ritmo que acababan de oír. El ritmo se podía oír tantas veces como el sujeto quisiera y además podían tocarlo a la vez si así lo querían (de hecho, en el experimento se les animaba a que así lo hiciesen). Pero cuando daban al botón de parar la reproducción del ritmo, entonces tenían que tocarlo y no tenían la oportunidad de volverlo a tocar. Se exigía al sujeto una reproducción de al menos cuatro veces seguidas. Si un sujeto no estaba satisfecho con la reproducción de un ritmo, podía empezar el proceso desde el principio para ese ritmo concreto. La manera en que Povel y Essens midieron la complejidad rítmica de la reproducción fue a través de un porcentaje que medía la discrepancia de las reproducciones de los sujetos con respecto al ritmo presentado. Los resultados de los experimentos se puede ver en la columna que reza human performance complexity en la figura 1.

2.2. Los datos de Povel y Shmulevich

En el experimento de Shmulevich y Povel, como hemos dicho, se usaron los mismos ritmos que antes. Los sujetos fueron reclutados de la Universidad de Nijmegen y todos eran músicos con una media de 9,2 años de experiencia musical. Los ritmos se presentaron a los sujetos sintetizados por MIDI con un sonido de marimba y de manera aleatoria. Los participantes tenían que puntuar los ritmos según la complejidad rítmica en una escala de números enteros que iba de 1 (más sencillo) a 5 (más complejo). En la última columna de la tabla de la figura 1, la que reza human perceptual complexity.

2.3. Los datos de Fitch y Rosenfeld

En 2007, Fitch y Rosenfeld llevaron a cabo dos experimentos, uno de reproducción rítmica y otro de complejidad métrica. Los estímulos de sus experimentos se pueden consultar en la figura 2. Los ritmos fueron generados de tal manera que la cantidad de síncopa variara sustancialmente, y donde la síncopa se midió usando la medida de Longuet-Higgins y Lee (véase [LHC84] y [Góm17a]). Los 16 participantes tenían entre 0 y 15 años de experiencia musical y realizaron las dos tareas propuestas en el experimento.

Figura 2: Ritmos usados en los experimentos de Fitch y Rosenfeld (figura tomada de [Thu08])

En estos experimentos el ordenador toca un pulso sobre el cual se oye el ritmo y sobre el cual los sujetos tienen también que reproducir dicho ritmo. En el segundo experimento, después de cierto tiempo se supreme el pulso de referencia y el sujeto tiene que seguir reproduciendo el ritmo y además el pulso. Antes de que se suprima el pulso, el ordenador cambia un poco el tempo. Se producen así errores de ritmo que sirven a Fitch y Rosenfeld para evaluar la complejidad rítmica. En la figura 2 las columnas human performance complexity y human metrical complexity corresponden a las medidas obtenidas. La tercera columna se refiere a otro experimento que no hemos descrito aquí.

3. La comparación de las medidas de complejidad

Una vez que tenemos las medidas formales de complejidad rítmica y las medidas humanas (los datos experimentales), ¿cómo se lleva a cabo la comparación entre ellas? Cada medida formal debe ser validada con los datos experimentales. Una posible técnica es la correlación. La correlación es una técnica estadística para detectar relaciones entre dos variables, sean aquellas causales o no. Tal detección puede ser muy útil cuando el objetivo es predecir el comportamiento de una variable en función de otra. Cuando una variable es la causa de la otra, entonces hablamos de causalidad. Cuando hay causalidad, se produce correlación entre las variables, pero al revés no es cierto. Es el famoso cántico que entona todo investigador constantemente: correlación no implica causalidad. Para ver ejemplos muy llamativos y también simpáticos de correlaciones que no implican causalidad, véase la página web de Tyler Virgen, Spurious correlations [Vir17], donde uno se entera de que hay una alta correlación el porcentaje de matrimonios en Kentucky y el número de personas que se ahogaron tras caerse de un bote al mar. Para más información sobre la correlación, véanse [CC83] para los detalles técnicos y [Wik17] para un tratamiento más general.

¿Cómo se cuantifica el grado de correlación entre dos variables? La técnica habitual es a través del llamado coeficiente de correlación de Pearson. Supongamos que X e Y son dos variables (en nuestro caso las medidas), que toman valores n valores xi, yi, respectivamente; ademas, sean X e Y sus medias. El coeficiente de correlación lineal r se define por

El coeficiente r toma valores entre -1 y 1. Valores cercanos a bien -1 o 1 indican una alta correlación lineal, esto es, que las variables dependen la una de la otra en la forma de una ecuación lineal del tipo Y = aX + b, donde a,b son ciertas constantes. Si r está próximo a cero, entonces se entiende que no hay dependencia lineal. Esto, por supuesto, no implica que no haya otro tipo de dependencia (cuadrática, exponencial, etc.). De hecho, hay otros coeficientes para medir otros tipos de dependencia aparte de las lineales. Para un tratamiento riguroso y ameno de los problemas de interpretación de la correlación, recomendamos vehementemente al lector el libro de Ellenberg How Not To Be Wrong. The Power Of Mathematical Thinking [Ell15].

Sin embargo, los coeficientes de correlación como el de arriba no son aplicables en nuestro caso porque las variables son ordinales, esto es, reflejan un orden entre objetos. Para el caso concreto de variables ordinales se usa otro coeficiente, el llamado coeficiente de correlación de rangos de Spearman. Aquí la palabra rango significa el orden del objeto (en nuestro caso medidas de complejidad rítmica) en la clasificación general. Si designamos por di la diferencia entre los rangos xi e yi, y n el número de datos, entonces el nuevo coeficiente, rs, se define por:

Esta fórmula solo es válida si los rangos no contienen repetidos; ese fue el caso de las medidas de complejidad rítmica.

Otro problema matemático que surge ahora es cómo visualizar adecuadamente todos esos coeficientes de correlación. Nótese que el coeficiente de arriba, rs, se tiene que calcular n2 veces, una vez por cada par de medidas. Una vez hecho esto, es posible aplicar una técnica de visualización de análisis de grupos llamada árboles filogenéticos [HB06]. Esta técnica está tomada de la Bioinformática, donde se usa para visualizar la evolución de especies. En este campo, la distancia entre dos especies se toma como la distancia de edición entre el ADN. Para obtener un árbol filogenético hace falta una distancia. En nuestro caso no tenemos una distancia propiamente dicha, pero se pueden transformar los coeficientes de correlación en una distancia con la fórmula ds = 1 - rs.

Las etiquetas que aparecen en la figura 3 son las distintas medidas con sus variantes que Thul calculó. No todas las medidas de su tesis han sido descritas aquí. La potencia de los árboles filogenéticos es que la distancia entre dos nodos en el árbol se corresponde con la distancia real en la matriz. Así, por ejemplo, observando la figura de arriba, a la derecha en la parte superior, vemos que están las medidas humanas de complejidad (las etiquetas human perceptual complexity y human performance complexity), y que las medidas más cercanas a ellas son la medida DPNP (WNBD2 en el gráfico), el índice de contratiempo (offbeatness) y la medida de Keith (keith).

Figura 3: Árboles filogenéticos para el análisis de grupos (figura tomada de [Thu08])

4. Conclusiones

A lo largo de estas tres columnas hemos estudiado un buen grupo de medidas formales de complejidad rítmica, cómo se obtienen medidas humanas de complejidad rítmica y cómo se correlacionan las unas con las otras para ver cuáles son las más adecuadas. Varias observaciones críticas se pueden hacer al proceso. Por una parte, nos damos cuenta de que algunas medidas formales se definieron de una manera abstracta, sin atender a principios musicales y cognitivos. Un ejemplo de esta categoría podría ser la medida de Lempel-Ziv o la medida de Keith. Esta última se basa en combinatoria y asigna los pesos de las plantillas de manera bastante arbitraria. Por otro lado, las medidas humanas fueron generadas a partir de experimentos no siempre directamente relacionados con la complejidad rítmica y en algunos casos usando conjuntos de ritmos ciertamente limitados. En este sentido, es claro que hacen falta nuevos experimentos para mejorar las medidas humanas. Por último, hace falta un marco teórico más claro con respecto a lo que queremos decir cuando hablamos de complejidad rítmica. En la propia tesis de Thul se listan unos cuantos problemas abiertos.

Bibliografía

[CC83] J. Cohen and P. Cohen. Applied Multiple Regression/Correlation Analysis for the Behavioral Sciences. Lawrence Erlbaum Associates, 1983.

[Ell15] Jordan Ellenberg. How Not To Be Wrong. The Power Of Mathematical Thinking. Penguin, 2015.

[FR07] W.T. Fitch and A. J. Rosenfeld. Perception and production of syncopated rhythms. Music Perception, 25(1):43–58, 2007.

[Góm17a] Paco Gómez. Medidas de complejidad rítmica (I), 2017.

[Góm17b] Paco Gómez. Medidas de complejidad rítmica (II), 2017.

[HB06] Daniel H Huson and David Bryant. Application of phylogenetic networks in evolutionary studies. Mol Biol Evol, 23(2):254–267, 2006.

[LHC84] H.C. Longuet-Higgins and C.S. The rhythmic interpretation of monophonic music. Music Perception, 1:424–441, 1984.

[PE85] D. Povel and P. Essens. Perception of temporal patterns. Music Perception, 2:411–440, 1985.

[SP00] I. Shmulevich and D.-J. Povel. Measures of temporal pattern complexity. Journal of New Music Research, 29(1):61–69, 2000.

[Thu08] Eric Thul. Measuring the complexity of musical rhythm. Master’s thesis, McGill University, Canada, 2008.

[Vin10] Louis Nicholas Vinke. Factors affecting the perceived rhythmic complexity of auditory rhythms. Master’s thesis, Bowling Green State University, United States of America, 2010.

[Vir17] Tyler Virgen. Spurious Correlations. http://www.tylervigen.com/spurious-correlations, consultado en diciembre de 2017.

[Wik17] Wikipedia. Correlation and dependence. https://en.wikipedia.org/wiki/Correlation_and_dependence, consultado en diciembre de 2017.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Introducción

Este es el segundo artículo de la serie sobre medidas de complejidad rítmica. En el primer artículo [Góm17] se presentaron las principales preguntas alrededor de la cuestión de cómo medir la complejidad rítmica y se pasó a revista a unas cuantas medidas (las medidas métricas, las medidas basadas en patrones y las medidas basadas en distancias). En la columna de hoy continuaremos con el examen de las medidas formales de complejidad; en particular, estudiaremos las basadas en la entropía de la información, las basadas en los histogramas de intervalos entre notas consecutivas y las llamadas de irregularidad matemática, que incluirán el índice de asimetría rítmica y la medida de contratiempo. En la siguiente columna estudiaremos cómo medir la bondad de todas esas medidas desde distintos puntos de vista, pero pondremos especial énfasis en la evaluación perceptual de las medidas.

2. Entropía de la información

2.1. La medida H de complejidad

Las medidas de complejidad rítmica de esta sección se basan en la idea de la entropía definida por Shannon [Sha48]; la entropía también se llama incertidumbre de la información. Este es un concepto que aparece en varias disciplinas científicas tales como la termodinámica, la mecánica estadística y por supuesto la teoría de la información. La idea que subyace debajo de la definición es que las palabras más inesperadas son las que más información aportan. La idea de lo inesperado es formalizado a través de las distribuciones de probabilidad de modo que lo más inesperado tiene menos probabilidad. Supongamos que X e Y son dos variables aleatorias discretas con distribuciones de probabilidad p(x) y p(y), respectivamente. Se define la entropía H(X) por la expresión

Se supone que 0 ⋅ log 2(0) = 0. Si p(x,y) es la probabilidad del vector aleatorio (X,Y) su entropía conjunta es

La medida H de la complejidad rítmica se basa en modelos de percepción de estímulos binarios [VT69]. Los ritmos se pueden ver como un estímulo binario, una nota o un silencio. La medida construye un espacio de probabilidad sobre el conjunto de ritmos de manera recursiva y luego aplica las fórmulas de arriba para obtener la entropía. Los detalles son un tanto técnicos y nos conformaremos con esta breve descripción. Para más información, véase las páginas 29 a 36 de la tesis de Thul [Thu08].

2.2. Codificación de Lempel-Ziv

La complejidad rítmica se puede medir en términos de la capacidad de compresión del ritmo en particular. En efecto, la idea que subyace debajo es que si un ritmo es muy complejo se podrá comprimir poco y si es poco complejo admitirá un alto grado de compresión. Este enfoque, como es claro, pertenece a la teoría de la información. Pero ¿cómo se comprime la información? Uno de los algoritmos más populares es el de Lempel-Ziv [LZ76]. Este algoritmo toma una secuencia (que puede ser un texto o en nuestro caso un ritmo) y lo analiza de izquierda a derecha. A partir de ese análisis construye un diccionario que contiene el vocabulario necesario para describir la secuencia entera. Por ejemplo, si la secuencia es (aa), el diccionario estará formado por la expresión an, donde aquí la potencia significa la concatenación de la letra a n veces. Como se puede ver, dado que la secuencia es muy simple, su diccionario es muy corto. Sin embargo, la cadena r = 0001101001000101 tiene como diccionario D = , que tiene tamaño 6, y que es más largo que el de la secuencia an. La complejidad de ese ritmo sería 6. Los detalles de la construcción también en este caso revisten cierto carácter técnicos y hemos optado por remitir al lector interesado a la sección 3.4.4 de la tesis de Thule [Thu08] o también al artículo de Lempel-Ziv [LZ76].

3. Histogramas de las duraciones de las notas

Los histogramas se han usado en Estadística largamente como forma de resumir y visualizar información, especial una gran cantidad de datos, de manera que su interpretación fuera más fácil y efectiva. Un histograma está formada por una serie de rectángulos o barras cuya superficie es proporcional a la frecuencia de los valores asociados a cada barra.

En teoría de la música, los intervalos de duraciones entre notas consecutivas (IDNC) es el número de pulso que hay entre ambas. Aquí se está suponiendo implícitamente que el pulso es una unidad mínima en el ritmo y que aquel no admite subdivisiones. En la mayoría de los casos es posible suponer la existencia de tal pulso mínimo. Los histogramas se pueden calcular con IDNCs locales o IDNCs globales. Los IDNCs locales no son más que los intervalos obtenidos entre dos notas consecutivas del ritmo. Por ejemplo, para la clave son, de ritmo [x . . x . . x . . . x . x . . .], su histograma es el que muestra la figura 1; a la izquierda de la figura se ve la representación de este ritmo sobre el círculo. Las duraciones de este ritmo son (3, 3, 4, 2, 4).

Figura 1: Histogramas locales de los intervalos de duraciones entre notas consecutivas (figura tomada de [Thu08])

Los histogramas globales de los IDNCs, en cambio, consideran todos los intervalos que se generan entre todos los pares de notas posibles. Si el ritmo tiene k notas, entonces ese número es (k 2) = . La figura 2 muestra el histograma global para la clave son. Este ritmo tiene 5 notas y 10 posibles intervalos entre pares de notas, que son (3,3,4,2,4,7,6,7,6,6).

Figura 2: Histogramas globales de los intervalos de duraciones entre notas consecutivas (figura tomada de [Thu08])

3.1. Desviación estándar de los INCDs

La desviación estándar de un conjuntos de datos es una medida de dispersión respecto a la media. La media, a su vez, es una medida de centralización. Si los datos son , entonces la media x se define como

y la desviación estándar dv como

La desviación estándar hace un promedio de los errores cuadráticos cometidos al sustituir cada dato por la media. Cuando la desviación es cero, implica que todos los datos son iguales entre sí y los datos alcanzan la máxima homogeneidad. Según la desviación típica se hace más grande, los datos se vuelven más homogéneos. La desviación típica se puede ver cómo una medida de cuán representativa es la media respecto al conjunto de datos. Cuando se usa en este sentido se suele complementar con el coeficiente de variación, que se define como . Este coeficiente, normalmente expresado como un porcentaje, nos da la cantidad de dispersión por unidad de media.

Para la medida de la complejidad rítmica, se considera que un ritmo que tiene baja desviación estándar tiene poca complejidad. Tendrá pocos valores diferentes para los INDCs. En cambio, si su desviación estándar es alta, esto significará que hay mucha diversidad de valores de los INDCs. No se le escapa al lector que está medida tendrá sus limitaciones, como mostrarán los experimentos, pues no siempre la variedad de duraciones implicará una complejidad intrínseca de los mismos. La desviación estándar se puede calcular tanto para los histogramas locales como los histogramas globales.

3.2. Entropía de la información sobre los histogramas

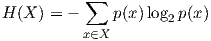

El histograma de un conjunto de datos siempre da lugar a una distribución de probabilidad. Si hay n datos, cada dato tiene probabilidad 1∕n de aparecer. Si un dato aparece k veces, su probabilidad será k∕n. Siendo esto así, se puede aplicar todas las ideas desarrolladas más arriba sobre la teoría de la información, esto es, usando la fórmula H(X) = -∑x∈X p(x)log2 p(x), donde X es la distribución dada por los histogramas.

4. Irregularidad matemática

Las medidas que estudiaremos en esta sección tienen su base en ideas matemáticas. Constituyen las ideas más formales de todas las presentadas hasta ahora. En otro contexto similar, la medida de síncopa, estudiamos las dos medidas siguientes, el índice de asimetría rítmica y la medida de contratiempo; véanse las columnas de octubre a diciembre de 2011 [Góm11a, Góm11b, Góm11c].

4.1. Índice de asimetría rítmica

Simha Arom [Aro91] descubrió que los pigmeos aka usan ritmos que tienen lo que él llama la propiedad de asimetría rítmica [CT03, Che02]. Un ritmo con un tramo temporal consistente en un número par de unidades de tiempo tiene la propiedad de asimetría rítmica si no hay dos notas que partan el ciclo (el tramo temporal entero) en dos subintervalos de igual longitud. Tal partición se llama un bipartición igual. Nótese que la propiedad de asimetría rítmica se define solo para tramos temporales de longitud par. Para tramos de longitud impar todos los ritmos tiene esa propiedad, lo que desprovee a la medida de todo interés. Aunque limitada, esta propiedad es un primer paso hacia una definición matemática de la complejidad rítmica.

Toussaint [Tou03] propuso una generalización de esta propiedad que tenía más capacidad de discriminación. Originalmente, Simha Arom [Aro91] definió la propiedad de asimetría rítmica de una manera estrictamente dicotómica, blanco o negro, todo o nada, esto es, el ritmo o tiene la propiedad o no la tiene. Este concepto se puede generalizar a una variable que tome más valores y que mida la cantidad de asimetría rítmica que un ritmo posee. Esta variable de asimetría rítmica se define como el número de biparticiones iguales que admite un ritmo. Cuantas menos biparticiones un ritmo admita, más asimetría rítmica tendrá. La medida de asimetría se concibe entonces como una medida de complejidad rítmica.

4.2. La medida de contratiempo

Consideremos en primer lugar los ritmos definidos sobre un tramo temporal de 12 unidades de tiempo. Un intervalo de 12 unidades se puede dividir de manera exacta, sin resto, por cuatro números mayores estrictamente que 1 y menores que 12. Estos números son 6, 4, 3 y 2. Dividir el círculo de 12 unidades por estos números da lugar a un segmento, un triángulo, un cuadrado y un hexágono, respectivamente. Normalmente, la música africana incorpora un tambor u otro instrumento de percusión que toca al menos una porción de estos patrones. A veces la música se acompaña con ritmos de palmas que usan alguno de estos patrones. Por ejemplo, la musica funeral neporo del noroeste de Ghana emplea el triángulo, el cuadrado y el hexágono en sus ritmos de palmas [Wig98]. En cualquier caso, el ritmo tiene un pulso que podemos asociar con la posición “cero” en el ciclo. En la música polirrítmica estos cuatro subpatrones forman los posibles patrones métricos. Dos de estos patrones, el segmento y el cuadrado, son binarios y dos, el triángulo y el hexágono, ternarios. En la figura 3 se muestra las subdivisiones dadas por los divisores de 12 para los ritmos bembé y la clave son. El primero es ternario y es [x . . x . x x . x . x . x] y el segundo es binario y se describe como [x . . x . . x . . . x . x . . .].

Figura 3: La medida de contratiempo (figura tomada de [Thu08])

Por tanto, las notas que se tocan en otras posiciones están en posiciones de contratiempo en un sentido fuertemente polirrítmico. Hay cuatro posiciones que no aparecen en ninguno de estos cuatro patrones. Esas posiciones son 1, 5, 7 y 11. Las notas en esas posiciones se llamarán notas a contratiempo. Un ritmo que contenga al menos una nota en una de esas posiciones se dirá que tiene la propiedad del contratiempo. La medida de contratiempo es el número de notas a contratiempo que contiene. Estas notas a contratiempo (1, 5, 7, y 11) tienen una interpretación en términos de teoría de grupos. Las 12 posiciones para las 12 posibles notas forman un grupo cíclico de orden 12 designado por C12. Los valores de las posiciones de las notas a contratiempo corresponden a los tamaños de los intervalos que tienen la propiedad de que, si se recorre el ciclo empezando en “cero” en sentido horario en saltos de tamaño igual al tamaño de uno de estos intervalos, entonces en algún momento se vuelve al punto de inicio tras haber visitado todas las 12 posiciones. Recíprocamente, si las longitudes de los saltos se toman del conjunto complementario , entonces el punto de inicio se alcanzará sin haber visitado las 12 posiciones del ciclo. Por esta razón, los elementos 1, 5, 7 y 11 se llaman generadores del grupo C12

Los números que indican la posición de las notas a contratiempo en el ciclo también tienen una interpretación desde el punto de vista de la teoría de números. Consideremos un tramo temporal de n unidades. Las posiciones de las notas a contratiempo se conocen como coprimos de n (véase[CG96]) . Los coprimos de n son los enteros positivos menores que n que son primos relativos con n. Dos números son primos relativos si el único divisor que tienen en común es 1. La función indicatriz de Euler, designada por ϕ(n), es el número de coprimos de n, y es por tanto el valor máximo que la medida de contratiempo puede tomar para un ritmo con un tramo temporal de n unidades.

Ya que cada grupo cíclico Cn tiene un conjunto de generadores, la medida de contratiempo descrita se puede generalizar a ritmos definidos sobre tramos temporales de n unidades, donde n puede tomar otros valores distintos a 12. Aunque la medida funciona mejor con valores pares de n, tiene alguna aplicabilidad para valores impares de n. Por otra parte, si n es un número primo p, entonces todos los números entre 1 y p - 1 son coprimos con p. En tal caso la medida es infructuosa, ya que todas las posiciones entre 1 y p - 1 serían notas a contratiempo bajo la presente definición de contratiempo.

5. Conclusiones

En este artículo hemos presentado medidas métricas y medidas basadas en patrones y medidas basadas en distancias para la complejidad rítmica. Como ha podido comprobar el lector, los enfoques son muy distintos y producen a su vez resultados también distintos. Queda para los siguientes artículos estudiar su validación perceptual.

Bibliografía

[Aro91] Simha Arom. African Polyphony and Polyrhythm. Cambridge University Press, Cambridge, England, 1991.

[CG96] J. H. Conway and R. K. Guy. Euler’s Totient Numbers. The Book of Numbers, pages 154–156, 1996.

[Che02] Marc Chemillier. Ethnomusicology, ethnomathematics. The logic underlying orally transmitted artistic practices. In G. Assayag, H. G. Feichtinger, and J. F. Rodrigues, editors, Mathematics and Music, pages 161–183. Springer-Verlag, 2002.

[CT03] Marc Chemillier and Charlotte Truchet. Computation of words satisfying the “rhythmic oddity property” (after Simha Arom’s works). Information Processing Letters, 86:255–261, 2003.

[Góm11a] Paco Gómez. Medidas matemática de síncopa (I), 2011.

[Góm11b] Paco Gómez. Medidas matemática de síncopa (II), 2011.

[Góm11c] Paco Gómez. Medidas matemática de síncopa (III), 2011.

[Góm17] Paco Gómez. Medidas de complejidad rítmica (I), 2017.

[LZ76] A. Lempel and J. Ziv. On the complexity of finite sequences. IEEE Transactions on Information Theory, 22(1):75–81, 1976.

[Sha48] C.E. Shannon. A mathematical theory of communication. The Bell System Technical Journal, 27:623–656, 1948.

[Thu08] Eric Thul. Measuring the complexity of musical rhythm. Master’s thesis, McGill University, Canada, 2008.

[Tou03] Godfried T. Toussaint. Classification and phylogenetic analysis of African ternary rhythm timelines. In Proceedings of BRIDGES: Mathematical Connections in Art, Music and Science, pages 25–36, Granada, Spain, July 23-27 2003.

[VT69] P. C. Vitz and T. C. Todd. A coded element model of the perceptual processing of sequential stimuli. Psycological Review, 75(6):443–449, 1969.

[Wig98] Trevor Wiggins. Techniques of variation and concepts of musical understanding in Northern Ghana. British Journal of Ethnomusicology, 7:117–142, 1998.

|

|

Cultura y matemáticas/Música y matemáticas

Autor:Paco Gómez Martín (Universidad Politécnica de Madrid)

1. Medidas de complejidad rítmica

El artículo de este mes inaugura una serie sobre el apasionante tema de las medidas de complejidad rítmica. El material que se presenta en esta serie recoge, de forma divulgativa, el trabajo de autores que han investigado preguntas tales como: dados dos ritmos, ¿cuál de ellos es más complejo?; si el lector es capaz de designar un cierto ritmo como más complejo que otro, ¿puede describir los criterios que rigieron su elección?; ¿depende la complejidad rítmica de la métrica o del agrupamiento?; ¿qué determina la complejidad rítmica?; ¿es una medida asociada intrínsecamente a la estructura del ritmo o depende de la percepción del oyente?; ¿depende la complejidad rítmica de la enculturación del oyente?; ¿lo que es sencillo rítmicamente en una cultura es complejo en otra?; ¿existen universales de complejidad rítmica? Hay más preguntas que se han hecho en la investigación sobre la complejidad rítmica, pero creemos que esta muestra es suficientemente ilustrativa. En esta serie vamos a pasar revista a las medidas de complejidad rítmica más importantes. Seguiremos en buena parte la excelente tesis de maestría de Eric Thul [Thu08]. Primero, empezaremos con las medidas basadas en síncopas, las basadas en patrones y las basadas en distancias. Parte del material que se presenta en este artículo ya fue tratado en 2011 en esta misma revista en la serie Medidas matemáticas de la síncopa; véase [Góm11a, Góm11b, Góm11c]. Dada la distancia en el tiempo y que en esta serie se aborda un problema mayor que en la serie de 2011, consideramos que el lector no se aburrirá.

Por medidas de complejidad rítmica queremos decir medidas formales, esto es, medidas definidas desde un punto de vista teórico. Dependiendo del enfoque conceptual, la medida presentará unas u otras características. Si se mira desde un punto de vista computacional, por ejemplo, se puede pensar en la complejidad de Kolmogorov [LV97]; esta medida se define como el programa más corto que, dada una cadena, hay que escribir para producir como salida dicha cadena. Un experto en teoría de la información diría que la entropía de Shannon, que describe la complejidad como la longitud de la representación más pequeña posible de un mensaje (ritmo, en nuestro caso). Quizás el lector no haya pensado que la complejidad rítmica se pueda medir desde estas perspectivas tan inusuales. Falta de perspectiva es lo único que no está ausente en este tema: Lloyd compiló 42 medidas de complejidad y su artículo se llama Medidas de complejidad: una lista no exhaustiva [Llo01]. No cabe duda de que la complejidad rítmica tiene muchos ángulos desde que atacar su definición.

Aunque algunos psicólogos a principio de siglo se habían interesado por el problema de la complejidad rítmica (Stetson en 1905 y Weaver en 1939), no fue hasta los años 60 en que los psicólogos empezaron a aplicar la entropía de Shannon en sus estudios que el tema empezó a despertar verdadero interés en la investigación. La entropía de Shannon se puede considerar como la cantidad de información promedio que contienen los símbolos usados; véase, por ejemplo, el trabajo de Vitz y Todd de 1969 [VT69]. A partir de los años ochenta, con los trabajos de Essens, Povel y Schumulevich, se empezó a considerar la necesidad de la validación perceptual , esto es, de que seres humanos validaran perceptualmente la complejidad de las medidas y no solo por su estructura interna; véanse [PE85, Ess95, SP00]. Para un discusión de la variedad de medidas de complejidad y las disciplinas que se han interesado por esta cuestión, véase la introducción de la tesis de maestría de Thul [Thu08], páginas 3 y 4.

La intención de esta serie es mostrar cómo funcionan las medidas de complejidad más importantes, cómo se han evaluado y compararlas entre sí. Respecto a la bondad de las medidas, haremos hincapié en la evaluación perceptual así como en su comparación en diversas tradiciones musicales.

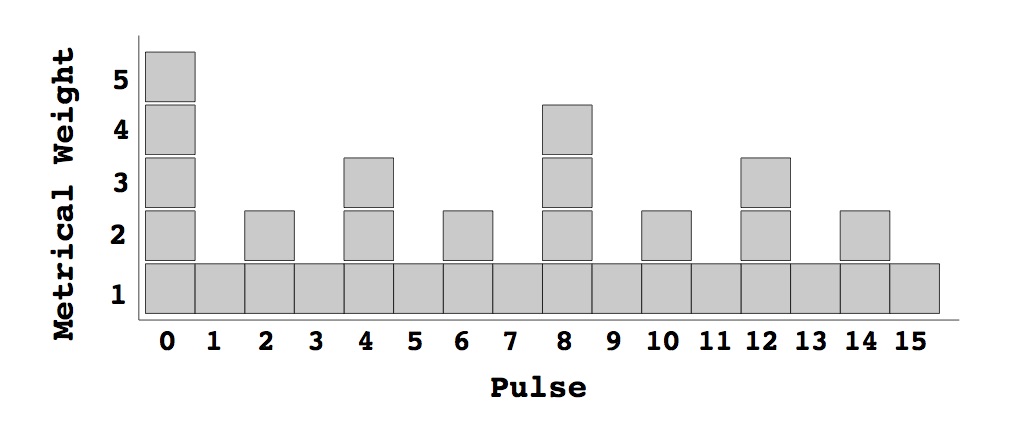

2. Medidas métricas

2.1. La medida de complejidad métrica de Toussaint

Las medidas que se presentan en esta sección se inspiran en las gramática generativa de la música de Lerdahl y Jackendoff [LJ83]; en su momento dedicamos a su libro Una teoría generativa de la música una serie de título homónimo [Góm14]. En particular, se basan en la jerarquía métrica de pesos, que consiste en asignar un peso a cada subdivisión o pulso del compás en función de su importancia métrica. La importancia métrica se define en función de los divisores del número total de pulsos del ritmo. Para ilustrar esto, consideremos un compás con 16 partes numeradas de 0 a 15, como en la figura de abajo. La posición 0 recibe peso 1 cuando se considera que el compás contiene una redonda. En ninguna otra posición puede empezar una redonda sin salirse del compás. Las posiciones 0 y 8 reciben peso 1 cada una porque en ellas se puede poner una blanca. Las posiciones 0, 4, 8, 12 reciben peso 1 cada una porque pueden albergar las negras. Las posiciones pares reciben 1 cada una porque pueden contener corcheas. Por último, todas las posiciones reciben peso 1 porque en cualquiera se puede poner una semicorchea. El peso final de una posición es la suma de los pesos que ha recibido.

Figura 1: Jerarquía métrica de pesos (figura tomada de [Thu08])

Ahora dado un ritmo la complejidad métrica de Toussaint o simplemente la complejidad métrica es la suma de los pesos de las posiciones en que se encuentran las notas de ese ritmo. Por ejemplo, el ritmo [x . . x . . . x . . x . x . . . ], donde x denota una nota y el punto un silencio, tiene notas en las posiciones 0, 3, 7, 10 y 12. Entonces, su complejidad rítmica es 5+1+1+2+3=12. La idea de esta medida es que la complejidad del ritmo está asociada a la complejidad métrica.

Al lector no se le habrá escapado que el ejemplo que hemos puesto con un número de pulsos igual a 16 es un caso muy fácil. En realidad, los pesos de la jerarquía métrica dependen de los divisores del número de pulsos. Con 16 = 2 ⋅ 2 ⋅ 2 ⋅ 2 la jerarquía es única porque la factorización de 16 es única. Por ejemplo, con 12 no es así. El número 12 se puede escribir como 2 ⋅ 2 ⋅ 3, 2 ⋅ 3 ⋅ 2 y 3 ⋅ 2 ⋅ 2 y ello da lugar a tres jerarquías métricas, como muestra la figura de abajo.

Figura 2: Jerarquía métrica de pesos para 12 pulsos (figura tomada de [Thu08])

En este caso la medida de un ritmo es la media de las medidas en cada jerarquía métrica.

Esta medida tal cual fue presentada inicialmente sufría carencias. Dado que es una medida aditiva, ritmos con más notas serán más complejos que ritmos con menos notas. Varias normalizaciones respecto al número de notas del ritmo y el número de pulsos del compás se han propuesto para corregir esta situación. Por otro lado, la medida premia las notas en las posiciones métricas fuertes, pero no está claro que la complejidad dependa intrínsecamente de pulsos en esas posiciones.

Palmer y Krumhansl [PK90] estudiaron empíricamente la cuestión de los pesos de la jerarquía métrica. Llevaron a cabo experimentos con músicos y no músicos para determinar el peso de cada pulso para varios compases. Estos pesos se han usado para modificar la medida de Toussaint y hacer que su diseñe se base en datos perceptuales.

2.2. La medida de Longuet-Higgins y Lee

La medida de Longuet-Higgins y Lee (LHL a partir de ahora, por brevedad) es una medida también inspirada en los niveles métricos, como la medida de Toussaint. Los niveles métricos se representan mediante una estructura de árbol que se construye recursivamente. Sea n el número de pulsos que tiene el ritmo. Se factoriza n y se consideran los factores primos de n. Sea p un factor primo de n y ℓ el nivel del árbol que estamos construyendo actualmente. A continuación se genera un árbol con las siguientes reglas:

Para todos los nodos m a nivel ℓ, créense p hijos con padre común m.

Increméntese ℓ en 1.

Elimínese p de la lista de primos y procésese el siguiente factor primo en la lista.

Si n = 16, como en el ejemplo anterior, el árbol resultante es el que aparece en la parte de arriba de la figura 4 (el árbol sin pesos). El siguiente paso es agregar los pesos a esta jerarquía métrica. La manera de hacerlo es como sigue. El índice ℓ indica el nivel de la jerarquía métrica y empieza con ℓ = 1. Consideremos las hojas o nodos finales del árbol, y numerémoslos de 0 a 15. Inicializamos todas las hojas a cero. Siempre restamos uno a las hojas, excepto cuando i es cero o i es múltiplo de n/ℓ. Después de procesar el árbol con ℓ = 1, asignamos a ℓ el valor del producto del valor actual de ℓ por el primer factor primo de la factorización de n. Se vuelven a asignar los pesos a este nivel. Se multiplica por el siguiente factor primo y continuamos hasta que todos los factores primos son procesados. El valor final del peso de cada hoja es la suma de los pesos en cada uno de los pasos anteriores. En la figura de abajo aparecen los pesos para el ejemplo con n = 16.

Índice

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

ℓ = 1

0

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

ℓ = 2

0

-1

-1

-1

-1

-1

-1

-1

0

-1

-1

-1

-1

-1

-1

-1

ℓ = 3

0

-1

-1

-1

0

-1

-1

-1

0

-1

-1

-1

0

-1

-1

-1

ℓ = 4

0

-1

0

-1

0

-1

0

-1

0

-1

0

-1

0

-1

0

-1

ℓ = 5

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

Suma

0

-4

-3

-4

-2

-4

-3

-4

-1

-4

-3

-4

-2

-4

-3

-4

Figura 3: Construcción de los pesos en el árbol de jerarquía métrica de la medida LHL

El segundo árbol de la figura 4 muestra los pesos finales en las hojas. Obsérvese que los pesos todavía son mayores en las posiciones métricamente fuertes, aunque tomen valores negativos.

Figura 4: Jerarquía métrica de la medida LHL (figura tomada de [Thu08])

De nuevo, cuando n no tiene una factorización única se producen varios árboles con diversas jerarquías métricas. La distancia LHL final será una distancia ponderada entre las distintas jerarquías métricas. La figura 5 muestra las jerarquías métricas asociadas a n = 12.

Figura 5: Jerarquía métrica de la medida LHL (figura tomada de [Thu08])

Una vez que la jerarquía métrica y los pesos se han generado, dado un ritmo, la complejidad métrica LHL se calcula examinando los pulsos que tienen silencio y que tienen un peso mayor que la nota inmediatamente anterior. Si estamos procesando el pulso i de un ritmo y este resulta ser un silencio, buscamos la nota inmediatamente anterior a él. Sea j el índice donde tal nota se halla. Si wi,wj son los pesos de los pulsos i y j, respectivamente, entonces el peso del pulso i es la cantidad wi -wj. En el resto de los pulsos los pesos valen cero. La medida LHL es la suma de todos los pesos de los pulsos del ritmo.

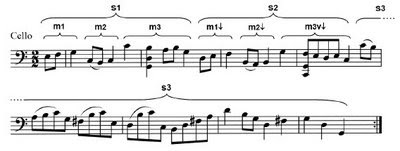

En la figura 6 se el cálculo de la medida LHL para el ritmo soukous [x . . x . . x . . . x x . . . . ]. Los pulsos en que se producen pesos positivos son en 4, 8 y 12. Como se puede apreciar, la nota que precede a esos pulsos tiene un peso métrico menor que el del silencio.

Figura 6: Cálculo de la medida LHL para el ritmo del soukous (figura tomada de [Thu08])

3. Medidas basadas en patrones

3.1. La complejidad cognitiva de Pressing

La idea de Pressing [Pre99] descansa en las jerarquías métricas, pero en la fase final adopta un enfoque de búsqueda de patrones. A partir de los resultados de los patrones determina la medida de la complejidad del ritmo.

Pressing primero crea una jerarquía métrica al estilo de Longuet-Higgins y Lee, dividiendo sucesivamente el número de pulsos. Si n = 16, como la factorización es única, da lugar a una sola estructura métrica, como se muestra en la figura 7; se ha dividido el ritmo acorde a los divisores de n.

Figura 7: Complejidad cognitiva de Pressing para la clave son (figura tomada de [Thu08])

Para medir la complejidad del ritmo, Pressing define unos pesos asociados a cinco tipos de patrones específicos. Usando la terminología de Pressing, llamaremos sub-ritmos a los patrones que se encuentran en un determinado nivel métrico. Por ejemplo, en la figura anterior el segundo nivel tiene dos sub-ritmos; el tercero, cuatro, y así sucesivamente.

En la figura 8 se ven los patrones básicos que definió Pressing para su medida para el tercer nivel (nivel (c) en la figura). Estos patrones reciben los nombres de: a) patrón de relleno; b) patrón continuo; c) patrón de parte fuerte; d) patrón de subparte fuerte; e) patrón de síncopa; f) patrón nulo. Los pesos para cada patrón son, respectivamente, 1, 2, 3, 4, 5, y 6. Pressing da una definición de estos patrones para todos los niveles posibles, pero aquí solo hemos mostrado la del tercer nivel.

Figura 8: Patrones básicos en la complejidad cognitiva de Pressing

La medida es una media ponderada de los patrones que se suman a todos los niveles de la descomposición del ritmo.

Pressing no justificó la asignación de los pesos a estos patrones, lo cual le restó aceptación. Otro inconveniente es que Pressing solo definió la medida para ritmo binarios. No obstante, es posible definirla para ritmos ternarios y para un número de pulsos que no tenga factorización única (por vía de una media ponderada de las distintas medidas de cada descomposición del ritmo).

3.2. La complejidad de Keith

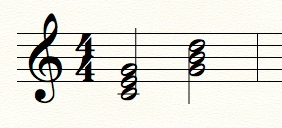

En [Kei91] Keith examina varios fenómenos de naturaleza rítmica y lleva a cabo un análisis matemático de ellos. Como ejemplo ilustrativo, Keith aborda el problema de medir el grado de síncopa de un ritmo dado. Su definición se apoya en la distinción de tres eventos: retardo, cuando una nota empieza en parte fuerte1 y termina fuera de ella; anticipación, cuando la nota empieza fuera de parte y termina sobre parte fuerte; y síncopa, que se concibe como una combinación de los dos eventos previos (véase la figura 9; de izquierda a derecha: retardo, anticipación y síncopa).

Figura 9: Retardo, anticipación y síncopa.

De manera algo arbitraria, Keith asigna valores de 1 al retardo, de 2 a la anticipación y de 3 a la síncopa. Esta asignación parece, por lo menos, subjetiva y el propio Keith reconoce que “el problema de decidir la “fuerza” rítmica relativa del retardo, la anticipación y la síncopa es un interesante problema filosófico”.

La medida de Keith se limita a métricas compuesta de n pulsos, donde n es una potencia de 2. Vamos a dar su definición detallada con el fin de entender esta limitación. Su idea principal es que, dadoa un evento musical (una nota), para saber si está en parte fuerte o no hay que compararla con una plantilla métrica, que indica las partes fuertes y débiles según el tamaño (duraciones) del evento. Por ejemplo, si la potencia de 2 es 3, entonces habrá 23 = 8 corcheas y las plantillas de partes fuertes y débiles se ilustra en la tabla abajo (F es para la parte fuerte y D para la débil).

F

D

D

D

D

D

D

D

F

D

D

D

F

D

D

D

F

D

F

D

F

D

F

D

F

F

F

F

F

F

F

F

Figura 10: Diferentes niveles métricos en la definición de síncopa de Keith.

Un evento de tamaño 8 se compara con la primera plantilla (léase de arriba abajo). Los eventos de tamaño entre 4 y 7 se comparan con la segunda plantilla; los que van de 2 a 3, con la tercera plantilla; y finalmente, las corcheas, de tamaño 1, con la última plantilla, que solo está formada por partes fuertes. Esta plantilla de partes fuertes y débiles recuerda mucho a las jerarquías métricas de la medida de Toussaint y de Longuet-Higgins y Lee.

Podemos representar un ritmo de n notas por una sucesión circular (s0,s1,…,sn-1). Usaremos también la sucesión de intervalos entre notas (δ0,δ1,…,δn-1), donde δi = si+1 - si, para 0 ≤ i < n. El número δn es igual a L - sn-1, siendo L la longitud del ritmo completo. La localización de las partes fuertes es una función de la longitud del intervalo entre notas consecutivas. Una hipótesis implícita es que la métrica es siempre binaria y que las partes fuertes ocurren en algún múltiplo de una potencia de dos. Para cualquier nota dada si, la partes fuertes adyacentes se pueden describir como j2k y (j + 1)2k, donde k es el entero tal que 2k ≤ δi < 2k+1, y j es el entero tal que j2k ≤ si < (j + 1)2k.

Hagamos un ejemplo que ilustre cómo se calcula la medida de síncopa de Keith para el ritmo de la bossa-nova; véase la figura 11. La bossa-nova tiene la sucesión de notas (0,3,6,10,13,16) y la sucesión de intervalos entre notas (3,3,4,3,3) (hemos incluido el 16 para enfatizar que la última distancia se obtiene entre la última nota del ritmo y la primera). Nótese que la sucesión que damos para la bossa-nova tiene una nota de más para enfatizar el carácter circular de la sucesión. La siguiente tabla muestra los cálculos para obtener 9, el valor de la medida de síncopa, que está dado por la suma de los pesos wi.

0

1

2

3

4

5

si

0

3

6

10

13

16

δi

3

3

4

3

3

wi

1

2

3

1

2

Figura 11: Anotación de los cálculos de la medida de síncopa de Keith para el ritmo de la bossa-nova.

4. Medidas basadas en distancias

4.1. La distancia de permutación

La distancia de permutación dirigida se basa en contar el número mínimo de operaciones para transformar un ritmo dado en otro. Es una generalización de la distancia de Hamming. Esas operaciones se limitan a intercambios de notas o silencios entre posiciones adyacentes y tienen las siguientes restricciones:

Ambos ritmos han de tener el mismo número de pulsos.

Se convierte el ritmo de más notas, R1, al de menos notas, R2.

Cada nota de R1 tiene que moverse a una nota de R2.

Cada nota de R2 ha de recibir al menos una nota de R1.

Las notas no pueden cruzar el final del ritmo y aparecer por el principio.

En la figura 12 se muestra la distancia de permutación dirigida entre dos ritmos flamencos, el fandango y la seguiriya; se pueden apreciar los movimientos de las notas de la seguiriya para transformarse en el fandango. El número de movimientos es mínimo.

Figura 12: La distancia de permutación dirigida entre el fandango y la seguiriya).

La distancia de permutación dirigida es entonces 4.

4.2. La medida ponderada de nota a parte

En la definición de la medida ponderada de nota a parte (DPNP a partir de ahora) medida centramos nuestra atención en los ataques de las notas entre partes fuertes en lugar de la estructura métrica, como hace Keith. Esta medida se basa en el concepto de distancia y es más flexible en cuanto que nos permite cuantificar el nivel de síncopa (de complejidad rítmica) de un amplio abanico de ritmos. Por ejemplo, consideremos los ritmos que se muestran en la figura 13; la medida de Keith no es adecuada para medir ritmos de esta complejidad.

Figura 13: Ritmos que no pueden medirse con la medida de Keith.

Sin embargo, con la medida ponderada de nota a parte sí es posible medirlo; de hecho, tiene valor igual a 41∕8.

La distancia ponderada de nota a parte se define como sigue. En primer lugar, supondremos que cada nota termina donde empieza la siguiente. Sean pi,pi+1 dos partes fuertes de la métrica. Sea sj una nota que empieza después o sobre la parte fuerte pi pero antes de la parte fuerte pi+1; primero definimos T(sj) = mín, donde d es la distancia entre notas en términos de duraciones. Aquí la distancia entre dos partes fuertes se toma como la unidad, y, por tanto, la distancia d es siempre una fracción. Por ejemplo, las negras en un compás de 4/4 son partes fuertes, y, si las notas de la figura 14 se refieren a la parte fuerte más cercana:

Figura 14: Síncopa medida con la medida DPNP.

entonces, las distancias respectivas T(sj) son 1/2, 1/4, 1/4, 1/3, 1/3, 1/5.

En la medida de síncopa de Keith la parte fuerte más cercana a una nota estaba implícita. Para permitir una mayor variedad de ritmo la medida DPNP exige especificar cuales son las partes fuertes. En el ejemplo anterior las partes fuertes están dadas por el compás. Así, en el ejemplo de la figura 13 las partes fuertes se encuentran a intervalos de negra. La medida DPNP está especialmente diseñada para entradas en notación estándar, ya que las partes fuertes se deducen del compás.

La medida DPNP D(sj) de una nota sj se define entonces como sigue: 0, si sj = pi; , si la nota sj ≠ pi termina antes o en pi+1; , si la nota sj ≠ pi termina después de pi+1 pero antes de o en pi+2; y , si la nota sj ≠ pi termina después de pi+2. Sea n el número de notas de un ritmo. Entonces la medida DPNP de un ritmo es la suma D(sj), para todas las notas sj, dividida por n. La tabla de la figura 16 proporciona una lista de los valores DPNP para varios ritmos.

Usaremos la notación que introdujimos antes para representar un ritmo como una sucesión circular, junto con una sucesión de intervalos entre notas y las partes fuertes dadas por el compás para escribir el algoritmo de la medida DPNP. Consideremos una nota si. Esta nota puede empezar en una parte fuerte pj o puede caer entre dos partes fuertes consecutivas. Definimos di como

Ahora asignamos un peso wi a una nota si como sigue:

si si = pj entonces wi ← 0 si pj < si < si+1 ≤ pj+1 entonces wi ← 1∕di si pj < si < pj+1 < si+1 < pj+2 entonces wi ← 2∕di si pj < si < pj+1 < pj+2 ≤ si+1 entonces wi ← 1∕di

Nótese que asignamos el mayor valor de síncopa a una nota si en el caso en que si y si+1 caigan entre dos partes fuertes consecutivas.

En la figura 15 hemos registrado los cálculos para determinar la medida DPNP para el ritmo de la bossa-nova. Nótese que el compás implica que las partes fuertes son las blancas. Esto se traduce en un vector de partes fuertes igual a (0,4,8,12,16). La suma de las D(x) para este ritmo es 20 y da una distancia final de 20∕5 = 4.

0

1

2

3

4

5

si

0

3

6

10

13

16

di

0

1/4

1/2

1/2

1/4

wi

0

2×4

2×2

2×2

1×4

Figura 15: Anotación de los cálculos de la medida DPNP para el ritmo de bossa-nova.